简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

跨域融合加速:AI 安全护栏与卫星通信、量子加密深度融合,构建天地一体化安全防护体系,防范全球范围 AI 安全威胁轻量化部署成主流:借鉴苹果轻量 AI 安全护栏技术,AI 安全产品适配小型终端与卫星设备,无需高性能硬件即可提供高级防护合规驱动市场增长:全球 AI 监管趋严,中国《生成式 AI 管理办法》、欧盟 AI 法案等推动企业强制部署 AI 安全护栏,市场规模年增长达95%生态合作深化:AI

模型开源是 AI 产业技术扩散与生态构建的核心方式,其目的围绕展开,而隐患则集中在等维度,结合具身智能这类融合物理交互的特殊模型,还会衍生出等专属问题。以下从四个维度系统梳理,兼顾通用性与针对性。

模型开源是 AI 产业技术扩散与生态构建的核心方式,其目的围绕展开,而隐患则集中在等维度,结合具身智能这类融合物理交互的特殊模型,还会衍生出等专属问题。以下从四个维度系统梳理,兼顾通用性与针对性。

模型开源是 AI 产业技术扩散与生态构建的核心方式,其目的围绕展开,而隐患则集中在等维度,结合具身智能这类融合物理交互的特殊模型,还会衍生出等专属问题。以下从四个维度系统梳理,兼顾通用性与针对性。

(从单任务到多任务、从结构化到非结构化环境)。2026 年被视为具身智能量产元年,随着成本下降(目标降至 2 万美元以下)和技术成熟,人形机器人有望在特定场景实现规模化应用。核心破局方向包括:合成数据技术弥补数据缺口、模块化硬件降低成本、行业标准加速制定、复合型人才培养体系构建等。(工业、物流、医疗等需求明确、边界清晰的领域)和。

(从单任务到多任务、从结构化到非结构化环境)。2026 年被视为具身智能量产元年,随着成本下降(目标降至 2 万美元以下)和技术成熟,人形机器人有望在特定场景实现规模化应用。核心破局方向包括:合成数据技术弥补数据缺口、模块化硬件降低成本、行业标准加速制定、复合型人才培养体系构建等。(工业、物流、医疗等需求明确、边界清晰的领域)和。

看不到数据是怎么计算的?我们计算的是数据的“加密替身”(密文),但这个替身被赋予了一种特殊的“骨骼结构”或“基因”。当我们按照预先定义好的规则(密文运算)来操纵这些替身时,它们内部结构的变化,恰好对应了原始数据(明文)之间我们想要的实际运算结果。解密过程,就是读取这个最终“结构状态”,并将其翻译回数据域的过程。服务器就像一个在黑暗房间里的机器人,它不知道手里拿的积木(密文)原本是什么形状(明文),

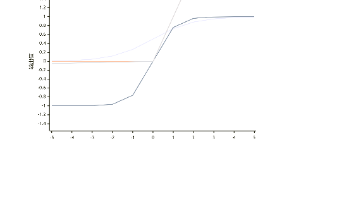

欠拟合像一个学渣,平时作业和考试都很差。问题明显,解决方向明确(让他好好学/换个学法)。过拟合像一个只会死记硬背的“伪学霸”,作业全对,但一考新题就露馅。问题隐蔽,危害性大,解决起来更费劲(需要让他理解原理,而非机械记忆)。因此,在资源有限的情况下,对过拟合保持更高的警惕性通常是更明智的。

互补而非对立:攻击树和攻击链是互补工具。你可以用攻击树来全面识别所有风险(例如,识别出“内部人员威胁”是一个重要路径),然后用攻击链来深入分析其中一种路径(例如,一个恶意内部人员会如何一步步窃取数据)的详细过程。现代框架的融合框架在某种程度上融合了两者的思想。它提供了一个巨大的“战术和技术”知识库(类似于攻击树叶节点的全集),同时又以攻击链的阶段(战术)作为组织方式,描述了攻击者达成每个目标所使用

激活函数公式/规则输出范围主要用途优点缺点Sigmoid(0, 1)输出层(二分类)输出为概率梯度消失,非零中心Tanh(-1, 1)隐藏层(尤其是RNN)零中心,梯度比Sigmoid大梯度消失ReLUmax(0, x)[0, +∞)隐藏层(默认首选)计算快,缓解梯度消失神经元死亡Leaky ReLUmax(αx, x)(-∞, +∞)隐藏层(ReLU替代)解决神经元死亡问题效果不一定总优于ReL