简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

语音聊天APP开发与市场分析:文章指出语音聊天已成为现代社交的重要组成部分,市场需求推动着功能全面的语音聊天APP发展。这类APP具有频道建立、社交互动、语音调节等功能,依托智能移动终端实现便捷操作。其优势在于优化用户体验、提高用户粘性,通过智能化设备支持满足线上社交需求。文章简要介绍了语音聊天APP的开发流程和市场特点。

本文全面介绍了IM即时通讯APP的开发流程,涵盖需求分析、技术选型、系统架构设计等关键环节。从用户功能需求、性能指标到前端后端技术选型,详细解析了如何构建高效稳定的通讯系统。重点阐述了系统架构设计的四大核心:前端交互、后端处理、实时通信和安全防护。同时提供了开发实现、性能优化、运维管理和市场推广的完整方案,并强调持续迭代优化的重要性。通过科学规划和多维度考量,可打造出功能丰富、性能稳定的IM应用,

语音社交应用开发全解析:采用多端适配技术,Android端基于Java+Android Studio,iOS端使用Objective-C+Xcode,服务端采用PHP+ThinkPHP框架。系统包含平台钱包、角色权限、音视频通话等核心功能,支持1-8麦位语音房,提供主播、陪玩等角色认证。通过钻石、布谷币、收益三级币种体系构建完整消费生态,满足用户社交娱乐需求,为开发者提供一站式语音社交解决方案。

请注意,这些命令需要在安装了 FFmpeg 的终端或命令行界面中执行。这条命令从视频文件中提取音频并保存为 AAC 格式,其中。这条命令将 FLAC 文件转换为 Opus 格式,其中。这条命令将 WAV 文件转换为 MP3 格式,其中。这条命令将 MP3 文件转换为 WAV 格式,其中。这条命令将 AAC 文件转换为 MP3 格式,其中。指定音频编码器为 MP3(LAME)。设置音频采样率为 44

本文全面介绍了IM即时通讯APP的开发流程,涵盖需求分析、技术选型、系统架构设计等关键环节。从用户功能需求、性能指标到前端后端技术选型,详细解析了如何构建高效稳定的通讯系统。重点阐述了系统架构设计的四大核心:前端交互、后端处理、实时通信和安全防护。同时提供了开发实现、性能优化、运维管理和市场推广的完整方案,并强调持续迭代优化的重要性。通过科学规划和多维度考量,可打造出功能丰富、性能稳定的IM应用,

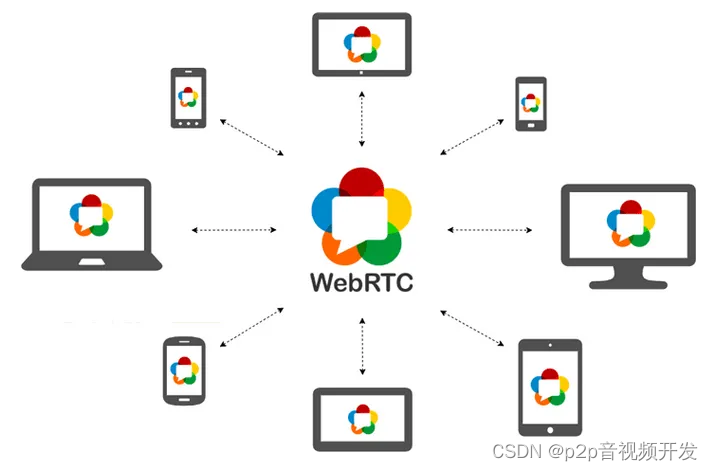

WebRTC(全称 Web Real-Time Communication),即网页即时通信。是一个支持网页浏览器进行实时语音对话或视频对话的技术方案。从前端技术开发的视角来看,是一组可调用的API标准。在WebRTC发布之前,开发实时音视频交互应用的成本是非常昂贵,需要考虑的技术问题很多,如音视频的编解码问题,数据传输问题,延时、丢包、抖动、回音的处理和消除等,如果要兼容浏览器端的实时音视频通

WebRTC(全称 Web Real-Time Communication),即网页即时通信。是一个支持网页浏览器进行实时语音对话或视频对话的技术方案。从前端技术开发的视角来看,是一组可调用的API标准。在WebRTC发布之前,开发实时音视频交互应用的成本是非常昂贵,需要考虑的技术问题很多,如音视频的编解码问题,数据传输问题,延时、丢包、抖动、回音的处理和消除等,如果要兼容浏览器端的实时音视频通信

综上所述,AI视频监控风险识别工具的准确率和误报率是其性能的关键指标。在选择工具时,应关注其准确率和误报率的具体数值,并结合实际应用场景和需求进行评估。同时,随着技术的不断进步和优化,这些指标也有望进一步提升。准确率是衡量AI视频监控风险识别工具性能的重要指标之一。它表示工具正确识别风险事件的比例。高准确率的工具能够更可靠地识别出真正的风险事件,减少漏报情况。误报率是指工具错误地将非风险事件识别为

FFmpeg 默认支持 MP3、WAV、AAC、OGG 等主流格式,可用。以上命令均需在终端执行,且确保已正确安装 FFmpeg 并配置环境变量 。若提示编码器缺失,需安装对应库(如。示例:将 WAV 转为 MP3。)后重新编译 FFmpeg 。

TransPSFrame函数为测试所用,应用时宜将得到的ps头部和帧数据直接写到rtp包中,省去memcpy过程。封装h265和svac音频和svac视频时需要修改SYS_MAP_HEAD[30]和34,见注释和本文开头的宏定义。es_stream.h264文件在下载链接的工程中,文件格式是 4字节帧长度(小端)+ 帧数据。SYS_MAP_HEAD中的数据是按国标ps流标准写死的,如果要封装格式数