简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

这是最好的时代,也是最坏的时代。尽管大模型技术在金融领域具有巨大的应用潜力,但其应用也面临不容忽视的风险和挑战。本文将深入研究大模型在金融领域的数据隐私和安全风险、模型可解释性和透明度、监管和合 规要求,梳理中国、美国、欧洲等地 AIGC 技术的应用规则,探索对应的风险管理和应对策略。当前,金融科技已经从“立柱架梁”迈入了“积厚成势”新阶段,越来越多的金融机构积极使用数字技术来为金融血脉注入全新能

虽然对于大多数人来讲,由于我们的电脑配置等原因,部署本地大模型并且达到很好的效果是很奢侈的一件事情。但是这并不妨碍我们对其中的流程和原理进行详细的了解读者福利:如果大家对大模型感兴趣,这套大模型学习资料一定对你有用如果你是零基础小白,想快速入门大模型是可以考虑的。一方面是学习时间相对较短,学习内容更全面更集中。二方面是可以根据这些资料规划好学习计划和方向。包括:大模型学习线路汇总、学习阶段,大模型

文本到文本应用程序通常属于自然语言处理 (NLP) 的范畴,采用 Transformer 模型或 BERT(Transformers 的双向编码器表示)等复杂算法。在文本摘要的背景下,Rouge Score 或 BLEU(双语评估研究)指标等技术可以评估生成的摘要的质量。对于企业来说,这对于自动总结冗长的报告、从而更快地做出决策来说非常宝贵。文本翻译服务通常采用在并行语料库上接受过培训的领域LLM

大模型是指具有数千万甚至数亿参数的深度学习模型。近年来,随着计算机技术和大数据的快速发展,深度学习在各个领域取得了显著的成果,如自然语言处理,图片生成,工业数字化等。为了提高模型的性能,研究者们不断尝试增加模型的参数数量,从而诞生了大模型这一概念。

这个小册子是关于DeepSeek-R1图解的,主要有三个特点:1)我本人编写,免费开源,PDF专业排版,阅读学习体验更好些2)直观图解,更容易理解大模型基础和DeepSeek-R1的核心创新3)学完小册子能实现本地部署DeepSeek,为后期微调专属推理大模型做铺垫。小册子一共10页,6280字,15幅图。若觉得对你有用,可否点个关注。

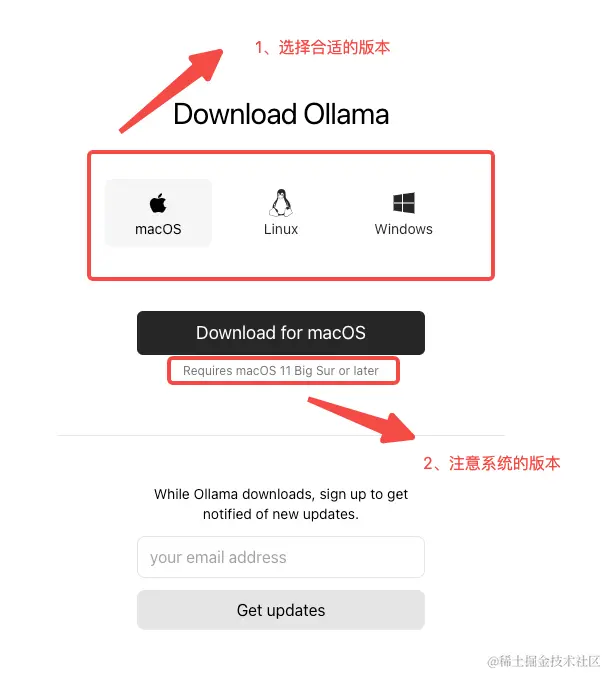

看了那么多chatGPT的文章,作为一名不精通算法的开发,也对大模型心痒痒。但想要部署自己的大模型,且不说没有算法相关的经验了,光是大模型占用的算力资源,手头的个人电脑其实也很难独立部署。就算使用算法压缩后的大模型,部署在个人电脑上,还要忍受极端缓慢的计算速度以及与chatGPT相差甚远的模型效果。前排提示,文末有大模型AGI-CSDN独家资料包哦!有什么办法能够部署属于我们自己的大模型呢?有编程

RAG,即检索增强生成(Retrieval-Augmented Generation),是一种先进的自然语言处理技术架构,它旨在克服传统大型语言模型(LLMs)在处理开放域问题时的信息容量限制和时效性不足。RAG的核心机制融合了信息检索系统的精确性和语言模型的强大生成能力,为基于自然语言的任务提供了更为灵活和精准的解决方案。前排提示,文末有大模型AGI-CSDN独家资料包哦!

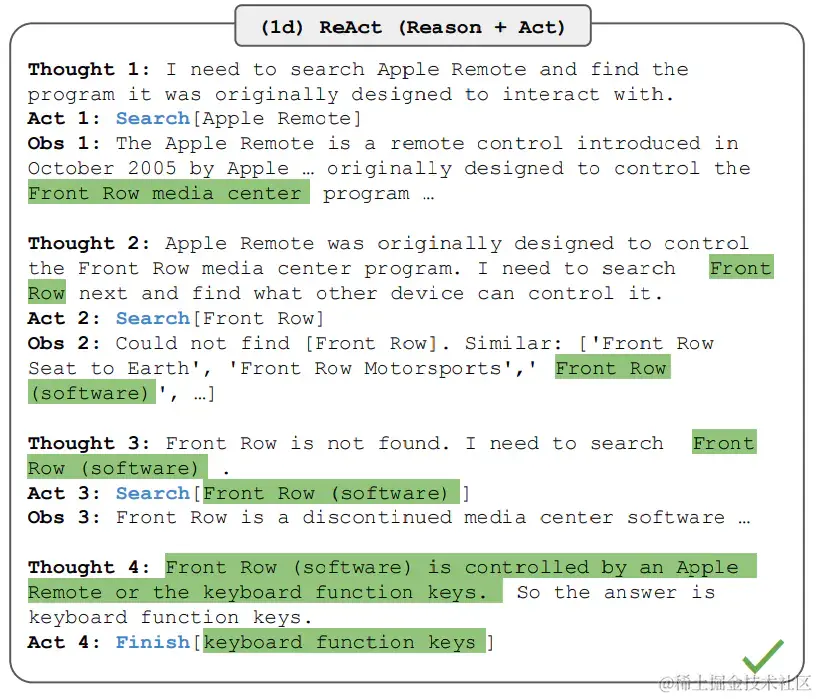

无论是环境的反馈,还是人类的指令,Agent 都需要完成一个对接收到的信息进行“理解”,并依据得到的理解进行意图识别,转化为下一步任务的过程。真正让人惊讶的是大模型在推理上的能力涌现。推理,一般指根据几个已知的前提推导得出新的结论的过程,区别于理解,推理一般是一个“多步骤”的过程,推理的过程可以形成非常必要的“中间概念”,这些中间概念将辅助复杂问题的求解。不同的智能体有不同的推理提示风格、不同的输

对于一位已经拥有多年工作经验职场人来说,进一步学习和发展使用大模型的专业能力可以采取更加聚焦和高效的方式。

许多机构希望使用根据自己的使用场景和品牌习惯而定制的大语言模型。这些模型基于特定领域的数据进行定制,让企业有机会改善内部运营并提供全新客户体验。定制模型比通用大语言模型更小、更高效、更快。对于涉及大量专有数据的应用,定制模型提供了最佳解决方案。定制大语言模型的一个例子是 BloombergGPT,它由 Bloomberg 自主开发,拥有 500 亿个参数,专门针对金融应用。