简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

《动手学大模型》系列编程实践教程,由上海交通大学2024年春季《人工智能安全技术》课程(NIS3353)讲义拓展而来(教师:张倬胜),旨在提供大模型相关的入门编程参考。通过简单实践,帮助同学快速入门大模型,更好地开展课程设计或学术研究。今天分享一个上海交大的免费的大模型课程,有相关教程文档和Slides,目前是2.2K星标,还是挺火的!

伴随DeepSeek等大模型技术的爆发式发展,“人工智能+”浪潮正全面席卷各行业,不仅推动产业升级进程提速,更催生出海量AI相关岗位需求。在此背景下,AI人才争夺战已然进入白热化阶段,且战火已全面蔓延至2026届高校毕业生招聘市场,成为当下程序员群体及IT小白不可错过的职业风口。近日,前程无忧51job发布的《2026届校招市场AI人才需求报告》明确指出,高科技企业已成为AI人才需求的绝对主力军,

文章指出AI大模型应用开发领域竞争不高,适合面临职场危机的程序员转型。转型需掌握基本开发技能、深度学习基础、大模型架构知识等。建议从数学基础、Python编程、深度学习框架和主流大模型机制等方面系统学习,并建议寻求专业指导以少走弯路,提升职场竞争力。

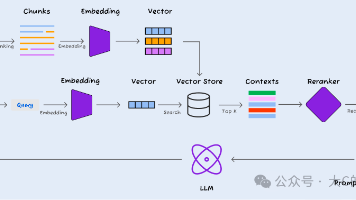

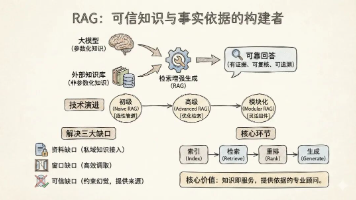

本文分享了企业知识库智能问答系统的RAG技术实践历程,通过系统化优化方法将准确率从初期的30%提升到90%。文章介绍了如何优化召回策略(Vector Search+Rerank)、选择生成模型(Qwen2.5-7B)以及产品设计策略,构建了无需复杂模型精调的高准确性RAG系统。强调了系统化评测方法、性能与成本平衡、产品设计优化对LLM应用落地的重要性。

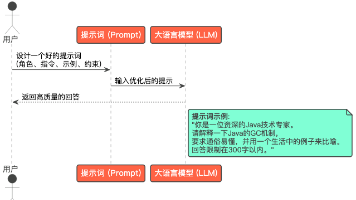

LLM语言大模型的原理就是它根据我们的输入,经过计算,得出一个概率最大的结果。想象你正在玩一个超级智能的“文字接龙”游戏输入一句话(比如“今天天气”),模型会像预测下一个词一样,疯狂计算“好”“真”“很”等词出现的概率,最终选最可能的一个(比如“好”)不断重复:把“好”拼回去,变成“今天天气好”,再预测下一个词(比如“啊”),直到生成完整句子。

站在现在回头看,会发现一个特别真实的现象:AI大潮席卷两年,流量风口在变、招聘JD在变、各家大模型天天迭代更新,这两年里,我带过一大批想转行AI的同学,亲眼陪着他们走完一整条路:从最开始雄心壮志想冲大模型,到中途迷茫卡壳不知道学什么,再到第一次跑通完整可用的系统,最后成功拿到第一份AI相关offer。有些经验,只有踩过无数坑才能真正悟透;有些教训,网上的资料永远不会直白告诉你;还有一些认知,是我做

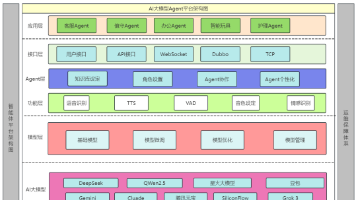

RAG、Workflow与Agent三大技术范式已形成清晰的演进路径与协同范式,是企业开启深度、可靠智能化的成熟工具箱。它们共同定义了下一代企业应用的标准:从 “被动应答” 走向 “主动执行” ,从 “闲聊模式” 走向 “生产模式”。企业在构建此类系统时,应围绕三项核心维度进行权衡与设计:可控性、灵活性与可信度。Workflow提供了最高程度的控制与可预测性,是流程合规与效率的基石;Agent赋予

一种搭建AI产品的方法论一种理解智能系统的逻辑视角一种未来业务自动化的路径地图。

大语言模型本质上是“用海量数据训练出来的语言专家”,它的核心是通过Transformer理解文字关系,经过预训练和微调后,能在各种场景帮人干活。虽然听起来复杂,但对普通人来说,不用懂原理,会用它提高效率(写东西、查信息)就够了~ 随着技术发展,它会变得越来越“聪明”,像手机一样成为日常工具。

Java程序员必收藏!AI大模型(LLM)完整学习路线指南,看完少走99%弯路!