简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本文介绍了CANN生态中msprof工具的内核分析功能,包括内核监控、瓶颈识别和优化建议。主要内容涵盖:1)内核分析指标(执行时间、资源利用率等)和方法;2)内核监控实现,通过代码示例展示了执行时间监控和资源利用率监控的数据结构与实现逻辑。这些功能帮助开发者分析AI应用内核性能,识别瓶颈并优化执行效率。文章为开发者提供了实用的内核性能分析技术参考。

本文介绍了CANN生态中msprof工具的内核分析功能,包括内核监控、瓶颈识别和优化建议。主要内容涵盖:1)内核分析指标(执行时间、资源利用率等)和方法;2)内核监控实现,通过代码示例展示了执行时间监控和资源利用率监控的数据结构与实现逻辑。这些功能帮助开发者分析AI应用内核性能,识别瓶颈并优化执行效率。文章为开发者提供了实用的内核性能分析技术参考。

CANN仓库中的cann-security-module提供了针对AI应用的安全威胁检测机制。该模块主要防范四种常见威胁:对抗攻击、模型窃取、数据投毒和后门攻击。检测方法包括异常检测、统计分析、行为分析和签名匹配。具体实现上,通过创建专门的检测器(如对抗攻击检测器和模型窃取检测器),采用距离计算和相似度分析等技术来识别潜在威胁。这些机制可有效保护AI模型免受恶意攻击,确保系统安全稳定运行。

CANN仓库中的cann-security-module提供了针对AI应用的安全威胁检测机制。该模块主要防范四种常见威胁:对抗攻击、模型窃取、数据投毒和后门攻击。检测方法包括异常检测、统计分析、行为分析和签名匹配。具体实现上,通过创建专门的检测器(如对抗攻击检测器和模型窃取检测器),采用距离计算和相似度分析等技术来识别潜在威胁。这些机制可有效保护AI模型免受恶意攻击,确保系统安全稳定运行。

传统的单模态模型,如自然语言处理(NLP)模型仅处理文本,计算机视觉(CV)模型仅处理图像,自动语音识别(ASR)模型仅处理音频,它们彼此独立。多模态AI旨在让机器能够像人类一样,通过融合和理解来自多种感官通道(如视觉、听觉、语言)的信息来进行感知、推理和交互。这个给多模态训练增加了不小的难度;

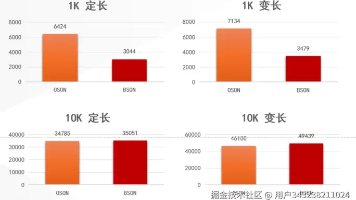

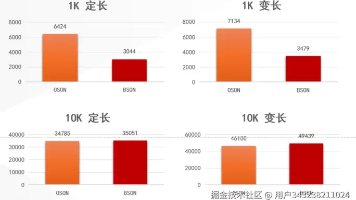

金仓数据库通过"多模一体"内核技术,突破传统文档数据库局限,实现文档、关系、向量等模型的原生融合。相比MongoDB 7.0,其YCSB测试性能提升18%-30%,尤其在读改写混合场景优势明显。核心创新在于统一优化器、存储和事务系统,支持跨模型联合查询和向量检索,同时保持MongoDB API 100%兼容。该方案已在电子证照等系统中验证,实现应用零改动迁移,并具备金融级强事务

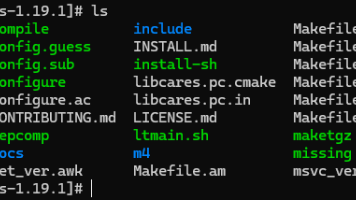

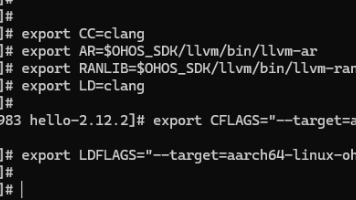

通过本次 c-ares 的移植与验证实践,可以看出 鸿蒙 PC 的平台生态已经非常成熟且高效。无论是交叉编译工具链、系统兼容性,还是运行时的网络栈和事件机制,都表现出企业级开发所需的稳定性和可靠性。开发者可以放心地在鸿蒙 PC 上构建高性能网络应用,享受到极佳的开发体验,同时充分利用 AArch64 架构优势,实现跨平台、高效、安全的网络服务。鸿蒙 PC 不仅降低了移植门槛,也为网络库和系统组件的

鸿蒙 PC 已经具备完整、可用、符合 ELF/ABI 规范的C 运行与链接能力,既能运行第三方 GNU 程序,也能作为“被链接平台”承载你自己构建的静态库与应用。鸿蒙 PC 在 Native 层面上,已经具备与传统 Linux/Unix 平台同级的 C/C++ 构建、链接与运行能力。

金仓数据库通过"多模一体"内核技术,突破传统文档数据库局限,实现文档、关系、向量等模型的原生融合。相比MongoDB 7.0,其YCSB测试性能提升18%-30%,尤其在读改写混合场景优势明显。核心创新在于统一优化器、存储和事务系统,支持跨模型联合查询和向量检索,同时保持MongoDB API 100%兼容。该方案已在电子证照等系统中验证,实现应用零改动迁移,并具备金融级强事务

通过本次 xxHash 在鸿蒙 PC 上的适配实战,可以确认鸿蒙 PC 已经具备完整的系统级第三方库承载能力,从工具链、运行时到动态链接机制均能够稳定支持原生 C/C++ 组件运行。xxHash 无需任何平台特定改造即可完成静态与动态两种方式部署,并在真机环境中实现端到端验证,这表明鸿蒙 PC 的命令行环境已经不仅限于应用开发场景,而是真正具备系统软件生态扩展能力,为后续引入更多基础组件和中间件提