简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

Numpypython三大库numpy,pandas以及matplotlib在人工智能领域有广泛的营运。下面我将介绍一些关于Numpy的一些简单教程1、他的元素必须是同一种元素2、array对象可以是一维的也可是多维的本文仅仅简单介绍了numpy的简单应用,想要进一步了解numpy,还需要进行大量的实战项目。任重道远,道友,加油!!!

大型语言模型(LLM)的高吞吐量服务需要一次处理足够多的请求。然而,现有的系统很难做到这一点,因为每个请求的键值缓存(KV 缓存)内存都很大,并且动态地增长和收缩。当管理效率低下时,碎片和冗余复制会严重浪费此内存,从而限制批处理大小。为了解决这个问题,我们提出了,这个注意力算法的灵感来自经典的虚拟内存和操作系统中的分页技术。在此基础上,我们构建了 vLLM,这是一个 LLM 服务系统,它实现了(1

LLaMA-Factory 支持多种推理方式。您可以使用或进行推理与模型对话。对话时配置文件只需指定原始模型和template,并根据是否是微调模型指定和。如果您希望向模型输入大量数据集并记录推理输出,您可以使用使用数据集或使用 api 进行批量推理。Note:使用任何方式推理时,模型需要存在且与template相对应。

手动的离散提示通常导致一个不稳定的性能——比如,在提示中改变一个词可能导致性能大幅度下降。于是提出了新颖的方法 —— P-Tuning,它采用连续的提示 embedding 与离散提示 结合在一起。P-Tuning 不仅能够通过最小化各种离散提示之间的差距来稳定训练,还能在很多基准测试中提高性能。预训练模型一般都可以通过手动编写提示模版进一步的提升性能。但是,手动的离散提示有很大程度的不稳定性。如

Numpypython三大库numpy,pandas以及matplotlib在人工智能领域有广泛的营运。下面我将介绍一些关于Numpy的一些简单教程1、他的元素必须是同一种元素2、array对象可以是一维的也可是多维的本文仅仅简单介绍了numpy的简单应用,想要进一步了解numpy,还需要进行大量的实战项目。任重道远,道友,加油!!!

Pandaspython三大库numpy,pandas以及matplotlib在人工智能领域有广泛的营运。下面我将介绍一些关于Pandas的一些简单教程这就是pandas 的全部教程啦,本文篇幅较长,包括了最基础的pandas的应用,道友们可以作为参考!要是想进一步了解pandas的用法建议还是多动手,实战中才能真正的进步。也许会很累,但是也不要忘记周围的美景,春末夏初,路边的柳树早已长出来枝芽。

Numpypython三大库numpy,pandas以及matplotlib在人工智能领域有广泛的营运。下面我将介绍一些关于Numpy的一些简单教程1、他的元素必须是同一种元素2、array对象可以是一维的也可是多维的本文仅仅简单介绍了numpy的简单应用,想要进一步了解numpy,还需要进行大量的实战项目。任重道远,道友,加油!!!

在人工智能发展了60多年后,机器虽然可以在某些方面超越人类,但想让机器真正通过图灵测试,具备真正意义上的人类智能,这个目标看上去仍然遥遥无期。

Pandaspython三大库numpy,pandas以及matplotlib在人工智能领域有广泛的营运。下面我将介绍一些关于Pandas的一些简单教程这就是pandas 的全部教程啦,本文篇幅较长,包括了最基础的pandas的应用,道友们可以作为参考!要是想进一步了解pandas的用法建议还是多动手,实战中才能真正的进步。也许会很累,但是也不要忘记周围的美景,春末夏初,路边的柳树早已长出来枝芽。

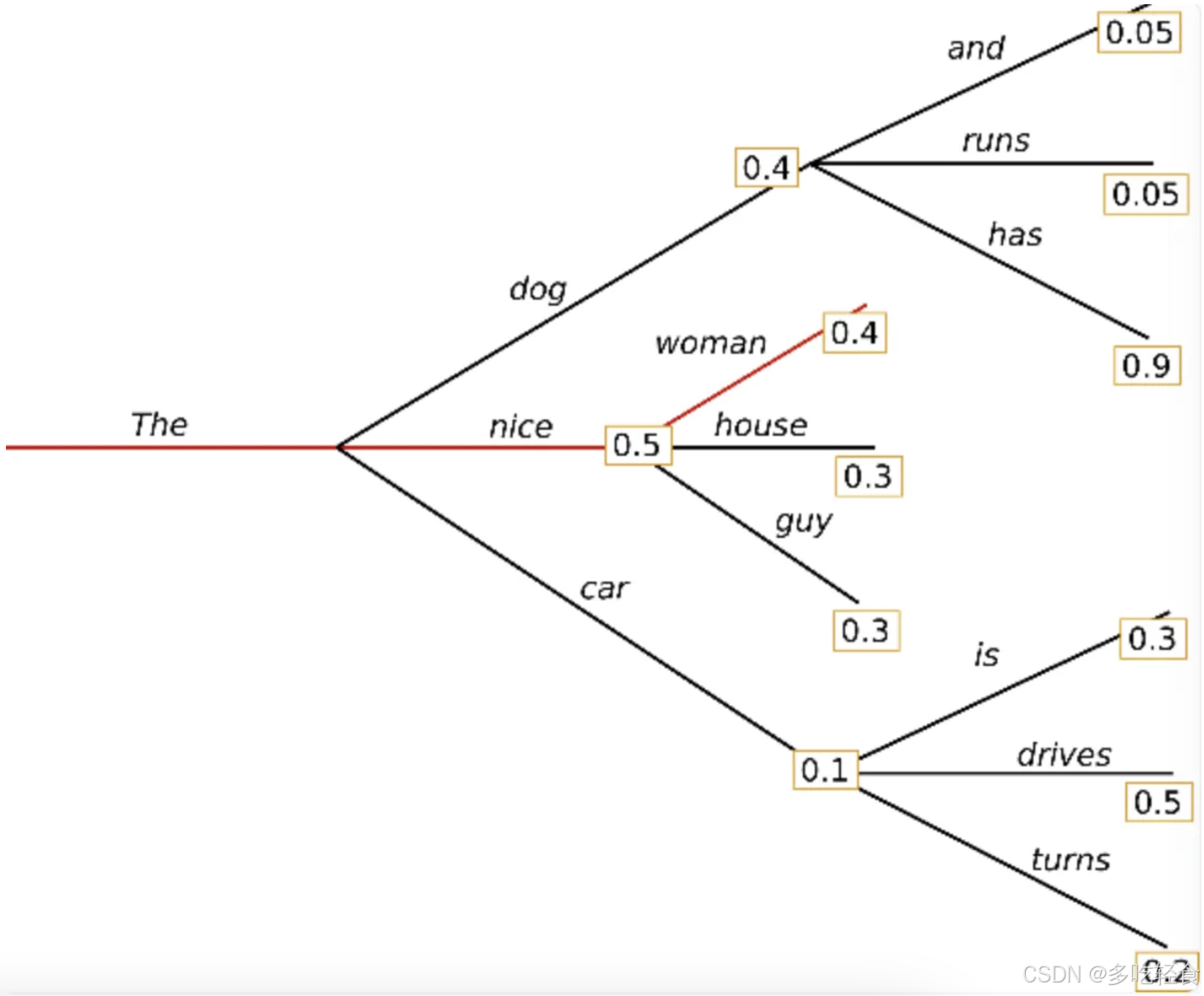

Top-p 采样中,采样不只是在最有可能的 K 个单词中进行,,而是在累积概率超过 P 的最小单词集中进行。在 Top-K 采样中,概率最大的 K 个词会被选中,然后对这 K 个词重新归一化,最后在这重新归一化概率后的 K 个词进行采样。假设 p=0.92,Top-p 采样对单词概率进行降序排列并累加,然后选择概率和首次超过 p=0.92 的单词集作为采样池。在 t=1 的时候,词集有 9 个词,