简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

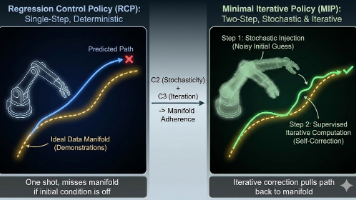

CogACT与3D-CAVLA:机器人视觉-语言-动作模型的创新突破 CogACT提出了一种解耦架构的VLA模型,通过分离认知(VLM)与动作(DiT)模块,采用扩散模型处理连续动作空间,并创新性地提出自适应动作集成算法,显著提升了动作精度和多模态处理能力。实验表明,增加动作模块参数比单纯扩大VLM更有效。 3D-CAVLA则针对VLA模型在未见任务中的泛化问题,通过整合3D深度感知、思维链推理和

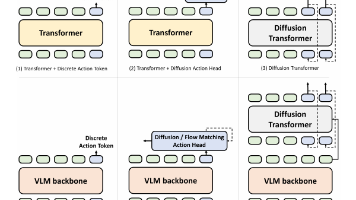

视觉语言动作模型(VLA)的常见框架包括Transformer结合离散动作token、扩散动作头或扩散变换器,以及利用预训练视觉语言模型(VLM)的变体。这些架构通过离散或连续token输出动作,并结合扩散模型提升平滑性和实时响应能力。此外,融入世界模型的设计(如GR-1)通过端到端预测未来图像和动作,增强了事件预测能力。GR系列模型的迭代(如GR-3)进一步整合VLM和扩散变换器,实现了分层结构

其次,VLM 在通用基准上的表现,或者在语言理解、VQA、图文对齐等经典任务上的能力,不能作为其在机器人操作任务中表现的可靠预测指标。LLM 的优势在于建模高层语义、组合结构和可语言化的中间概念,而当训练信号只是一串缺乏语义锚定的 action 数值时,LLM 很难发挥这些能力,最终往往退化为一个昂贵的函数逼近器。但问题在于,机器人动作本身是一种信息密度极低的监督信号,它只描述了某一时刻的控制结果

当前的大型视觉-语言-动作(VLA)模型(如OpenVLA)虽然在通用机器人策略学习方面表现出色,但在处理交互式机器人任务中的时空动态(spatial-temporal dynamics)方面仍显不足。现有的VLA模型往往缺乏对过去运动轨迹的感知,导致其决策更多是基于当前输入的“反应式”决策,而非基于空间历史的知情决策。为了解决这一问题,本文提出了视觉轨迹提示(Visual Trace Promp

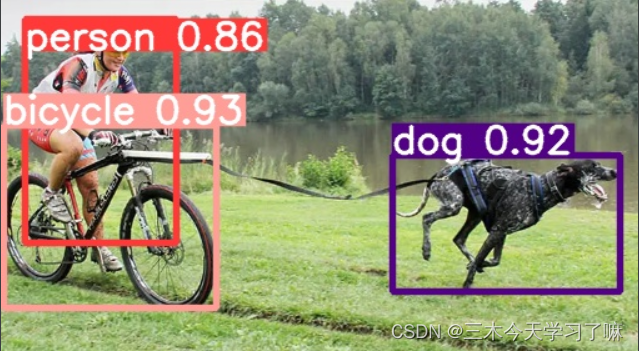

在YOLO-v5跑通VOC2007数据集,并自己标注一张图片进行detect测试网络性能。

CogACT与3D-CAVLA:机器人视觉-语言-动作模型的创新突破 CogACT提出了一种解耦架构的VLA模型,通过分离认知(VLM)与动作(DiT)模块,采用扩散模型处理连续动作空间,并创新性地提出自适应动作集成算法,显著提升了动作精度和多模态处理能力。实验表明,增加动作模块参数比单纯扩大VLM更有效。 3D-CAVLA则针对VLA模型在未见任务中的泛化问题,通过整合3D深度感知、思维链推理和

CogACT与3D-CAVLA:机器人视觉-语言-动作模型的创新突破 CogACT提出了一种解耦架构的VLA模型,通过分离认知(VLM)与动作(DiT)模块,采用扩散模型处理连续动作空间,并创新性地提出自适应动作集成算法,显著提升了动作精度和多模态处理能力。实验表明,增加动作模块参数比单纯扩大VLM更有效。 3D-CAVLA则针对VLA模型在未见任务中的泛化问题,通过整合3D深度感知、思维链推理和

本博客主要介绍了编码器的类型和测速原理,初步认识了L298N电机驱动模块。为之后调电机和造车做了铺垫。如果有问题请加QQ1257663033。

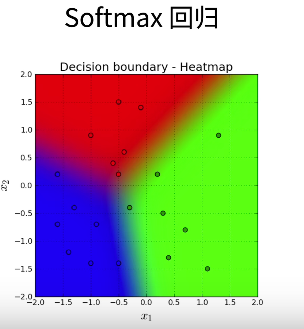

本博客介绍了线性回归和softmax回归,从数学公式到代码实现,再到高级API,更简洁地实现代码。参考书籍:《动手学深度学习V2》

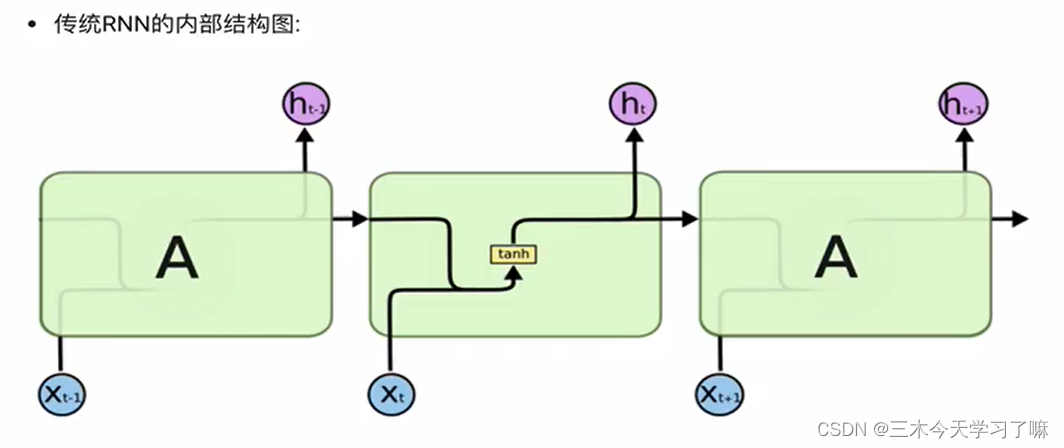

如果说卷积神经网络可以有效地处理空间信息, 那么本章的循环神经网络(recurrent neural network,RNN)则可以更好地处理序列信息。 循环神经网络通过引入状态变量存储过去的信息和当前的输入,从而可以确定当前的输出。