简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

## 引言:开源AI项目的“隐形门槛”如今,AI功能几乎成了软件项目的标配。无论是智能摘要、代码补全,还是聊天机器人,我们都希望通过调用大模型的能力提升产品竞争力。

在过去两年里,大模型几乎以光速发展:参数量从百亿级推到万亿级,算力投入也从几千万美金飙升到数十亿美金。然而,我们也能明显感觉到,近来新模型的能力提升正在趋缓。算力和参数的堆叠,边际效益不断递减。于是问题来了——**Scaling Laws 是否已经失效?我们真的撞上了“数据墙”吗?**DatologyAI 创始人 **Ari Morcos** 给出的答案是:**数据才是影响 AI 研究的最大变量,

在ROS(Robot Operating System)中,如果发布频率(Publisher Rate)高于处理频率(Processing Rate),订阅者(Subscriber)会逐渐滞后,导致处理的始终是旧消息,而最新的消息可能会在队列中积压或被丢弃(取决于queue_size)。

近年来,随着Transformer架构的出现,人工智能特别是自然语言处理领域取得了飞跃性的进展。然而,最新的大语言模型架构Test-Time Training(简称TTT)的出现,可能会在不久的将来超越Transformer和Mamba。本文将详细介绍这一全新架构的设计理念、技术细节、实际应用及其潜在影响。

随着AI技术的飞速发展,对计算性能的需求日益增加。尤其是在推理模型和大规模深度学习任务中,GPU的性能和内存成为了制约计算速度和效率的瓶颈。英伟达(Nvidia)作为全球领先的AI加速芯片制造商,持续推动着硬件的创新。在最新发布的**B300**和**GB300**系列GPU中,英伟达不仅带来了显著的性能提升,还通过全新的技术架构与供应链策略重塑了市场格局。本篇文章将深入探讨这些新一代GPU的技术

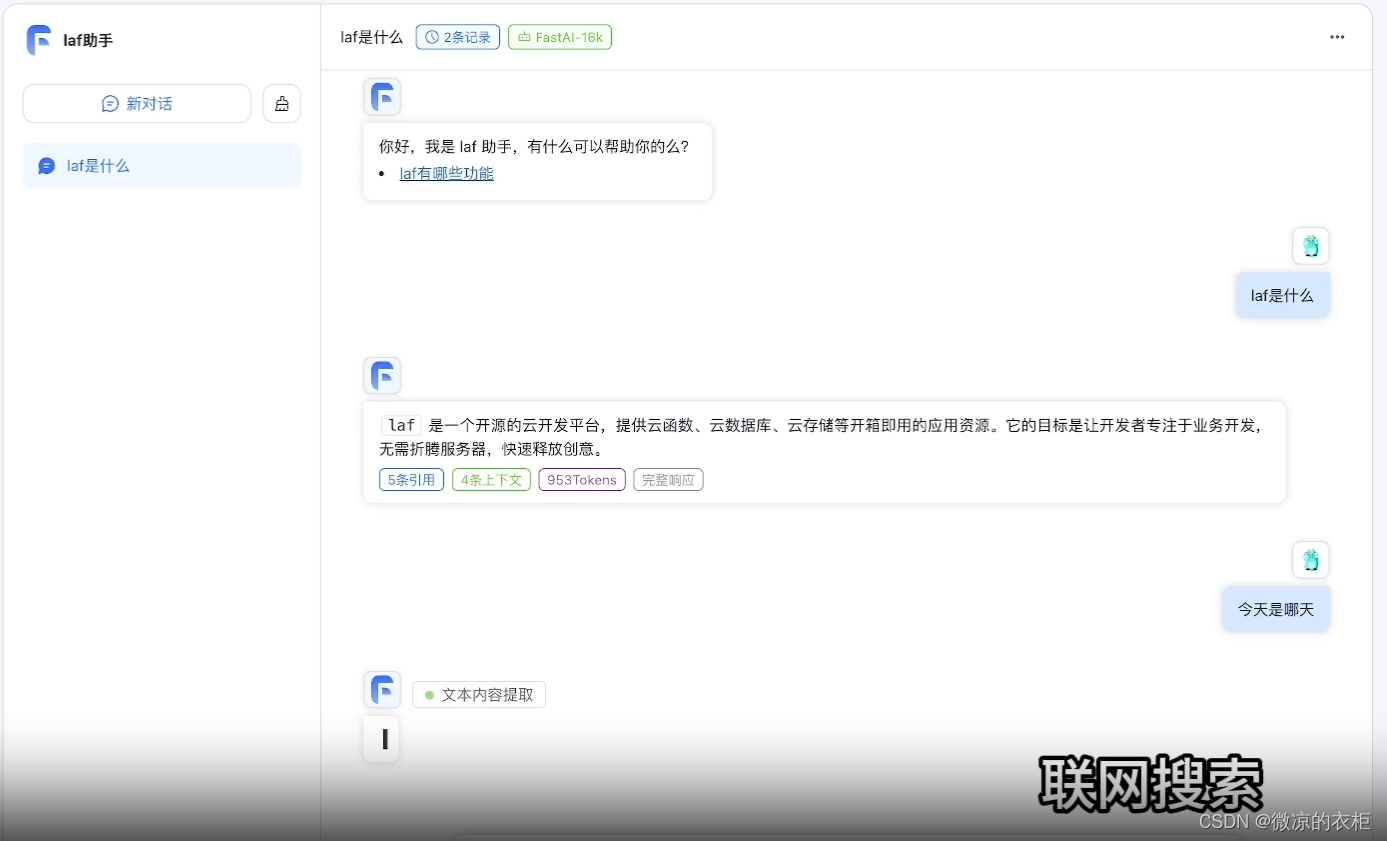

FASTGPT开发

大语言模型(LLMs)在自然语言处理领域展现了巨大的潜力,但同时也带来了“幻觉”问题。幻觉指的是模型生成不真实、虚构或不一致的内容。Lilian Weng,OpenAI安全系统团队负责人,最近在她的博客中详细梳理了在理解、检测和克服大语言模型幻觉方面的研究成果。本文将详细介绍这些研究成果,探讨幻觉的定义、类型、产生原因、检测方法及克服策略。

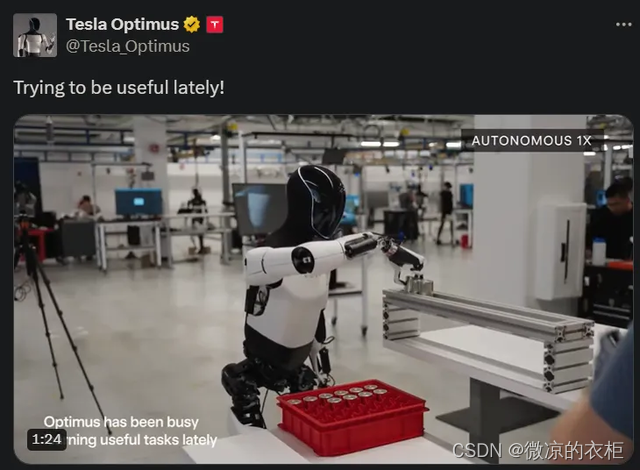

特斯拉擎天柱机器人在工厂中应用。

近年来,随着Transformer架构的出现,人工智能特别是自然语言处理领域取得了飞跃性的进展。然而,最新的大语言模型架构Test-Time Training(简称TTT)的出现,可能会在不久的将来超越Transformer和Mamba。本文将详细介绍这一全新架构的设计理念、技术细节、实际应用及其潜在影响。