简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

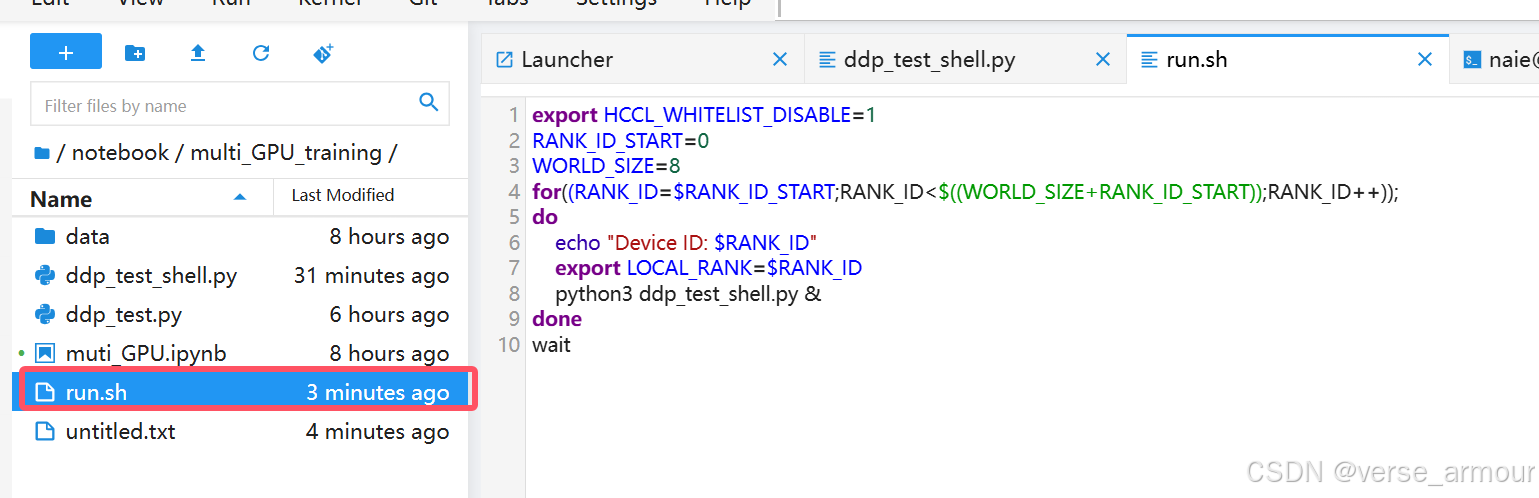

world_size(进程总数):在分布式训练或并行计算任务中,world_size表示总共有多少个进程参与计算。每个进程通常运行在不同的CPU核心、GPU或整个计算节点上。4.将数据加载器train_dataloader与train_sampler相结合。Shell 脚本可以自动化任务,使得重复性的工作可以快速、一致地完成。2.在获取训练数据集后,设置train_sampler。3.定义模型后,

通过以上步骤,我们成功解决了 PyTorch 中的 libnvJitLink.so.12 报错问题。问题的根本原因在于 CUDA 库路径未正确配置,导致 PyTorch 无法加载所需的动态链接库。通过将库路径添加到 LD_LIBRARY_PATH,并验证路径是否生效,我们可以确保程序能够正确运行。希望这篇文章能够帮助遇到类似问题的开发者快速定位并解决问题。如果你有其他疑问或建议,欢迎在评论区留言。

【代码】三种目标检测数据集格式对比:PASCAL VOC 格式、 COCO 格式、YOLO 格式。

在多进程环境中,数据共享是一个挑战。torch.multiprocessing 允许在进程之间共享 PyTorch 张量,这些张量存储在共享内存中,而不是在进程之间复制数据。DDP通过在每个进程中创建模型的一个副本,并在每个副本上独立地进行前向和反向传播,从而实现并行计算。在每个训练步骤后,DDP自动同步各个进程计算出的梯度,确保所有进程的模型参数保持一致。这个采样器的设计目的是确保在分布式训练过

在多进程环境中,数据共享是一个挑战。torch.multiprocessing 允许在进程之间共享 PyTorch 张量,这些张量存储在共享内存中,而不是在进程之间复制数据。DDP通过在每个进程中创建模型的一个副本,并在每个副本上独立地进行前向和反向传播,从而实现并行计算。在每个训练步骤后,DDP自动同步各个进程计算出的梯度,确保所有进程的模型参数保持一致。这个采样器的设计目的是确保在分布式训练过

模型的评估、选择、改进

在多进程环境中,数据共享是一个挑战。torch.multiprocessing 允许在进程之间共享 PyTorch 张量,这些张量存储在共享内存中,而不是在进程之间复制数据。DDP通过在每个进程中创建模型的一个副本,并在每个副本上独立地进行前向和反向传播,从而实现并行计算。在每个训练步骤后,DDP自动同步各个进程计算出的梯度,确保所有进程的模型参数保持一致。这个采样器的设计目的是确保在分布式训练过

动态规划——找零问题

npy格式的文件是什么?为什么要用npy格式保存文件?