简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

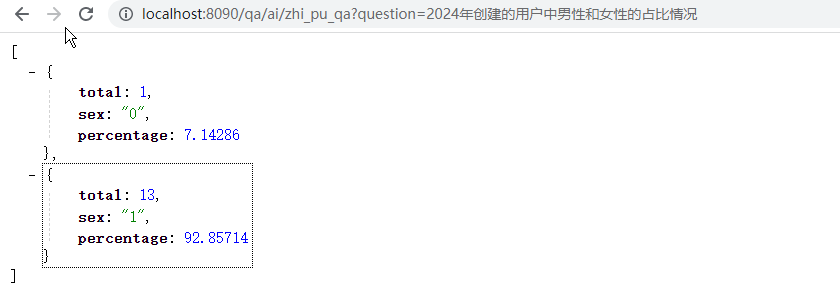

传统模式 vs 智能革命:用AI让数据「随想随看」传统时代的困境:企业每天都有上百个数据统计需求——销售想对比各区域业绩趋势,财务要分析成本波动原因,管理层需实时查看经营指标… 但每个需求都像一场漫长的接力赛:1️⃣ 业务人员绞尽脑汁写需求文档,还得懂技术术语(“要LEFT JOIN哪几个表?GROUP BY什么字段?”)2️⃣ 程序员熬夜写SQL、改代码,一个简单需求从提出到上线平均

本文介绍了如何将本地大模型封装为Web服务,使用FastAPI框架实现API调用。主要内容包括:1)安装FastAPI和相关依赖;2)构建代码结构,包含模型加载、配置和路由处理;3)实现模型单例模式,确保全局共享一个模型实例;4)创建聊天接口,支持动态添加系统提示。该方案解决了本地模型单次使用问题,通过Web服务实现持续访问,为构建类似商业大模型的交互式应用提供了基础框架。

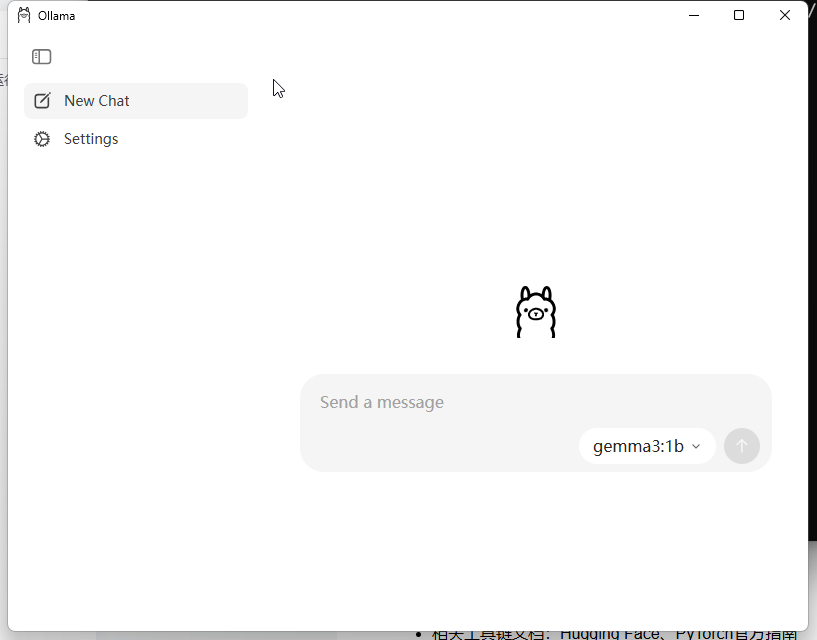

《低配环境下的Qwen2-0.5B大模型本地部署实践》摘要 本文提供了两种在低配Windows10环境(4G内存/无显卡)本地运行Qwen2-0.5B小模型的方法。方式一通过HuggingFace生态实现:使用git克隆模型后,通过PyTorch+Transformers框架加载,特别注意了CPU运行设置和内存优化参数。方式二采用Ollama工具链,演示了从模型下载到API调用的完整流程,包含流式

对话式分析(Conversational Analytics)是一种通过自然语言交互实现数据探索的技术。用户无需掌握SQL或编程技能,像与真人对话一样用日常语言提问,系统自动解析语义、生成查询、返回可视化结果。

【代码】快速使用OkHTTP发送POST请求传送JSON数据。

IDEA安装到编写第一个HelloWorld代码教程