简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

Elasticsearch(ES)是一个分布式搜索引擎,基于Apache Lucene(Lucene是当搜索引擎库)构建。它专为处理海量数据设计,支持结构化/非结构化数据的全文检索、聚合分析及实时监控。核心价值在于解决传统数据库在大数据场景和分布式场景下的检索瓶颈。比如传统的数据库MySQL,如果想在其中搜索某条记录,基于关键词搜索,通常采用模糊匹配like。在少量数据下,遍历全库的方式系统还能抗

随着GPT、DeepSeek等大模型的技术不断蓬勃发展,大模型与人之间的交互成为AI技术快速落地应用的难题。智能体,作为大模型应用的关键一环,成为行业内的热点。Coze作为国内字节旗下的智能体开发平台,帮助无编程经验或少量编程经验的人也可以轻松上手大模型开发应用,快速开发出自己的AI产品;也可以通过 API 或 SDK 将 AI 应用集成到你的业务系统中,因此具有较高的学习价值。Coze的Play

在这里分享一下使用docker compose启动Elasticsearch和Kibana遇到的两个问题的解决方案。

自从Transformer诞生以来,LLM(Large Language Model)大模型技术就开始蓬勃发展,从ChatGPT系列到国内的DeepSeek、通义千问系列,大模型技术不断迭代,一次次突破性能指标上限。但是,大模型的落地应用成为行业难题,诸如智能体、RAG等技术不断解决落地难和应用难的问题。繁多的技术规范不统一,学习起来极为困难,而Spring AI、LangChain等技术正是统一

通常对于二分类问题,大家熟知的模型就是logistic回归。那么对于多分类问题呢?如果要多分类,我们可以在网络的最后一层建立多个神经元,每个神经元对应一个分类的输出,输出的是某一个分类的概率,这些概率之和为1。要想做到上述分析,就需要由Softmax激活函数组成的Softmax回归模型来解决。

在计算机视觉领域,卷积运算撑起了半边天,因此在学习计算机视觉前,首先来了解一下卷积运算是如何运算的。假设正在进行边缘检测,垂直边缘检测会把图片中接近垂直的边缘提取出来,即人的侧边、栏杆等。而水平边缘检测会把图片中接近水平的边缘提取出来,即横杆、自行车轮的上侧等。现在以垂直边缘检测为例,解释一下卷积运算是如何进行的?卷积运算用*符号表示,一张图片表示的矩阵*一个过滤器(或被称为核,在图像处理领域又被

在上篇文章:一系列带你学会Coze——Coze智能体开发我们已经学习了Coze智能体的开发和相关API、SDK介绍,本文将使用Python的Coze SDK实现一个人生模拟器。

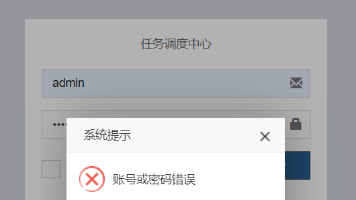

在学习xxl-job时,使用docker方式部署xxl-job调度中心(2.4.0版本),但是明明使用的官方默认密码初始化的数据库,结果总是登录不成功:上面是官方源码仓库xxl-job/doc/db/tables_xxl_job.sql的用户名和密码,对应admin/123456,下面是我的数据库中的admin对应的密码,可以发现,值是一样的。官方源码。

随着GPT、DeepSeek等大模型的技术不断蓬勃发展,大模型与人之间的交互成为AI技术快速落地应用的难题。智能体,作为大模型应用的关键一环,成为行业内的热点。Coze作为国内字节旗下的智能体开发平台,帮助无编程经验或少量编程经验的人也可以轻松上手大模型开发应用,快速开发出自己的AI产品;也可以通过 API 或 SDK 将 AI 应用集成到你的业务系统中,因此具有较高的学习价值。Coze的Play

找到全连接层和前一层,用5*5的过滤器来实现卷积层的转化,数量是400个(编号1所示),输入图像大小为5*5*16,用5*5的过滤器对它进行卷积操作,过滤器实际上是5*5*16,因为在卷积过程中,过滤器会遍历这16个通道,所以这两处的通道数量必须保持一致,输出结果为1*1。再添加另外一个卷积层(编号2所示),这里用的是1*1卷积,假设也有400个1*1的过滤器,在这400个过滤器的作用下,下一层的