简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

记得刚开始研究深度学习时,做过两个小例子。一个是用tensorflow构建了一个十分简单的只有一个输入层和一个softmax输出层的Mnist手写识别网络,第一次我对权重矩阵W和偏置b采用的是正态分布初始化,一共迭代了20个epoch,当迭代完第一个epoch时,预测的准确度只有10%左右(和随机猜一样,Mnist是一个十分类问题),当迭代完二十个epoch,精度也仅仅达到了60%的样子。然后我仅

在安装pytorch时,我没有采用anaconda(上面博客即采用这种方法),因为我是打算将cuda应用于已有的项目中(已经创建了虚拟环境),因此我直接使用pycharm安装到已有环境中。如果你使用上面的命令安装pytorch未报错,恭喜你,不用看后续步骤,直接跳到最后一步检验pytorch安装是否成功即可。②但博主的显卡不支持11.3,只支持到11.2,因此我安装了cuda11.1,pytorc

本文整理汇总了90+深度学习各方向的开源数据集,包含了小目标检测、目标检测、工业缺陷检测、人脸识别、姿态估计、图像分割、图像识别等方向。附下载链接。

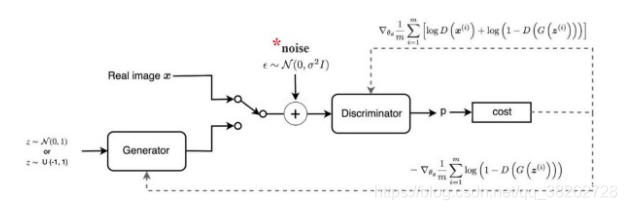

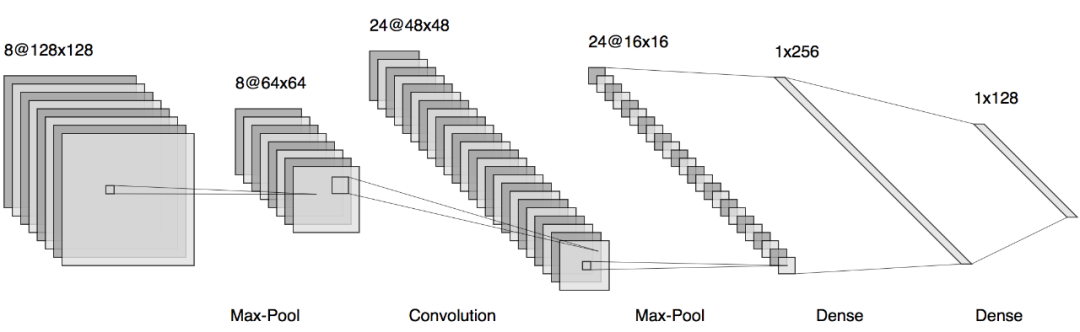

使用Keras.js,可以轻松地生成神经网络模型的摘要。摘要提供了模型的层级结构、层级名称、输出形状和可训练参数数量等信息。这有助于用户快速了解模型的组成和规模。

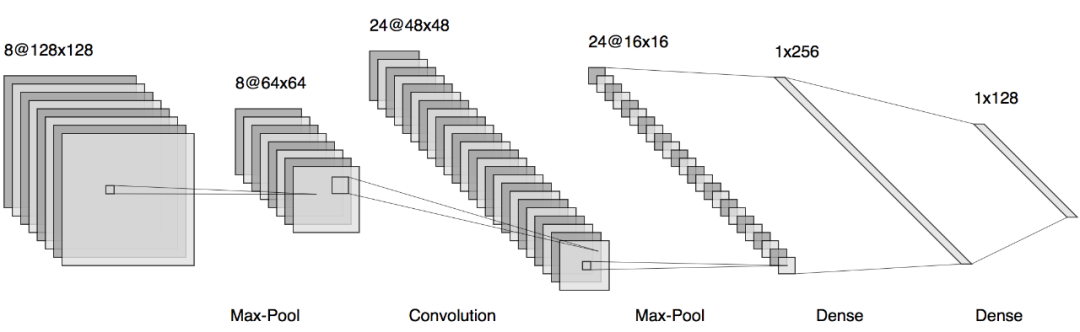

文章目录1 什么是GAN?2 GAN存在的问题3 训练的经验3.1 不要纠结于损失函数的选择3.2 关于增加模型的容量3.3 尝试改变标签3.4 尝试使用 batch normalization3.5 尝试分次训练3.6 最好不要提早结束3.7 关于k的选择3.8 关于学习率3.9 增加噪声3.10 不要使用性能太好的判别器3.10 可以尝试最新的multi-scale gradient方法3.1

使用Keras.js,可以轻松地生成神经网络模型的摘要。摘要提供了模型的层级结构、层级名称、输出形状和可训练参数数量等信息。这有助于用户快速了解模型的组成和规模。

本文整理汇总了90+深度学习各方向的开源数据集,包含了小目标检测、目标检测、工业缺陷检测、人脸识别、姿态估计、图像分割、图像识别等方向。附下载链接。

httpshttps当前的目标检测器通常由一个与检测任务无关的主干特征提取器和一组包含检测专用先验知识的颈部和头部组成。颈部/头部中的常见组件可能包括感兴趣区域(RoI)操作、区域候选网络(RPN)或锚、特征金字塔网络(FPN)等。如果用于特定任务的颈部/头部的设计与主干的设计解耦,它们可以并行发展。从经验上看,目标检测研究受益于对通用主干和检测专用模块的大量独立探索。长期以来,由于卷积网络的实际

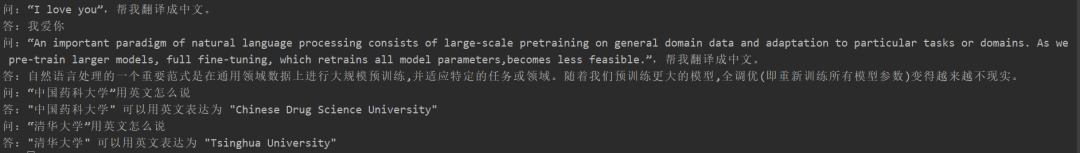

PT方法占用显存更大,因为也增加了很多而外参数;测试耗时,采用float16进行模型推理,由于其他方法均增加了额外参数,因此其他方法的推理耗时会比Freeze方法要高。当然由于是生成模型,所以生成的长度也会影响耗时;模型在指定任务上微调之后,并没有丧失原有能力,例如生成“帮我写个快排算法”,依然可以生成-快排代码;

PT方法占用显存更大,因为也增加了很多而外参数;测试耗时,采用float16进行模型推理,由于其他方法均增加了额外参数,因此其他方法的推理耗时会比Freeze方法要高。当然由于是生成模型,所以生成的长度也会影响耗时;模型在指定任务上微调之后,并没有丧失原有能力,例如生成“帮我写个快排算法”,依然可以生成-快排代码;