简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

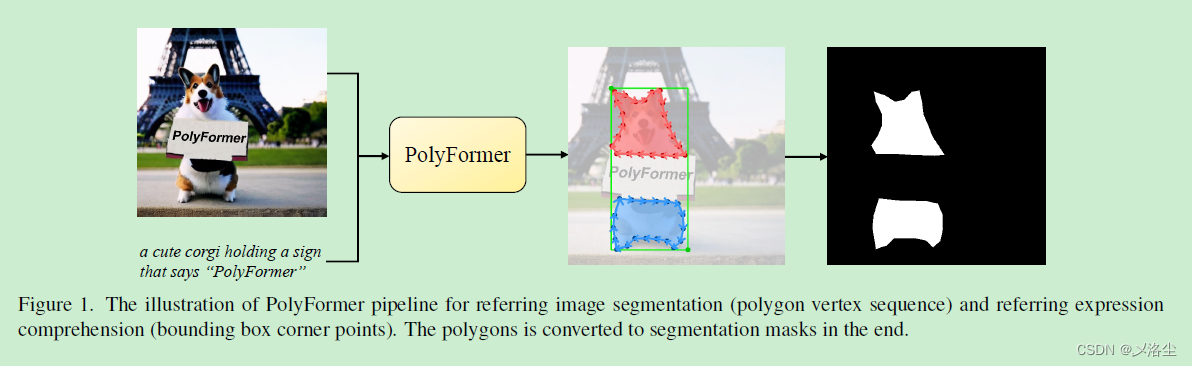

好久都没写论文相关的博客了,最近苦于调参。抽空看了一下这篇有新意的论文。将之前目标检测的通用范式:预测回归框的位置,变成直接预测目标的位置。论文框架简单,很管用。

问题描述: 在用pythia 训练模型时,出现:2021-03-23T15:41:44 ERROR: /media/XXX/D20187A13362E67A/Run_python_module/mmf-0.3.1Traceback (most recent call last):File "tools/run.py", line 94, in <module>run()File "to

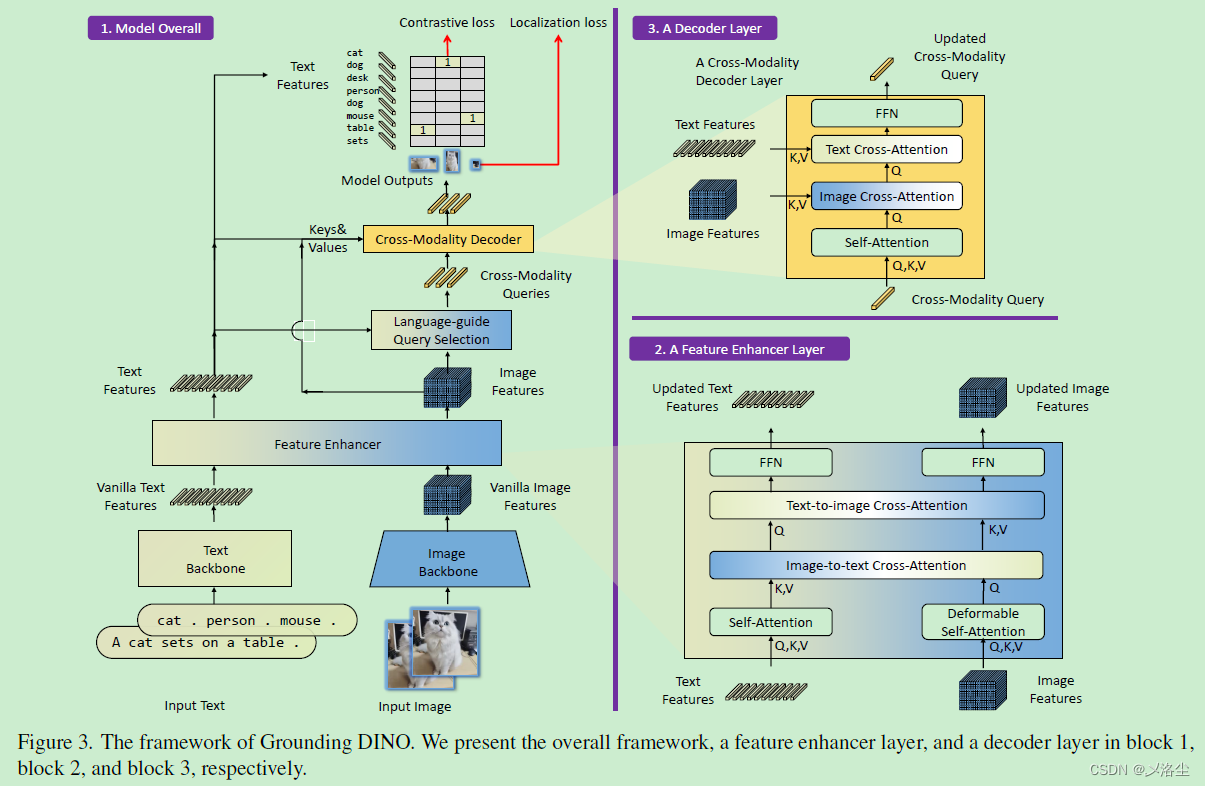

本文提出一个开放目标检测器 Grounding DINO,采用基于 Transformer 的 DINO 框架+预训练,能够检测任意输入类别或表达式对应的目标。开放目标检测的关键在于引入语言到一个闭集的检测器中,从而实现开放的概念泛化。于是本文提出将闭集的检测器划分为三个阶段并提出一种轻量化的融合方法,包含一个特征增强器,一个语言引导的 query 选择,一个跨模态的检测器用于跨模态融合。之前的工

目标检测+实例分割+姿态估计三合一:LSNet: Location-Sensitive Visual Recognition with Cross-IOU Loss论文笔记一、Abstract二、引言三、相关工作四、方法描述1、Location Sensitive Visual Recognition2、LSNet: A Unified Framework3、Cross IOU Loss4、Pyr

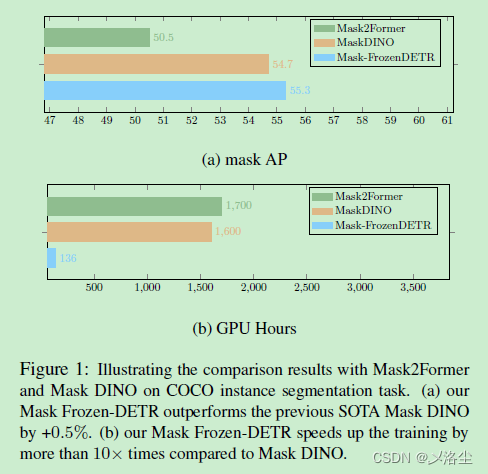

本文旨在研究建立一个仅需最小训练时间和 GPU 的实例分割器,Mask Frozen-DETR,能够将任何基于 DETR 的目标检测模型转化为一个实例分割模型。提出的方法仅需训练附加的轻量化 mask 网络,通过一个冻结的基于 DETR 的目标检测器在 Bounding box 内预测实例 mask。在 COCO 数据集上效果很好,仅需单张 V100 16G 卡即可进行训练。

ViTs 模型受限于计算成本而很难部署到实际应用上,之前的方法通过裁剪 tokens 来实现精度和成本之间的权衡,但裁剪策略一定会导致信息丢失。本文进行的量化实验揭示了裁剪 tokens 对性能的影响是显而易见的。于是提出 Token Pruning & Squeezing module (TPS) 模块来更高效率地压缩 ViTs。

问题描述: 在用pythia 训练模型时,出现:2021-03-23T15:41:44 ERROR: /media/XXX/D20187A13362E67A/Run_python_module/mmf-0.3.1Traceback (most recent call last):File "tools/run.py", line 94, in <module>run()File "to

三行代码计算并输出模型参数量

目前的参考图像分割一般不去直接预测目标的 mask,而是作为一个多边形序列生成任务。本文提出来一种能直接预测精确的几何位置坐标的基于回归的解码器,摒弃了之前那种需要将坐标量化到某个固定格子上的做法。不仅在常规的数据集上表现很好,而且泛化到参考视频图像分割上仍然牛皮。

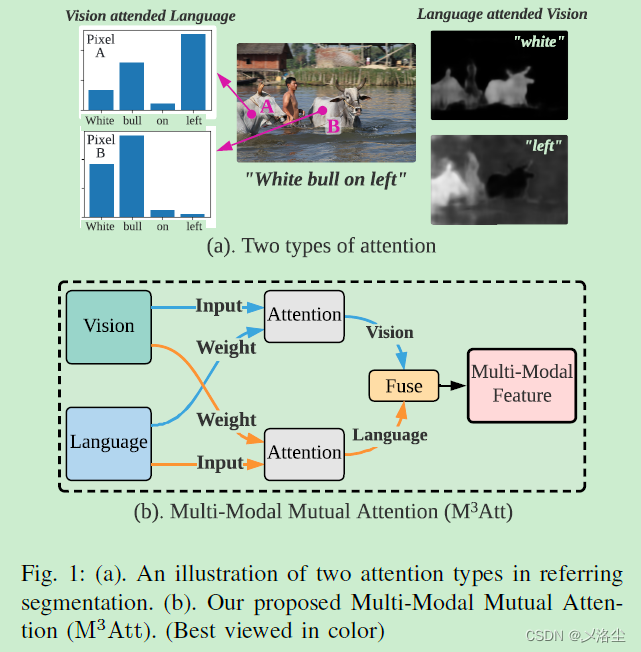

首先指出 Referring image segmentation(RIS)的定义,然后表明问题:最近的方法大量使用 Transformer,其中注意力机制仅采用语言输入作为注意力的权重计算方式,而输出的特征中却并未显式地融合语言特征。介于其输出主要由视觉信息主导,限制了模型全面理解多模态信息,从而导致后续 mask 解码的不确定性。于是本文提出 Multi-Modal Mutual Attent