简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

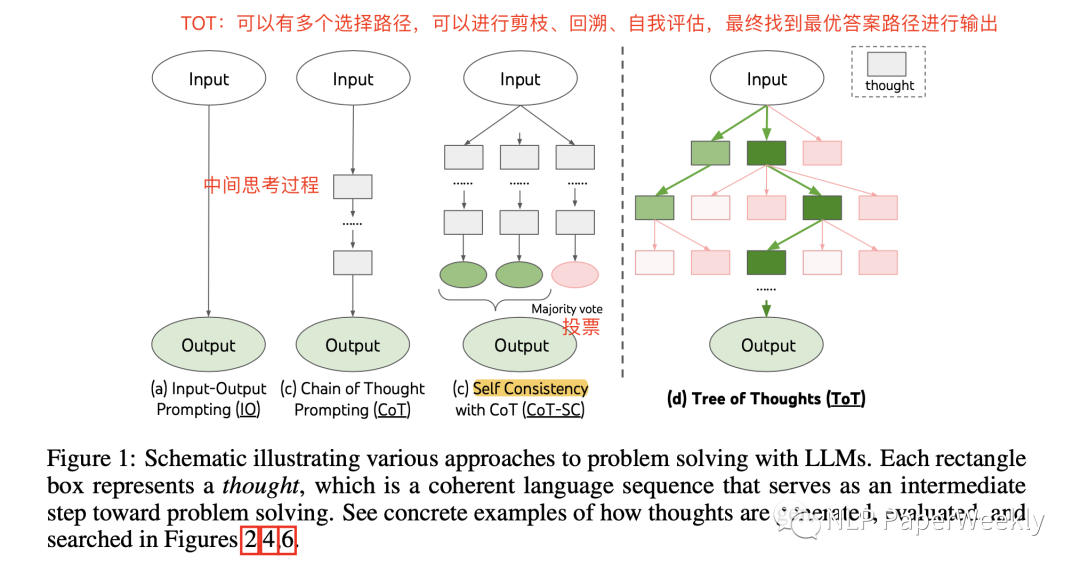

Title【24点游戏】是什么?"Game of 24"是一种数学益智游戏,旨在通过组合和计算四个给定的数字(通常是1到9之间的整数)来得到结果为24的表达式。【Mini Crosswords 填字游戏】是什么?:Mini Crosswords是一种简化版的填字游戏,适合在有限的空间和时间内进行。与传统的填字游戏不同,Mini Crosswords使用较小的网格,通常为5x5或6x6,且只包含较少

1.n-gram自己理解:n代表窗口长度,n-gram的思想就是先滑窗,然后统计频次,然后计算条件概率,你可以取前面n个的条件概率,不一定要取全部的,最后得到的是整个句子的一个概率,那这个概率可以代表句子的合理性。详情见:https://zhuanlan.zhihu.com/p/32829048如何利用n-gram作为额外的特征呢?例如:我 爱 北京 天安门这样词就有各种组...

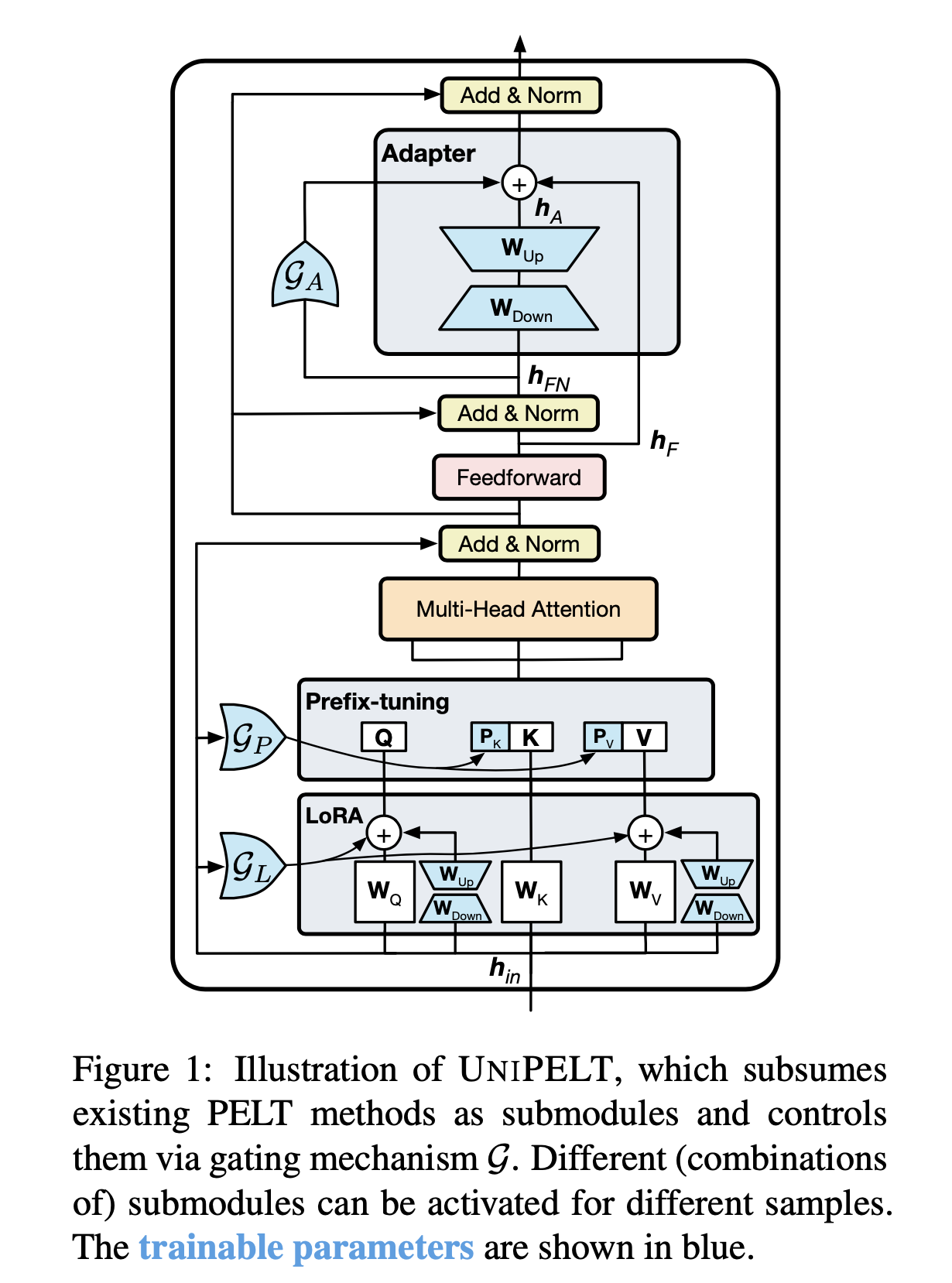

大模型不同的微调方法(PELT)例如LoRA,prefix-tuning,Adapter方法效果不同,在不同的任务上效果也有差异,到底选哪个方法好呢?parameter-efficient language model tuning (PELT) 方法能在参数量比fine-tuning小很多的情况下,perform追上fine-tuning的水平,但是不同的PELT方法在同一个任务上表现差异可能都

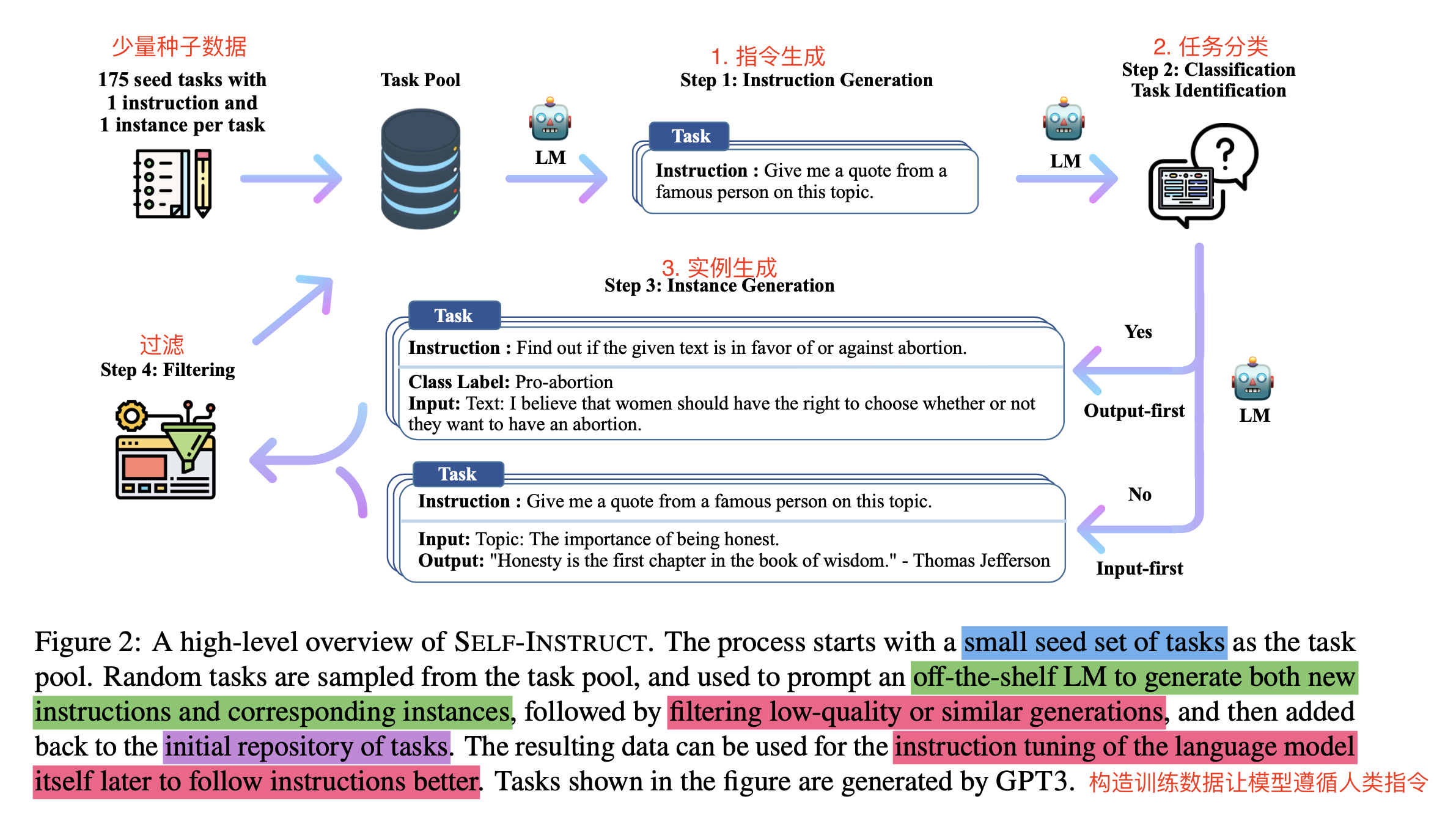

相当于验证了少量种子数据 + 原始预训练模型 => 生成大批量 多样性 + 质量还不错的 指令数据的可行性 => 好处是可以极大降低指令遵循数据集构建的成本。这篇文章解释了为什么大模型能听懂人类指令的困惑,可以看出,原始的GPT-3模型学习了非常多的知识,但是人类指令遵循的能力非常非常差,通过self-instruct构造大量的多样、高质量的指令数据和答案,模型就开始能听懂指令,理解这个指令的具体

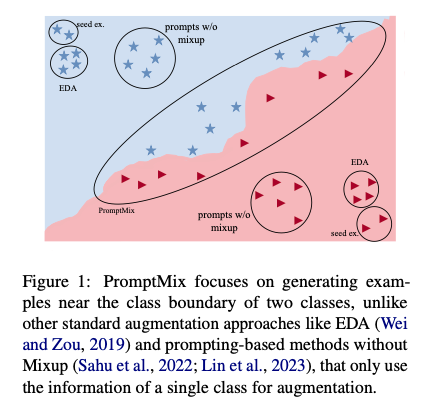

这篇论文介绍了PromptMix,一种新颖的类边界数据增强方法,用于在训练数据有限的情况下提高大型语言模型的文本分类效果。该方法通过生成挑战性文本并结合Relabeling策略,生成类别精确的难样本,以便更好地迁移大型模型(如GPT3.5-turbo)的知识到更小、更经济高效的分类器(如DistilBERT和BERTbase)。论文的实验表明,PromptMix在2-shot场景中的效果优于多个5

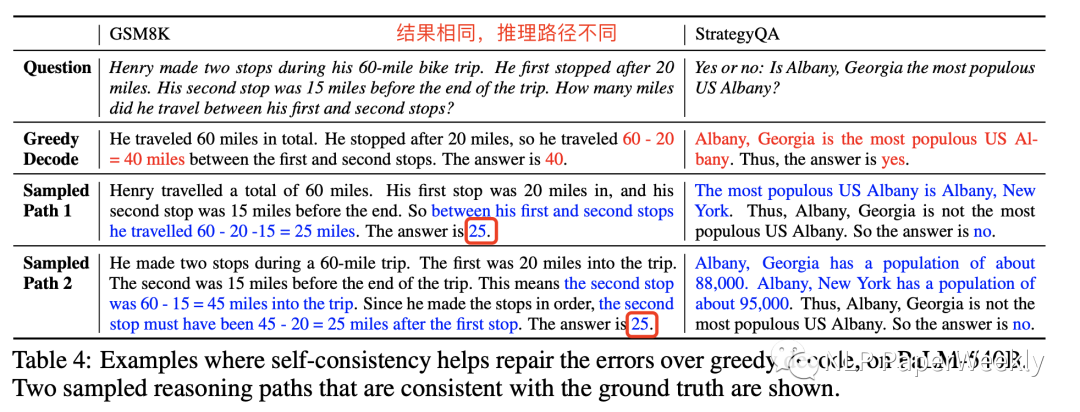

论文地址:https://arxiv.org/abs/2203.11171大模型(10B以上)生成结果的多样性diversity和质量比较好。本文的一大特点是没有利用不同的多个模型来集成,而是只用当个大模型采样输出不同的推理路径和结果来集成,有一个现象就是随着模型size的变大,集成的效果越来越高,说明大size的模型(一般要求要10B以上),其多样性diversity足够好,同时其生成的答案的质

结论1: 自动化Agent系统设计可能代表着智能体开发的新范式。手动设计智能体系统所面临的效率低下和创新局限性。利用LLM的强大编程能力在代码空间中进行搜索,可能能够自动发明新颖、高效的智能体构建块和组合方式,可以加速了智能体系统的发展。元智能体搜索算法能够持续发现超越 SOTA 手动设计的智能体。本文提出的 Meta Agent Search 算法在多个领域(包括逻辑推理、阅读理解、数学、多任务

总结1: SwiRL + Tool use > Base Model + Tool use >> Base Model。引入工具后还是效果提升非常大,说明Base Model已经具备不错的Tool调用的能力了。SwiRL可以改进Tool 调用的能力。总结2: 不需要其他标注资源,利用现有的Model就可以合成数据进行RL训练提升Model的Tool Use能力。

结论1: LLM在数学推理能力提升并非总能迁移到其他领域。通过对20多个开源模型和受控实验进行评估,发现许多在数学基准测试上表现强劲的模型,在其他推理和非推理任务上往往无法有效迁移其增益,甚至出现灾难性遗忘。这推翻了“数学能力提升即通用能力提升”的直观假设,强调了模型在专业化训练后泛化能力面临的挑战。结论2: 强化学习(RL)相比监督微调(SFT)在保持LLM通用能力方面具有显著优势。结论4: 在

框架通过“两步走”策略生成高质量学术综述。第一步,通过学习人类撰写的综述范例和检索相关论文,用LLM生成一个结构化、有逻辑的启发式大纲。第二步,针对大纲的每个小节,利用一个带有记忆和时序感知重排功能的智能体(SANA)来检索高质量的核心文献,然后驱动LLM并行生成各部分内容,最后汇总精炼成文。同时,为了客观评估,文章还提出了一个包含100篇人类综述的基准。结论1: SURVEYFORGE开创性地利