简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

Gemini CLI 项目是一个基于 React/Ink 构建的强大命令行界面,其核心为事件驱动的流式架构。它接收用户输入,解析后与 Gemini API 进行异步流式交互,并能调度一个可扩展的插件化工具系统(支持文件、Shell等操作),最终将结果实时反馈给用户。该项目的关键特性包括:展示 AI 推理过程的“思考”(Think)模块、为优化长对话性能而设计的智能历史压缩机制,以及通过多层校验和用

得益于大型语言模型(LLMs)的突破性进展,自然语言处理(NLP)在过去十年间实现了飞速发展。LLMs 正逐渐成为网络安全领域的一股强大力量,它们能够自动检测漏洞、分析恶意软件,并有效应对日益复杂的网络攻击。具体而言,LLMs 被广泛应用于软件安全领域,可从代码和自然语言描述中识别漏洞,并生成相应的安全补丁。同时,LLMs 也被用于分析安全策略和隐私政策,帮助识别潜在的安全违规行为。在网络安全领域

这次访谈全面展现了 Cursor 团队在 AI 编程工具领域的创新和挑战。尽管面临 GitHub 和 OpenAI 的竞争,Cursor 团队依然充满信心,通过优化代码差异界面、提升处理速度、改进提示工程等手段来保持竞争力。未来,他们将继续探索如何更好地集成新技术、改进用户体验,以在快速发展的 AI 编程领域中占据一席之地。

MCP-Zero是什么?想象一下,你请一个助手帮忙修电脑,但你只给了他一把螺丝刀。当他需要其他工具时,他不能自己去工具箱找,只能被动等你递给他。这就是传统AI代理的困境。MCP-Zero让AI代理变得更聪明:当它发现需要新工具时,可以主动说"我需要一个文件编辑器"或"我需要一个数据库查询工具",然后系统会为它找到并提供合适的工具。简单来说,MCP-Zero让AI从"被动使用工具"变成了"主动寻找工

本指南介绍如何使用 Docker 启动 Ollama,并用 ollama pull 下载gpt_oss模型。 您可以导出 Modelfile,修改 num_ctx (上下文长度) 等参数后,以 ollama create 创建自定义模型。

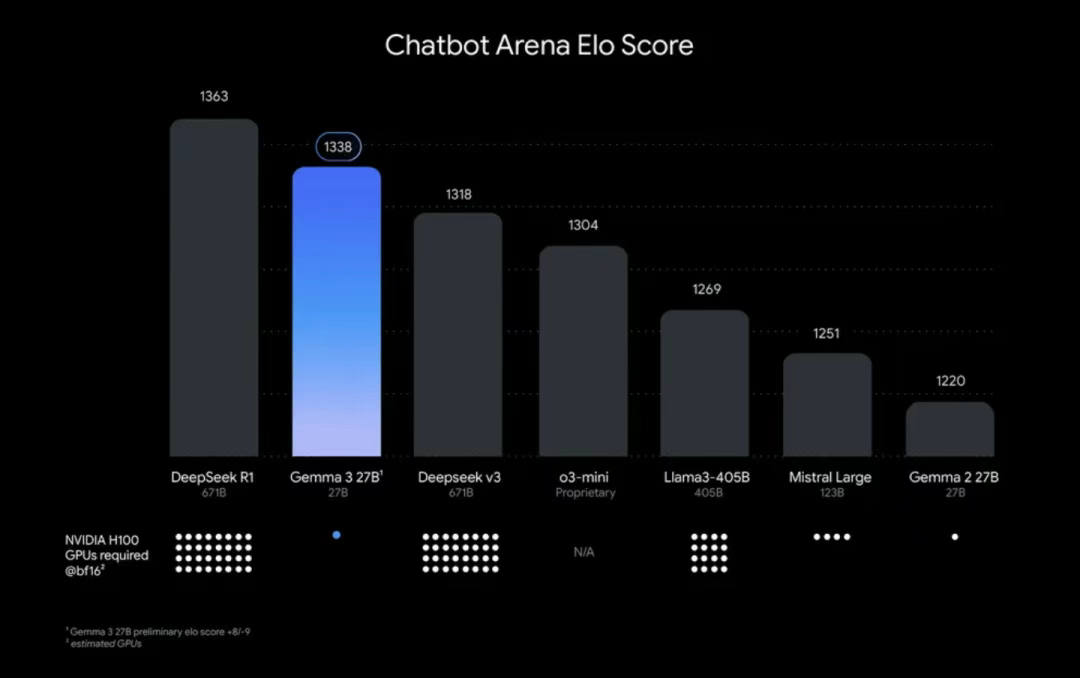

Gemma 是一个源自 Google 的轻量级模型系列,该系列依托于先进的 Gemini 技术进行构建。2025 年 3 月 12 日,Google 正式发布了 Gemma 系列的最新一代产品——Gemma 3。这款新一代的 Gemma 模型具有多模态处理能力,不仅能够理解和生成文本内容,还能对图像数据进行分析和处理。Gemma 3 拥有一个宽广的上下文窗口,大小达到 128K tokens,这意

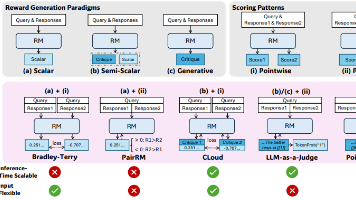

本文探讨了强化学习(RL)在大规模语言模型(LLMs)后训练中的应用,重点研究如何通过推理计算改进通用查询的奖励建模(RM)及其推理时扩展性,以及如何通过适当的学习方法提升性能-计算扩展的有效性。作者提出了一种点式生成奖励建模(GRM)方法,以适应不同输入类型并实现推理时扩展潜力,同时引入自原则批评调整(SPCT)学习方法,通过在线 RL 培养 GRM 的可扩展奖励生成行为,自适应生成原则并准确批

Claude Code 是 Anthropic 官方命令行工具,支持 Linux、macOS 和 Windows 系统。安装前需要 Node.js 18+ 版本。安装步骤:各系统先安装 Node.js,然后运行 npm install -g @anthropic-ai/claude-code 全局安装,最后用 claude --version 验证。配置设置:在 ~/.claude/setting

模型上下文协议 (MCP) 是一种标准化的安全机制,旨在帮助大语言模型 (LLM) 应用程序暴露其数据和功能。您可以将 MCP 视为专为 LLM 交互而设计的 Web API。通过资源暴露数据:类似于 HTTP GET 请求,将信息加载到 LLM 的上下文中。通过工具提供功能:类似于 HTTP POST/PUT 请求,允许 LLM 执行特定操作。通过提示定义交互模式:提供可复用的提示模板,规范和引

在人工智能迅速发展的今天,大型语言模型(Large Language Models,简称LLM)正逐渐成为各类应用的核心组件。其中,对话模板(Chat Template)作为连接用户与模型的关键桥梁,对确保高质量的交互体验至关重要。本文将深入解析Qwen3使用的对话模板,揭示其如何优雅地处理多轮对话、工具调用等复杂场景。