简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

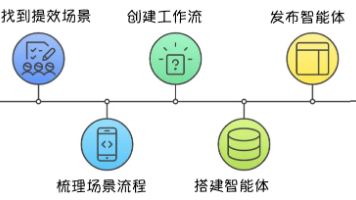

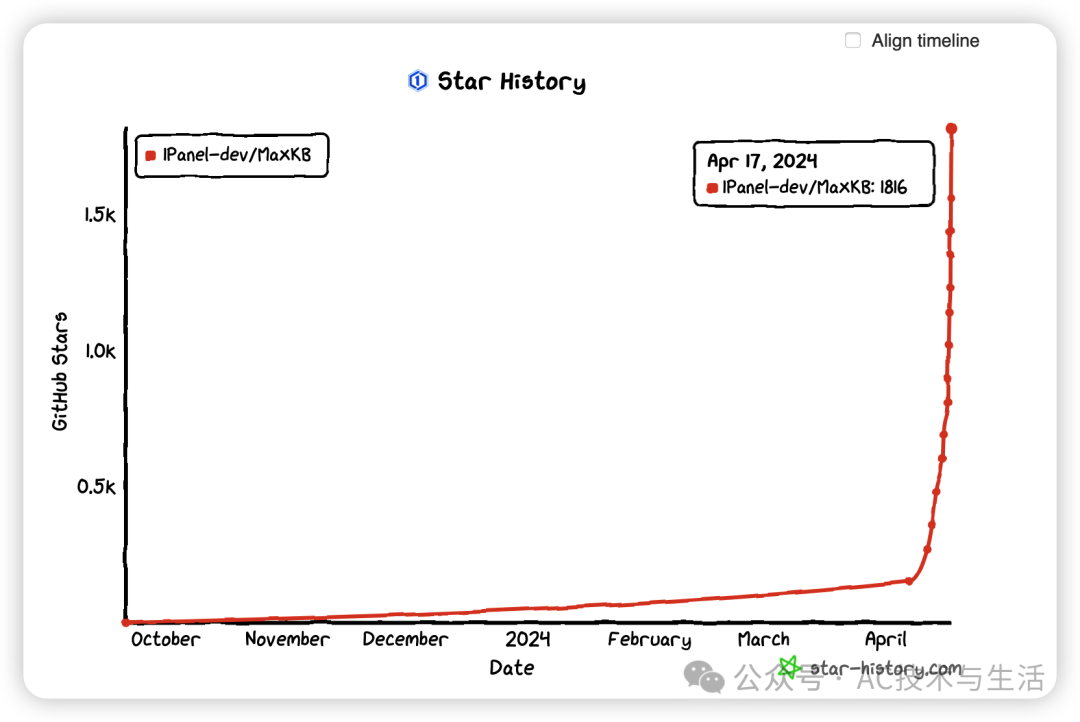

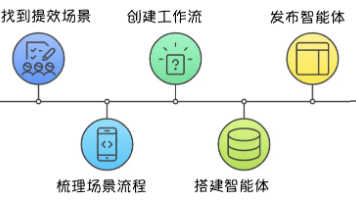

在本文中,我们将通过MaxKB和Ollama,介绍如何快速构建一个基于大语言模型的本地知识库问答系统。MaxKB是一款基于LLM的知识库问答系统,而Ollama是一个支持本地部署的开源框架。

随着AI技术的不断进步,MiniCPM-V的推出无疑为我们打开了一个全新的世界,一个我们可以在手机上直接与高级AI模型互动的世界。这不仅仅是技术的革命,更是移动设备使用体验的一次巨大进步。如果你对AI技术充满热情,千万不要错过MiniCPM-V,它将为你带来前所未有的体验。。

5.更细粒度的token分析,的地得aanthe,标点符号,更多pattern挖掘,新时代挖煤,异构数据分布情况下荒漠化植树,不影响原参数情况下midtrain,改变地形地貌的大规模rl。从原理出发真正入局大模型。更大rollout,256的大小对于百亿级空间完全是大海里舀了一瓢水,1w的rollout,10w的rollout效果会大幅提升,硬件是最大制约。模型的发展,一直都是信号挖掘和硬件的暴力

Browser-Use 是一个开源的 Python 库,旨在让 AI 能够自主地与网页进行交互。该项目允许用户通过自然语言描述任务,AI 通过 Chrome DevTools Protocol(CDP 协议) 执行 Chrome/Chromium 浏览器复杂的网页操作,如网页导航、表单填写、数据提取、在线购物等。

这本 LLM 书籍通过利用 MLOps 最佳实践,提供了在实际场景中设计、训练和部署 LLM 的实用见解。这本全面的指南将指导您构建端到端 LLM 支持的技术内容编写器,克服孤立的 Jupyter Notebooks 并专注于教授如何构建生产级端到端 LLM 系统。本书还探讨了该领域的前沿进展,包括推理优化和实时数据处理,使其成为任何希望在项目中利用 LLM 的人的重要资源。无论您是 AI 新手还

同时课程详细介绍了。

作者结合自身丰富的实战经验,详细阐述了RAG的基础原理、核心组件、优缺点以及使用场景,同时探讨了RAG在大模型应用开发中的变革与潜力。书中不仅揭示了RAG技术背后的数学原理,还通过丰富的案例与代码实现,引导读者从理论走向实践,轻松掌握RAG系统的构建与优化。第三部分(第7章和第8章)中,我们首先以一个基于LangChain实现 的RAG应用为例,详细介绍了如何搭建一个RAG系统。在第一部分(第1~

这个节点就是大模型的配置,在这里我们需要大模型帮我总结文章内容,提炼文章关键词。红框 1:此处可以选择不同的模型来处理,不同的提示词在不同的模型下表现有时候是不一致的,所以这里需要注意的是在当前这个场景下根据大模型的特点,选定模型后,再去写系统提示词和用户提示词。红框 2:输入,可以将上个节点输出的参数标题和内容传到这里。

这个节点就是大模型的配置,在这里我们需要大模型帮我总结文章内容,提炼文章关键词。红框 1:此处可以选择不同的模型来处理,不同的提示词在不同的模型下表现有时候是不一致的,所以这里需要注意的是在当前这个场景下根据大模型的特点,选定模型后,再去写系统提示词和用户提示词。红框 2:输入,可以将上个节点输出的参数标题和内容传到这里。