简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

win10 系统带linux子系统有两个版本第一个是wsl, 它与windows 系统公用同1个ip地址, 但是没有自己内核, 不支持docker第二个版本是wsl2, 它可以使用docker,但是它的网卡每次启动都随机使用ip, 所以重启后每次都必须手动进行ip 转发。但由于微软系统的不稳定性, 经常无故重启, 大部分都是更新引起的, 禁了更新一两周内仍会自己重启, 好智障。一旦重启后,由于ws

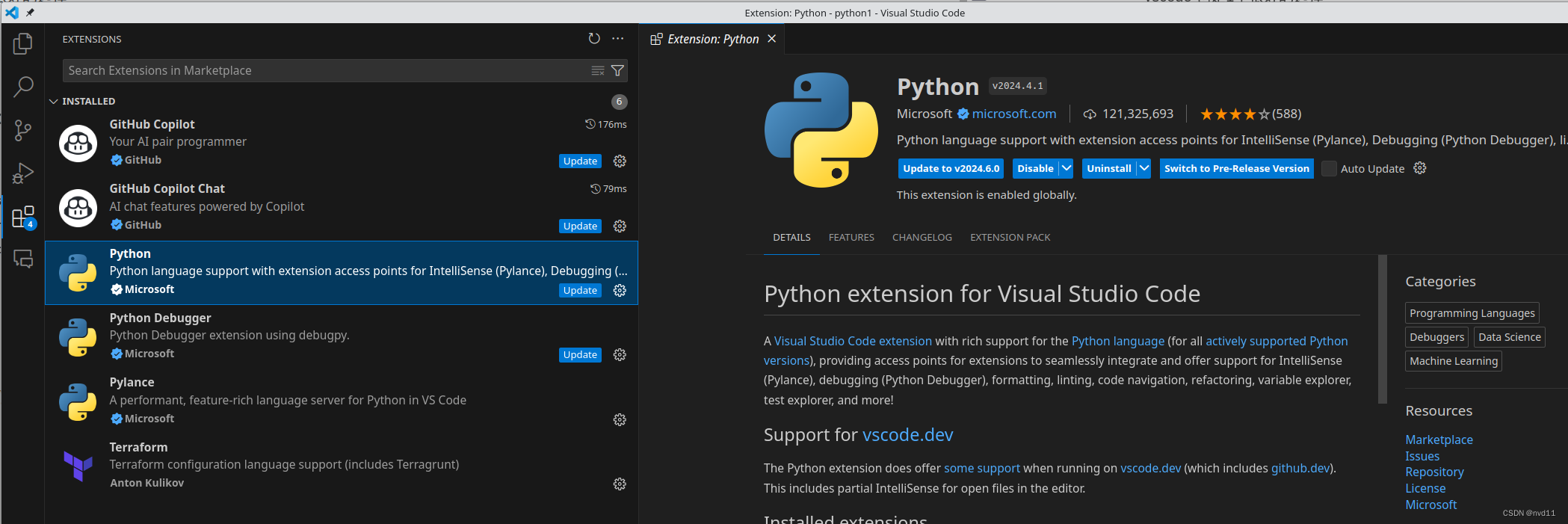

如果不想用 heavy 的pycharmvscode 也是1个很好的选择。

RunnablePassthrough是LangChain LCEL中的关键组件,主要实现数据透传功能。它有两种核心用途:1)在并行处理中保留原始输入,如RAG场景中同时传递检索结果和原始问题;2)通过.assign()方法增量更新字典数据。该组件在构建复杂数据流时尤为重要,能确保信息完整传递,避免手动处理字典的繁琐操作,是LangChain实现高效数据处理的重要工具。

本文深入解析LangChain经典对话组件ConversationBufferMemory与ConversationChain的核心机制。ConversationBufferMemory作为基础记忆组件,完整存储对话历史但存在token爆炸风险;ConversationChain则是预封装的三合一解决方案(LLM+Memory+Prompt),开箱即用但存在实例级状态绑定的并发限制。文章通过代码示

是 LangChain 中优雅管理状态的瑞士军刀。它通过配置化的方式,将繁琐的历史记录读写逻辑从业务逻辑中剥离出来,极大地简化了代码结构。记忆口诀Config定身份 (session_id)。Factory找仓库 (get_session_history)。Keys做映射 (input/history keys)。

本文介绍了LangChain中invoke和_generate两个关键方法的区别与用途。invoke是面向模型使用者的统一公共API,支持标准调用、组合操作和高级功能;而_generate是面向模型开发者的内部抽象方法,用于实现底层模型调用逻辑。两者的关系类似汽车方向盘和发动机,invoke提供统一接口,_generate实现核心功能。这种设计实现了接口统一和实现解耦,使LangChain既易用又

本文介绍如何通过环境变量实现LangSmith的零代码自动追踪功能。核心原理是利用LangChain内置支持,只需设置LANGCHAIN_TRACING_V2=true环境变量即可自动记录所有Chain、LLM等组件的运行细节。配置包括开启追踪开关、API密钥、区域端点和项目名称。通过示例脚本演示,普通LangChain代码无需修改即可自动生成追踪报告。用户可在LangSmith控制台查看完整的调

本文详细解析了大型语言模型文本生成中的三个关键参数:Temperature、Top-k和Top-p。Temperature控制概率分布的平滑度,低温(<1)使输出更确定,高温(>1)增加随机性。Top-k采样固定保留前k个候选词,但存在无法适应预测置信度变化的缺陷。Top-p采样则动态保留累积概率达到阈值p的最小候选集,能更好地处理模型确定性和不确定性情况。实践建议优先使用Top-p(0.9-0.

摘要: 本文描述了在FastAPI+SSE的LLM流式对话服务中,客户端断开导致已生成响应丢失的问题。原代码仅在流式结束后保存数据,但异常中断(如CancelledError)会跳过保存环节。首次尝试捕获异常直接保存时,因请求级DB会话失效导致失败。最终解决方案采用:1)独立后台任务执行保存操作;2)创建全新DB会话避免资源冲突;3)加入重试机制处理连接异常。部署后验证显示,中断场景下部分响应内容

LangChain 0.1+架构通过引入Runnable协议统一了核心组件的交互方式,使Prompt、LLM等组件能像Unix管道一样组合。其编排层包含三大原语:Runnable(基础协议)、RunnableLambda(函数封装)和RunnableParallel(并行处理)。Runnable协议要求所有组件实现统一的调用方法(如invoke、stream等),RunnableLambda可将任