简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

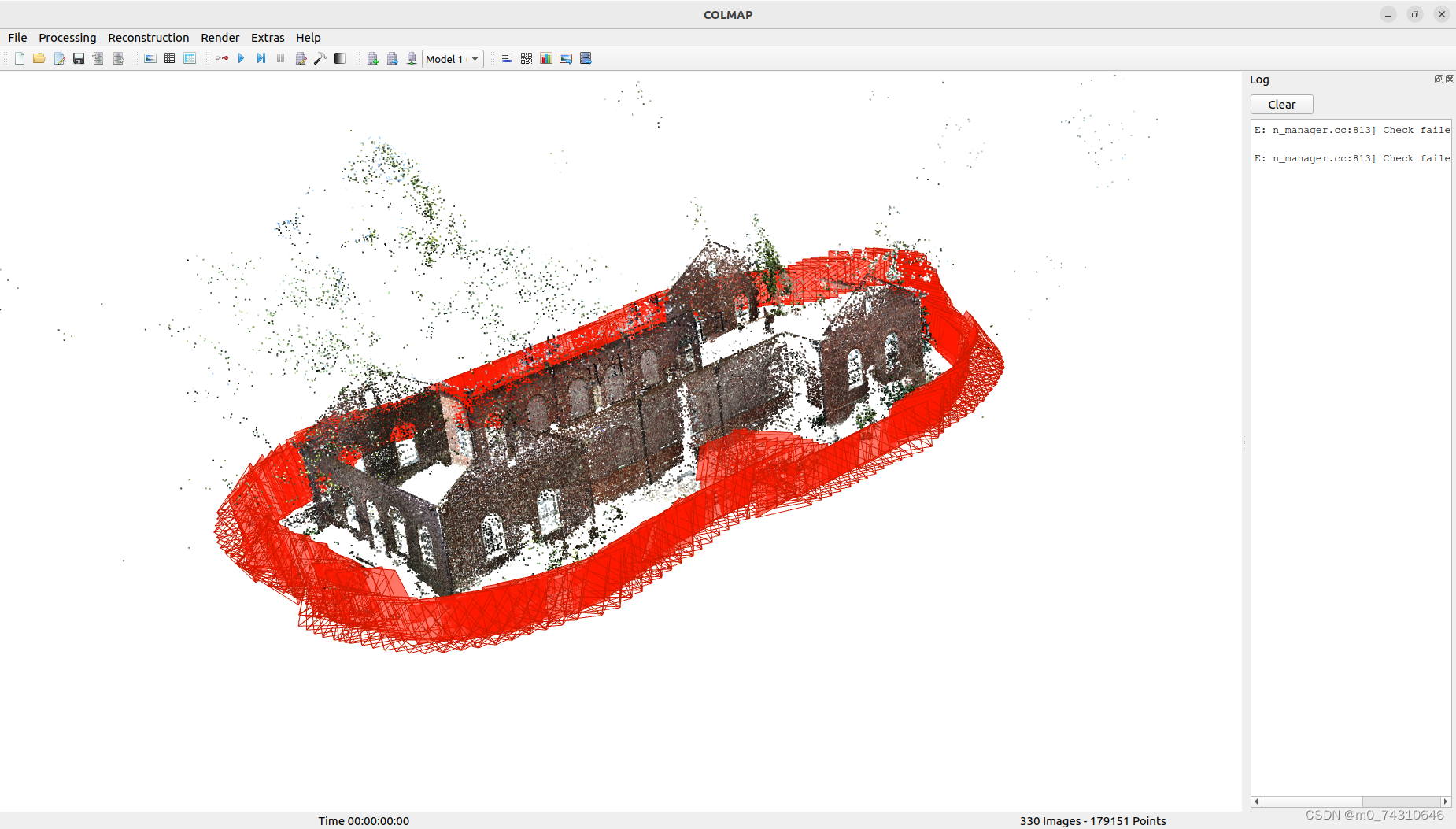

colmap计算的Ubuntu版本,歪瑞因垂丝汀,快来looklook!

图 2 概述了方法。

视觉基础模型 (VFM) 是在广泛的数据集上进行训练的,但通常仅限于 2D 图像,自然会出现一个问题:它们对 3D 世界的理解程度如何?由于架构和训练协议(即目标、代理任务)存在差异,迫切需要一个统一的框架来公平、全面地探究他们的 3D 感知。现有的 3D 探索工作主要关注单视图 2.5D 估计(例如深度和法线)或双视图稀疏 2D 对应(例如匹配和跟踪)。但是这些任务忽略了纹理感知,并且需要 3D

关于深度学习项目的docker部署踩坑记录,主要用来告诉大家一件事情,安装nvidia-container-toolkit而不是nvidia-docker,不要浪费时间在找没用的帖子身上,食用方式,一只手握住鼠标,一只手握住一杯卡布奇诺,嘶。。。

图像金字塔有两种,一种是高斯金字塔,一种是拉普拉斯金字塔。高斯金字塔是一种多分辨率图像表示方法,通过对图像逐层降采样(缩小)生成一系列分辨率递减的图像集合。其核心思想是模拟人眼观察物体时从粗到细的感知过程,广泛应用于图像缩放、特征提取、图像融合等任务。拉普拉斯金字塔是一种基于高斯金字塔的多尺度图像表示方法,通过差分操作提取不同分辨率下的高频细节信息,常用于图像融合、压缩和增强等任务。其核心思想是存

世界建模已成为人工智慧研究的基石,使智能体能够理解、表示并预测其所处的动态环境。以往的研究大多强调针对2D 图像和视频数据的生成式方法,却忽视了快速增长的、基于原生 3D 与 4D 表示(如 RGB-D 影像、占据网格、LiDAR 点云)的 大规模场景建模研究。与此同时,由于缺乏对“世界模型”的标准化定义与分类体系,现有文献中出现了零散甚至不一致的论述。本综述旨在填补这一空白,首次对3D 与 4D

视觉基础模型 (VFM) 是在广泛的数据集上进行训练的,但通常仅限于 2D 图像,自然会出现一个问题:它们对 3D 世界的理解程度如何?由于架构和训练协议(即目标、代理任务)存在差异,迫切需要一个统一的框架来公平、全面地探究他们的 3D 感知。现有的 3D 探索工作主要关注单视图 2.5D 估计(例如深度和法线)或双视图稀疏 2D 对应(例如匹配和跟踪)。但是这些任务忽略了纹理感知,并且需要 3D

近年来的研究越来越关注通过利用注意力图的结构来降低稠密注意力的二次复杂度。然而,针对 LLM 的技术通常依赖自回归假设,例如推理时的因果掩码(causal masking)和 KV 缓存(KV-caching),这些方法不能直接应用于视觉模型中使用的连续二维 token 网格的注意力计算。一种更通用的方法是。

本文提出,一种基于像素空间扩散生成的单目深度估计模型,能够从预测的深度图中恢复高质量、无飞点(flying pixels)的点云。目前的生成式深度估计模型通常通过微调 Stable Diffusion 来实现出色的性能。然而,这类方法需要使用 VAE(变分自编码器)将深度图压缩到潜空间中,这一过程不可避免地会在边缘和细节处引入飞点伪影。我们的模型通过直接在像素空间中执行扩散生成,避免了由 VAE

三维高斯泼溅(3DGS)技术的最新进展在新视角合成任务中展现出非凡潜力。分治策略虽已实现大规模场景重建,但在场景分区、优化与融合环节仍存在显著挑战。本文提出BlockGaussian创新框架,通过内容感知的场景分割策略和可见性感知的区块优化技术,实现高效优质的大规模场景重建。具体而言,我们的方法基于不同区域的内容复杂度差异进行动态分区,从而平衡计算负载,提升重建效率。针对区块独立优化时的监督失配问