简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

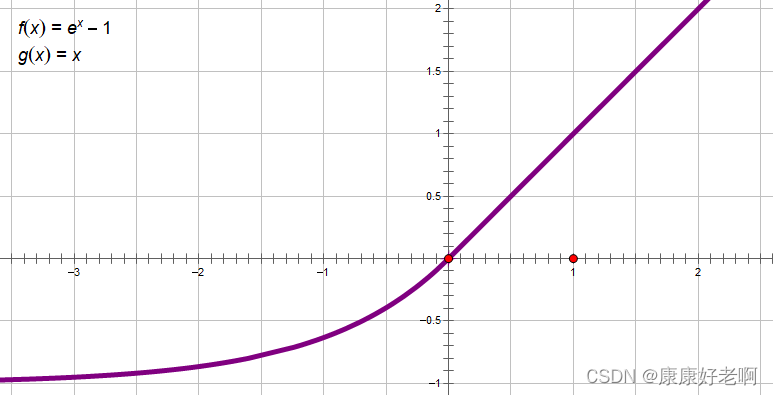

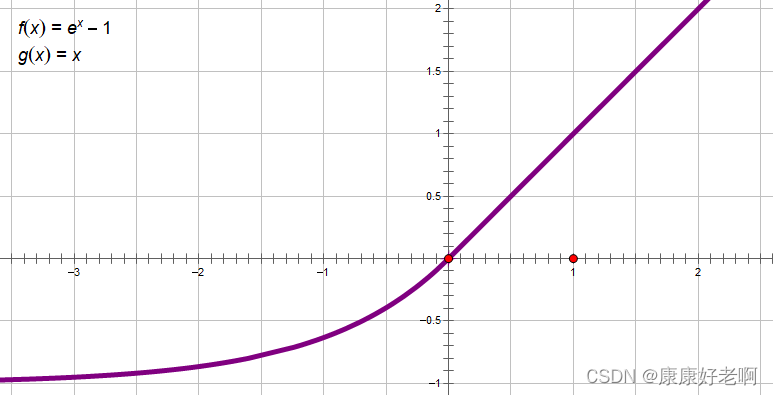

指数线性单元(ELU),全称Exponential Linear Units,使用了指数作为激活函数的一部分。

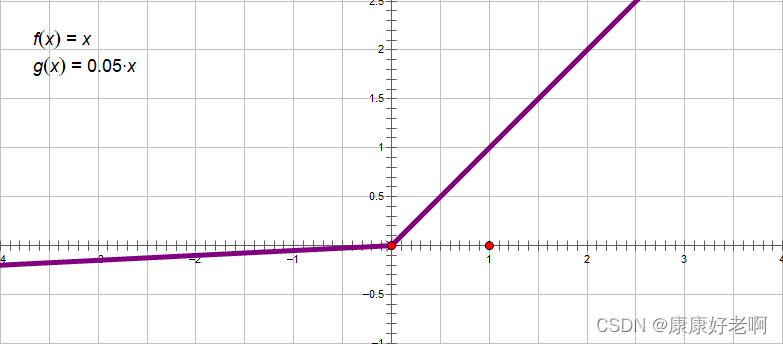

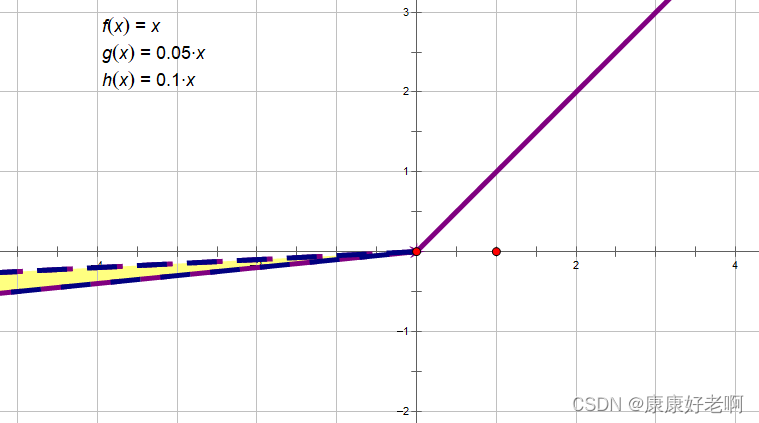

Leaky ReLU激活函数是为了解决ReLU激活函数会出现的dead relu神经元死亡的现象,而这一现象的根本原因是ReLU函数在x0的范围内梯度恒为0,无法更新参数。所以Leaky ReLU将x0的部分换成一个斜率很小的一个线性函数来解决这一问题。

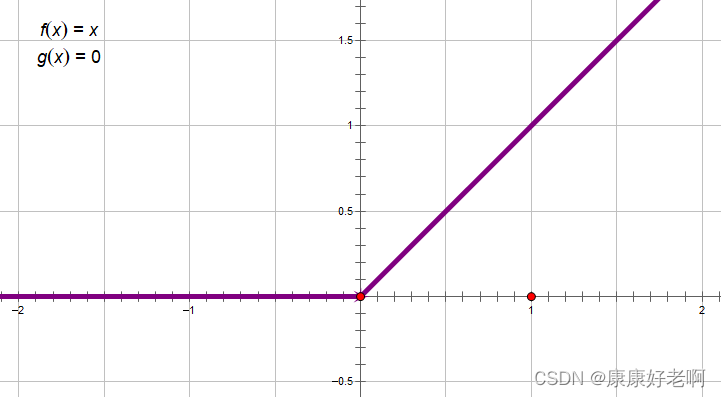

整流线性单元(ReLU),全称Rectified linear unit,是现代神经网络中最常用的激活函数,大多数前馈神经网络都默认使用该激活函数。

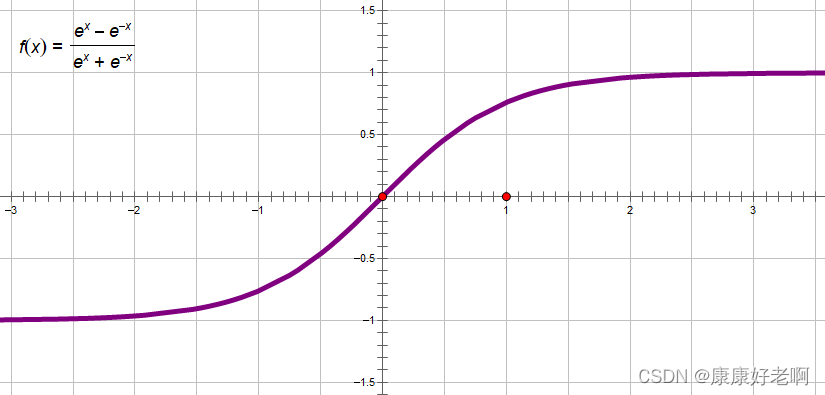

双曲正切1函数(tanh),其图像与sigmoid函数十分相近,相当于sigmoid函数的放大版。在实际的使用中,tanh函数要优先于sigmoid函数。

Sigmoid函数,又称logistic函数,是最早使用的激活函数之一。但是由于其固有存在的一些缺点,如今很少将其作为激活函数,但是依然常用于二分类问题中的概率划分。

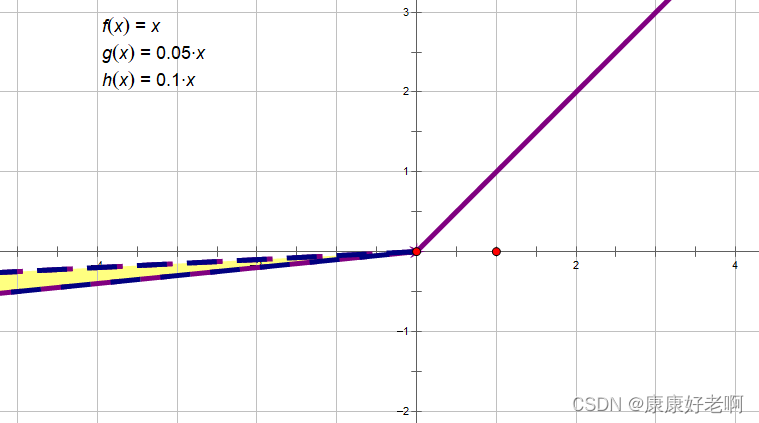

随机修正整流线性单元(RReLU),全称Randomized ReLU,是ReLU的延伸版,也是为了解决dead relu神经元坏死现象而提出的一种激活函数。

Sigmoid函数,又称logistic函数,是最早使用的激活函数之一。但是由于其固有存在的一些缺点,如今很少将其作为激活函数,但是依然常用于二分类问题中的概率划分。

随机修正整流线性单元(RReLU),全称Randomized ReLU,是ReLU的延伸版,也是为了解决dead relu神经元坏死现象而提出的一种激活函数。

Sigmoid函数,又称logistic函数,是最早使用的激活函数之一。但是由于其固有存在的一些缺点,如今很少将其作为激活函数,但是依然常用于二分类问题中的概率划分。

指数线性单元(ELU),全称Exponential Linear Units,使用了指数作为激活函数的一部分。