简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

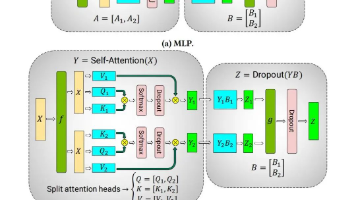

在深度学习训练中,单个GPU的内存限制引发了数据并行(DP)和模型并行(TP/PP/EP/SP)的需求。数据并行适用于模型小但数据量大的情况,通过切分数据到不同卡上计算并汇总,效率高但仅适用于微小模型。模型并行则用于大模型,通过切分模型到多张卡上,包括张量并行(TP)、流水线并行(PP)、专家并行(EP)和序列并行(SP)。张量并行通过切分模型内部的参数矩阵进行计算,但通信开销较大;流水线并行按层

教程是帮助自然语言处理(NLP)初学者快速熟悉 Transformers 库的使用方法,它通过具体的实例,一步步教你如何使用Transformers库来构建和调整模型,完成各种NLP任务,如文本分类、命名实体识别和机器翻译等。Transformers是Hugging Face开发的一个NLP工具包,支持加载大多数现有的预训练模型;(安全链接,放心点击)(安全链接,放心点击)

本系列文章是原作者Rohit Patel的长篇雄文《Understanding LLMs from Scratch Using Middle School Math-A self-contained, full explanation to inner workings of an LLM》的深度学习与解读笔记。本篇是系列第三篇。我们强烈建议您在开始前阅读并理解前文(点击下方目录)。全文目录:1.

理解Transformer的解码器首先要了解Encoder-Decoder框架。在原论文中Transformer用于解决机器翻译任务,机器翻译这种Seq2Seq问题通常以Encoder-Decoder框架来解决,Transformer的网络结构也是基于encoder-decoder框架设计的。这种框架的模型分为两部分编码器Encoder和解码器Decoder,编码器负责将原文本数据编码为中间状态向

本教材以自然语言处理中语言模型为主线,主要内容分为三部分,包括语言模型基础、大模型理论和大模型实践。在此之前,首先介绍了自然语言处理的背景知识。然后,在语言模型基础部分介绍了词向量、统计语言模型、神经语言模型和预训练语言模型。接着,在大模型理论部分介绍大模型的架构、训练、使用与评估等。最后,在大模型实践部分介绍了大模型的本地开发和应用开发等。

通过对大模型产品架构的逐层解析,我们可以看到大模型如何从落地场景逐步走向技术实现。从智能办公到智能客服,应用场景广泛;从提示词管理到模型调优,技术支持强大;再到知识库的支撑与模型服务的输出,形成了一个智能化闭环。大模型的架构不仅是技术的体现,更是为解决实际业务问题提供了多方位的支持。未来,大模型将在更多领域中落地,推动智能化的进一步发展,助力企业提高效率、降低成本,实现业务的全面升级。

从Java开发转向AI大模型开发,需要系统地学习和掌握一系列新的技术和算法。①人工智能/大模型学习路线②AI产品经理入门指南③大模型方向必读书籍PDF版④超详细海量大模型实战项目⑤LLM大模型系统学习教程⑥640套-AI大模型报告合集⑦从0-1入门大模型教程视频⑧AGI大模型技术公开课名额在转行过程中,除了技术层面的准备,还需要逐渐建立起AI产品思维,思考如何将模型转化为可行的产品和服务,这可能涉

脉脉创始人兼CEO林凡认为,**与移动互联网时代的疯狂“抢人”不同,大模型领域在人才争夺上显得更为理性,同时,大模型人才选择企业时考量的因素也变的更多元。现如今大模型岗位需求越来越大,但是相关岗位人才难求,薪资持续走高,AI运营薪资平均值约18457元,AI工程师薪资平均值约37336元,大模型算法薪资平均值约39607元。同时,职场人也应借鉴大模型的学习机制,追求更高效的工作方式,把每次工作结果

技术的演进所经历的阶段宛如一个轮回,回顾2011年,全球化移动应用市场大门打开之际,掘金海外还是瞄准国内市场、专注iOS还是Android亦或者是HTML5跨平台开发等都成为开发者抉择的方向。12年后,开发者再次站在选择的十字路口,正如技术社区三倍速定律所彰显的那样,“一个技术要进入到真正的生态应用里,首先是在学术界被大家认可,接着进入到工程界,最后才进入大众视野。因此技术社区的动向往往能反映出未

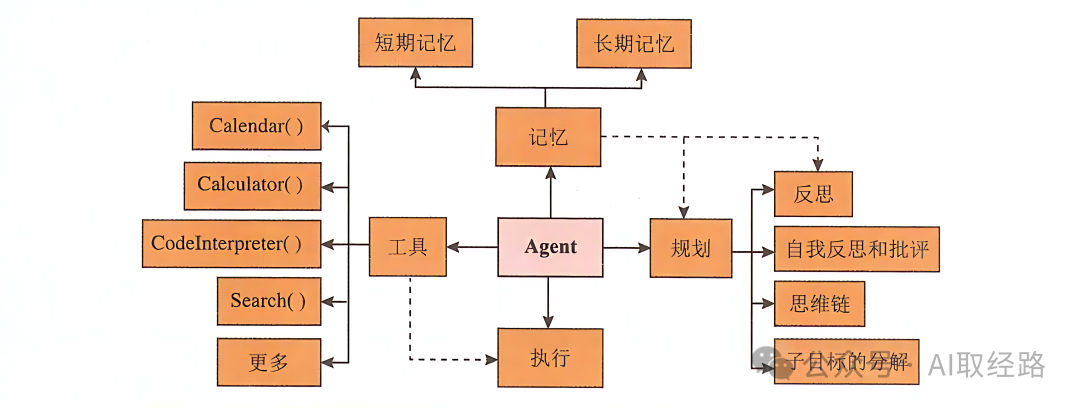

AI Agent,即人工智能代理,一般直接叫做智能体。它是一种能够感知环境、做出决策并采取行动的系统。这些系统能够执行被动的任务,也能够主动寻找解决问题的方法,适应环境的变化,并在没有人类直接干预的情况下做出决策。