简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

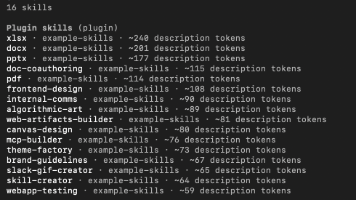

这时,模型加载skill.md需要先加载头部介绍,具体执行时再加载详细的信息,而执行scripts脚本时,又需要加载执行引擎执行脚本,因为模型本身是没有能力执行代码的。从使用者的角度来看,我们只需要在一些客户端中按照要求安装技能,即可使用,比较典型的就是claude code客户端,其集成了大量的技能库给用户使用;但是有了skills之后,就制定了一种规范,把要执行的任务所需要的所有东西都放到一个

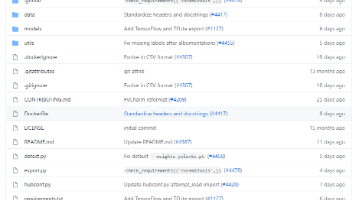

将我们下载好的yolov5的代码解压,然后用一款IDE打开(我用的是pycharm),打开之后整个代码目录如下图:├── data:主要是存放一些超参数的配置文件(这些文件(yaml文件)是用来配置训练集和测试集还有验证集的路径的,其中还包括目标检测的种类数和种类的名称);还有一些官方提供测试的图片。如果是训练自己的数据集的话,那么就需要修改其中的yaml文件。但是自己的数据集不建议放在这个路径下

是一个包装类,它包含了一个泛型 T 的值,或者是一个空值。它的核心思想是鼓励显式处理空值,而不是让程序在运行时抛出。Optional是 Java 8 引入的一个非常实用的类,它帮助我们以一种更优雅、安全的方式来处理可能为 null 的值。虽然它不能完全取代 null,但在适当的地方使用 Optional 可以显著提高代码的可读性和健壮性。如何创建和操作 Optional;如何安全地获取值;如何进行

新建扫描——网站扫描——网站爬行——目标查找——目标探测——子域名扫描——SQL盲注——HTTP编辑——HTTP嗅探——HTTP Fuzzer——认证测试——结果对比——WSDL扫描——WSDL编辑测试——程序设置——扫描设置——侧重扫描设置——计划任务——报告。点击Start对所输入的URL进行爬取,但是有的页面需要登录,不登录有些文件爬不到,就可以选择可以登录的login sequence进行

Spring Boot 毕业设计管理系统通常采用分层架构设计,结合前后端技术实现全栈开发。

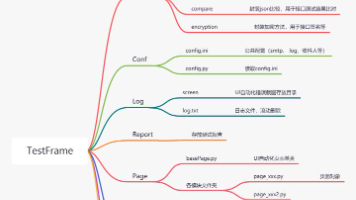

页面定义方式PO对象定义:京东主页面定义了搜索框和搜索按钮,以name为关键字,定义元素定位方式和执行的动作。测试数据定义方式。

平常用的是java8,最近在学习java的新特性。这就需要从java8往更高的java版本切换。由于还在使用java8,测试完新特性后我需要再切换回java8。

自动完成或代码生成功能已在开发工具中存在多年。早在 1996 年,微软就在 Visual Studio 中为 Visual Basic 引入了这一功能(IntelliSense)。熟悉 Eclipse 的人可能使用过 Java getter 和 setter 生成函数,以及变量名的字符串导出函数(著名的“public String toString()”函数)。提供下一行代码仍然是这些 IDE 工

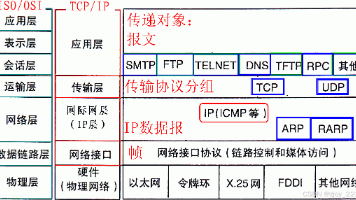

计算机网路学习的核心内容是网络协议的学习。网络协议是为计算机网络中进行数据交换而建立的规则,标准或者说是约定的集合。因为不同用户的数据终端可能采取的字符集是不同的,两者需要进行通信,必须要在一定的标准上进行就好比不同地区的人需要用普通话来进行交流一样。同样,放眼全球,我们与外国友人沟通的标准语言是英语,所以我们才要苦逼的学习英语。所以,不同的协议就好比我们的语言一样,是多种多样的,不过最为著名的就

与 Windows 或 MacOS 中单击和拖动文件不同,在 Linux 中,我们通常通过在终端中键入命令来处理文件。