简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

2025 年结束了才发现自己已经很久没有更新文章了。但最近都在忙其他的事情,实在没有多余的精力去写新的分享了(但笔记还是会记录,看看什么时候再分享出来吧)。于是我在重新整理以前的笔记发现,其实有很多都还没有分享过,不如趁此机会都给大家分享一下吧。也许分享的内容有点旧了,但还是希望自己的经验能够帮到更多的人。2020 年我做过一阵子“独立开发者”,并选择将 GitLab Community Edit

在真正开讲之前需要补充一下“16. 基于 CPU 的转换、量化实现”和“18. 持续优化模型微调”中遗漏的信息。

而 Tabula 的 SpreadsheetExtractionAlgorithm 算法是处理这种问题的最佳起点,但它提取的结果会是“不规则”的,即每行的单元格数量可能不同。因此本次将采用后处理的方式进行解析,Tabula 更多的只是作内容提取,表格组织还是在后期处理进行的。本次解决问题的核心思路就是通过计算每一个单元格完整的边界框,得到它的 top,left, bottom,right。同理,通

select value from v$parameter where name = 'processes';

若输出数字已科学计数法输出,则可以用to_char去解决select to_char('65647.2657696732665873677469045687295023',999990.999999999999999)from dual;

调研过很多的自动化UI测试工具要不太贵要不功能感觉不是自己想要的,于是自己动手丰衣足食。第一次写Python有写得不好的地方多多包涵......

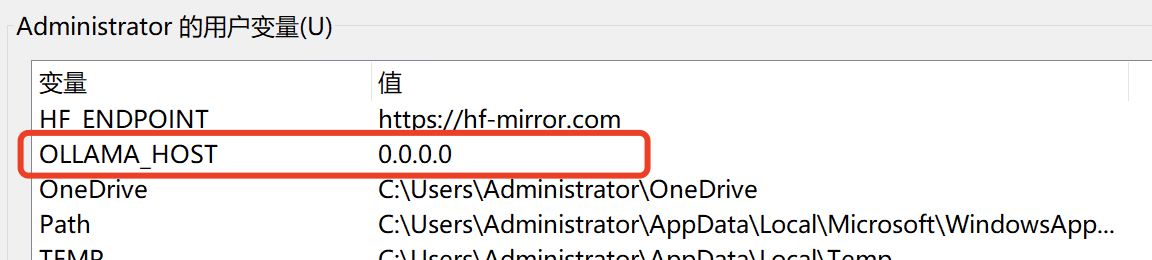

本文将记录部署过程中遇到的问题以及解决方式,希望对你有所帮助(open-webui 采用 docker 进行部署)。

重点来了,今天给各位详细讲解关于Besu节点的部署实施并使用到Besu特有的QBFT和IBFT2.0两种共识机制。

有小伙伴私信说希望能展开说说如何做模型持续优化,为此临时加开一章,讲讲如何结合 brain-mix 项目的 Unsloth 微调报告进行训练结果分析。首先我们在超参数不变的前提下做三轮训练,每次训练只增加训练数据,看看三轮下来的效果如何。通过损失率(Loss)稳定下降得知,当前模型处于“欠拟合”或者说学习不足的状态。这意味着模型的容量(由 LoRA 参数的 r 决定)可以学习更复杂的模式,但它还没

于是最终就变成了,写个自动化脚本遍历所有问答退,并使用 3 个大模型同为一条问答对进行评分,最终取平均分为最终得分(由于大模型各自的机制不一样,若只用一种大模型进行评分未免有些偏颇,既然这样我就同时用 3 个大模型进行评分,效果要好一点)。至于后面根据平均分字段进行删除的就不再将代码贴上来了,各位有兴趣可以到我的 gitee 或者 github 仓库中查阅吧(就根据所有记录“平均分”字段汇总做一个