简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

《Python+openpyxl导出海量数据到Excel的性能优化指南》介绍了处理大数据量Excel导出的关键技术。文章针对openpyxl在处理10万条以上数据时的内存溢出与速度问题,提出分块处理、关闭冗余功能、启用只写模式等优化方案。通过具体代码示例演示了10万条数据的分块导出实现(耗时降至4.3秒)和100万+数据的"数据库分页+流式写入"进阶方案。关键优化点包括:500

本文对比分析了传统RAG与AgenticRAG的技术差异。传统RAG采用固定的"检索-生成"线性流程,而AgenticRAG通过智能代理机制引入规划器(Planner)和多步决策能力,支持查询重写、多轮检索等动态优化操作。核心实现上,AgenticRAG的检索器结合上下文动态调整结果,生成器融入处理历史增强解释性,并新增规划器组件。性能测试表明,AgenticRAG在处理复杂查

MCP与Agent协同构建大模型应用核心框架:MCP作为模块化组件平台,通过标准化封装(天气查询、邮件发送等功能组件)解决能力碎片化问题;Agent则作为智能决策中枢,基于大模型进行任务拆解与组件调度。两者形成"Agent决策-MCP执行"的闭环,实现从用户需求到任务落地的完整流程。初学者可从搭建基础MCP接口和开发简单Agent入手,逐步构建复杂任务处理系统。该架构显著降低大

本文介绍了基于Ollama+DeepSeek+Dify的本地大模型部署方案。该方案采用三层架构:Ollama作为模型运行时管理DeepSeek模型,Dify提供交互界面。文章详细讲解了环境搭建步骤、模型注册方法,以及通过量化技术(如q4_0量化可减少内存占用至5GB)和缓存策略(Redis缓存)实现的性能优化。重点解决了API适配、权限控制等协同工作问题,并展示了如何通过自定义工具扩展模型能力。该

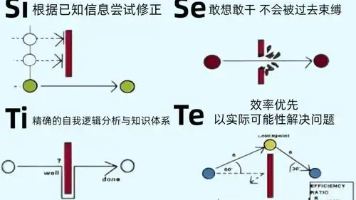

本文从程序员视角探讨了使用VB开发荣格八维多智能体分析系统的技术方案。系统采用分层架构设计,包含智能体基类、协调器组件和数据模型,通过事件驱动机制实现松耦合协作。文章详细介绍了外倾思考(Te)智能体的算法实现,包括问题权重配置、得分标准化和解释生成逻辑。系统整合部分展示了后台分析处理、结果可视化界面和人格类型建议功能。该方案为心理学工具开发提供了可扩展的技术参考。

本文探讨了AI虚拟主播角色提示词的技术架构与实现方法。文章提出模块化设计思路,将虚拟主播人格特征拆解为身份、语言、行为、知识四大模块,通过结构化提示词实现精准控制。开发了提示词生成器、对话规则引擎等组件,构建完整的工程化框架。文章还介绍了角色一致性监控和动态调优策略,通过量化评估持续优化AI表现。这套方法可帮助开发者高效打造个性化的虚拟主播形象,提升AI交互的自然度和情感表现力。

Qwen3-"SmVL"是一款针对中文场景优化的超小型多模态大模型,通过创新架构和精细调优,在仅1.8B参数规模下实现了媲美更大模型的中文图文理解能力。其核心创新包括:1)采用模块化拼接架构,将文本理解、图像编码和跨模态融合拆分为独立可优化模块;2)设计中文语义-视觉对齐损失函数,强化汉字特征与视觉内容的关联;3)构建包含800万样本的中文多模态数据集,并针对中文特性优化数据处

本文详细介绍了在uniApp开发中存储和传递数组对象的方法。通过uni.setStorageSync实现本地缓存时,需将数组对象转为JSON字符串存储,读取时再解析回原格式;使用uni.navigateTo页面跳转传参时,需先对数据进行序列化和URL编码。文章提供两种实战方案:直接传参适合小数据量场景;"缓存+标识"方案适用于大数据量传输。关键注意事项包括异常捕获、URL编解码

本文深入解析了npm与npx的核心区别及mcp中npx的加载原理。npm是包管理工具,负责依赖安装与维护;npx则是包执行器,支持"即用即走"的执行方式。在mcp项目中,npx通过三阶段加载机制(依赖检测、环境注入、执行缓存)实现高效组件管理。文章对比了两者的使用场景,并提供了mcp项目中的最佳实践建议,帮助开发者优化工作流程。掌握这些工具特性,能够提升开发效率,特别是在复杂的

摘要:OpenAI的PromptCaching机制通过智能缓存策略显著降低大模型API调用成本,可减少30%-50%费用并提升60%响应速度。本文详解三级缓存架构(内存/分布式/持久化)实现方案,包括哈希键生成、语义匹配算法和实战优化技巧。某电商案例显示,采用多级缓存后API调用量下降42%,延迟从800ms降至150ms。关键策略包含:分层TTL设置、缓存预热、智能降级和模块化Prompt设计,