简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

企业可以通过提供个性化服务、增加社交互动、改进用户体验等方式来提高用户留存率。:企业可以通过增加用户互动功能、改进用户界面、推出新功能等方式来增加用户参与度。通过提供高质量的产品和服务、优化付款流程以及提供定价策略等手段,也可以提高收入水平。可以应用于各种在线业务,包括电子商务、社交媒体、软件开发、应用程序等。:企业可以通过营销策略、社交媒体推广、搜索引擎优化等手段吸引潜在客户,将他们引入到网站或

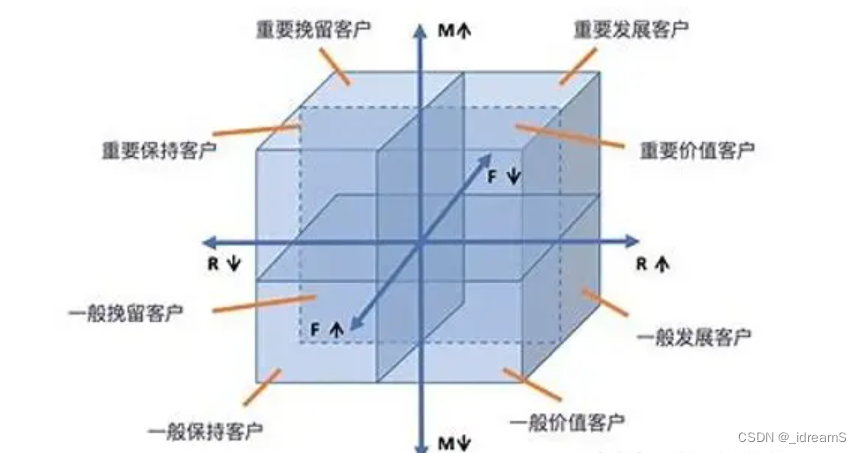

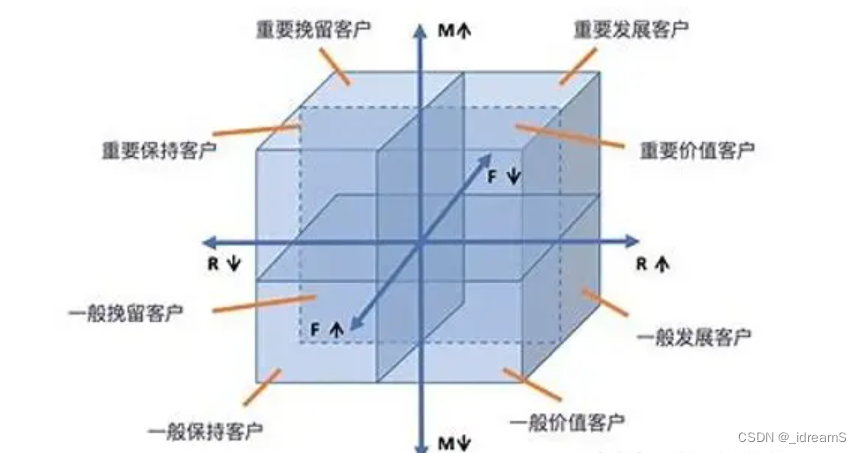

用户价值模型是一种常用的客户细分和价值评估模型,通过分析客户的最近一次购买时间(Recency)、购买频率(Frequency)和消费金额(Monetary)等指标,对客户进行分类和评估,识别出高价值客户和低价值客户,以便于制定针对性的营销策略和服务。根据以上打分表,对于每个客户可以根据其RFM指标的值得到相应的分数,然后将三个指标的分数加权或平均,得到客户的综合得分,根据综合得分将客户分为高价值

4. 数据预处理:数据预处理是数据分析的关键步骤之一。5. 模型建立和评估阶段:在这个阶段中,需要分配一定的精力来选择合适的模型、评估模型的性能和准确性,并进行模型调优。3. 探索性数据分析:在这个步骤中,需要对数据进行探索性分析,探索数据的分布、趋势、异常值等,以及各个变量之间的相关性。5. 模型建立:在这个步骤中,需要选择合适的模型,例如回归分析、分类分析、聚类分析等,根据数据特征和分析目的建

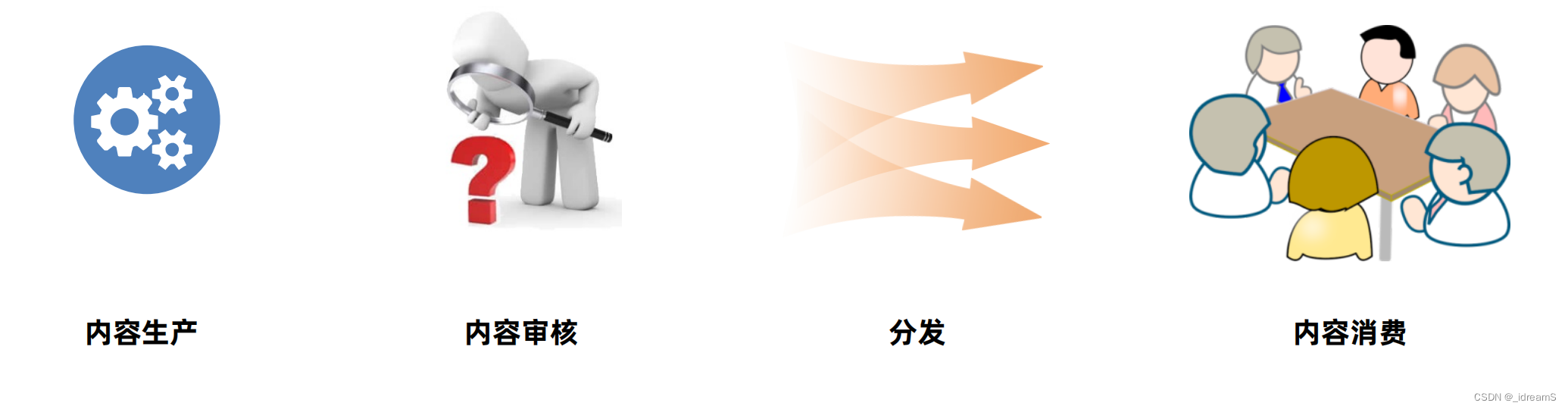

在内容产品生态中,核心就是内容,内容驱使着所有的角色运转。具体而言,在整个生态模型中,内容的链条从上游。传统的门户网站内容生产方式,内容多由官方工作人员身或者专业的内容创造者(比如新闻记者等)创造。UGC(User Generated Content)用户生产内容。一种新的内容生产方式,由产品使用者即互联网用户创造内容。内容质量参差不齐、需要建立健全的审核筛选机。可以创造海量内容,迎合不同的消费需

用户价值模型是一种常用的客户细分和价值评估模型,通过分析客户的最近一次购买时间(Recency)、购买频率(Frequency)和消费金额(Monetary)等指标,对客户进行分类和评估,识别出高价值客户和低价值客户,以便于制定针对性的营销策略和服务。根据以上打分表,对于每个客户可以根据其RFM指标的值得到相应的分数,然后将三个指标的分数加权或平均,得到客户的综合得分,根据综合得分将客户分为高价值

1. 实时数据传输:Kafka可以作为数据传输的桥梁,将不同应用程序之间的数据实时传输,如网站访问日志、传感器数据、移动设备数据等。4. 数据集成:Kafka可以作为数据集成的桥梁,将不同系统之间的数据集成起来,实现数据的共享和传输。2. 流处理:Kafka可以与流处理技术结合使用,进行实时数据处理和分析,如实时计算、实时报警等。1. 高吞吐量:Kafka可以处理非常高的消息吞吐量,可以达到每秒数

4. 数据预处理:数据预处理是数据分析的关键步骤之一。5. 模型建立和评估阶段:在这个阶段中,需要分配一定的精力来选择合适的模型、评估模型的性能和准确性,并进行模型调优。3. 探索性数据分析:在这个步骤中,需要对数据进行探索性分析,探索数据的分布、趋势、异常值等,以及各个变量之间的相关性。5. 模型建立:在这个步骤中,需要选择合适的模型,例如回归分析、分类分析、聚类分析等,根据数据特征和分析目的建