简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

最后,发现,这些文章均发表于2024。怀疑新版本的安装包有问题。毅然决然,重做系统,把以前版本的安装包找出来。然后,啥问题也没有,顺利安装成功。耽误了我几个小时,重装系统3次。最初以为是自己安装的选项有问题,没办法,重装系统,重新安装,特别百度安装过程,每一步小心选择。然后,百度报错信息。csdn给出很多解决方案。1,安装包是刚从官网下的。2,版本5.7.44.

SSD,全称Single Shot MultiBox Detector,是Wei Liu在ECCV 2016上提出的一种目标检测算法。使用Nvidia Titan X在VOC 2007测试集上,SSD对于输入尺寸300x300的网络,达到74.3%mAP(mean Average Precision)以及59FPS;对于512x512的网络,达到了76.9%mAP ,超越当时最强的Faster R

通常情况下,直接加载的原始数据并不能直接送入神经网络进行训练,此时我们需要对其进行数据预处理。这个意思,就是说,拍出来的照片,在喂给程序进行训练前,需要进行人工的某种程度的干预。让机器更容易处理。就像是,照片如果拍得模糊的话,可能用这种数据进行训练,可能会得出错误的算法吧?打个不是很贴切的比喻,机器学习,就像小孩子的成长,小孩子如果尽看到的是不好的东西,也许会长歪了?所以我们可以给小孩子讲故事?这

课程已经学完了,打算再深入一些。初步的想法是,在本地安装,本地执行。根据老师的指引,,“https ://www.mindspore.cn/install/”,注意,因为csdn博客编辑器的原因,当我把链接粘贴过来的时候,链接就自动的变为隐藏在蓝色文字背后的url了。所以我在https后面多加了一个空格,以便显著显示链接文本,以及复制。结果,由于没有认真的通读按照指南,想当然的认为,服务器用cen

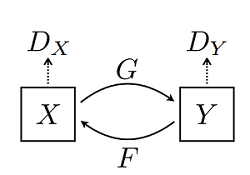

CycleGAN(Cycle Generative Adversarial Network) 即循环对抗生成网络,来自论文。该模型实现了一种在没有配对示例的情况下学习将图像从源域 X 转换到目标域 Y 的方法。该模型一个重要应用领域是域迁移(Domain Adaptation),可以通俗地理解为图像风格迁移。

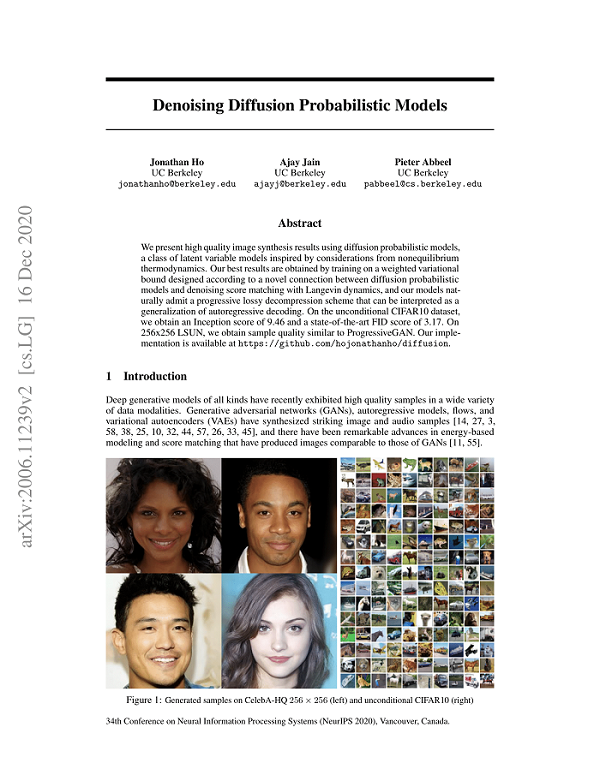

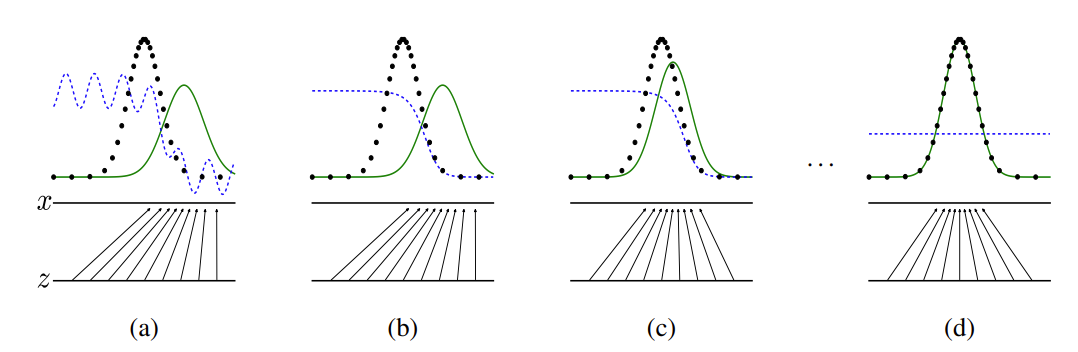

如果将Diffusion与其他生成模型(如Normalizing Flows、GAN或VAE)进行比较,它并没有那么复杂,它们都将噪声从一些简单分布转换为数据样本,Diffusion也是从纯噪声开始通过一个神经网络学习逐步去噪,最终得到一个实际图像。Diffusion对于图像的处理包括以下两个过程:我们选择的固定(或预定义)正向扩散过程 𝑞𝑞 :它逐渐将高斯噪声添加到图像中,直到最终得到纯噪声

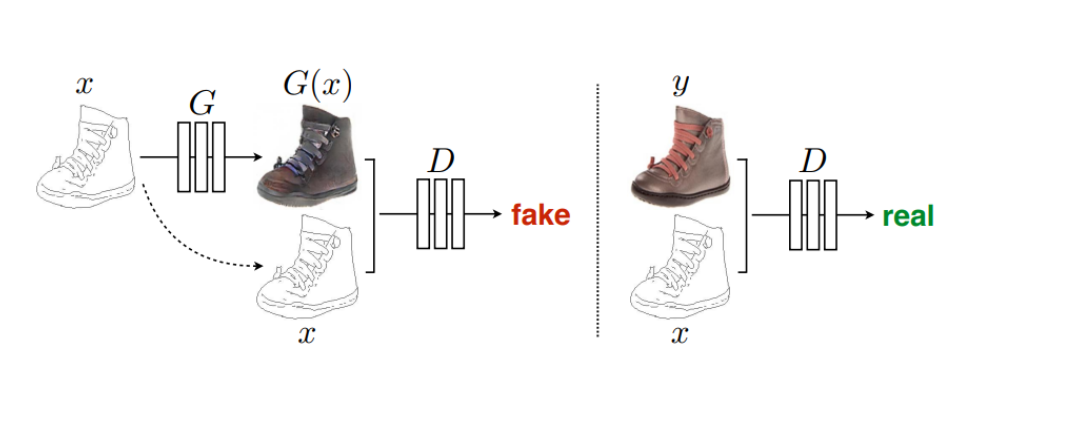

Pix2Pix是基于条件生成对抗网络(cGAN, Condition Generative Adversarial Networks )实现的一种深度学习图像转换模型,该模型是由Phillip Isola等作者在2017年CVPR上提出的,可以实现语义/标签到真实图片、灰度图到彩色图、航空图到地图、白天到黑夜、线稿图到实物图的转换。生成器和判别器。传统上,尽管此类任务的目标都是相同的从像素预测像素

生成式对抗网络(Generative Adversarial Networks,GAN)是一种生成式机器学习模型,是近年来复杂分布上无监督学习最具前景的方法之一。最初,GAN由Ian J. Goodfellow于2014年发明,并在论文生成器的任务是生成看起来像训练图像的“假”图像;判别器需要判断从生成器输出的图像是真实的训练图像还是虚假的图像。GAN通过设计生成模型和判别模型这两个模块,使其互相

与传统方法不同,MusicGen采用单个stage的Transformer LM结合高效的token交织模式,取消了多层级的多个模型结构,例如分层或上采样,这使得MusicGen能够生成单声道和立体声的高质量音乐样本,同时提供更好的生成输出控制。掌握了视觉处理的工具之后,开始学习音频处理的工具,这个课程学的是MusicGen。MusicGen是来自Meta AI的Jade Copet等人提出的基于

序列标注指给定输入序列,给序列中每个Token进行标注标签的过程。序列标注问题通常用于从文本中进行信息抽取,包括分词(Word Segmentation)、词性标注(Position Tagging)、命名实体识别(Named Entity Recognition, NER)等。输入序列清华大学座落于首都北京输出标注BIIIOOOOOBI如上表所示,清华大学和北京是地名,需要将其识别,我们对每个输