简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

引言此系列重点在于复现计算机视觉()中,以便初学者使用(浅入深出)!首先复现深度学习的经典分类网络模块,其中专门做目标检测的Backbone(10.,11.)但是它的主要目的是用来提取特征所以也放在这里,有2.VGG(√)5.ResNeXt10.VovNet11.DarkNet...注意a)完整代码上传至我的githubhttpshttpsb)编译环境设置为(其实不用这个编译环境,你会调bug也行

本章博客就是对OpenPose工具包进行开发;我呕心沥血(笑哭),经历重重困难,想放弃了很多次(因为openpose的编译实在是太麻烦了)但是后来还是成功了,各位点个赞吧!这个真的太麻烦了。按照单帧图像和实时视频的顺序述写,其中单帧是使用的Pytorch编程只是调用OpenPose的模型;实时视频中使用Python调用OpenPose的包,所以必须得安装OpenPose,并对其进行编译,最后再使用

**1**.Ready modelLeNet_5.pyfrom torch import nnclass LeNet_5(nn.Module):def __init__(self):super(LeNet_5, self).__init__()self.model = nn.Sequential(# input:3@32x32# 6@28x28nn.Conv2d(in

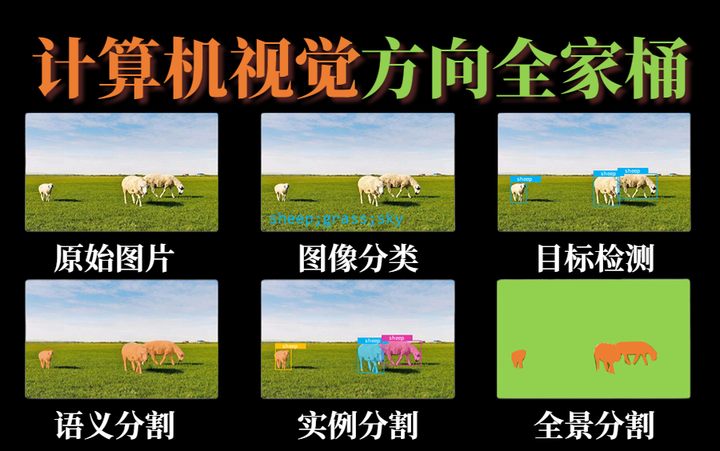

是一门让计算机学会“看”的学科,研究如何自动理解图像和视频中的内容。

模型的保存有两种方式:一种是保存模型;另一种是保存模型的参数,将参数以字典的形式保存(官方推荐)。There are two ways to save the model: one is to save the model; the other is to save the parameters of the model, and save the parameters in the form o

运行结果MediaPipe人体姿态估计效果展示demo_video.pysrc/util.pysrc/hand.pysrc/body.py运行结果OpenPose效果展示需要安装OpenPose,请看我的另一篇博客:3D视觉——2.人体姿态估计(Pose Estimation)入门——OpenPose含安装、编译、使用(单帧、实时视频)运行结果OpenPose运行结果其实:1.MediaPipe比

申明此篇博文是以AlexNet为网络架构(其需要输入的图像大小为227x227x3),CIFAR10为数据集,SGD为梯度下降函数举例。运行此程序时,文件的结构:/content/drive/MyDrive/coder/Simple-CV-Pytorch-master||||----AlexNet----train.py(train_adjust_learning_rate.py,train_Mu

如果使用cuda进行训练,则需要在以下三个地方进行修改,告诉计算机使用的是cuda,并且有两种方式(待会再讲):If using cuda for training, you need to modify the following three places to tell the computer to use cuda, and there are two ways (more on this

申明此篇博文是以AlexNet为网络架构(其需要输入的图像大小为227x227x3),CIFAR10为数据集,SGD为梯度下降函数举例。运行此程序时,文件的结构:/content/drive/MyDrive/coder/Simple-CV-Pytorch-master||||----AlexNet----train.py(train_adjust_learning_rate.py,train_Mu

接上一章 手把手教你北邮操作系统小学期实验五——Linux环境下的Ramdisk技术及其实验2此实验是我做的。1.实验环境:硬件:Intel i5操作系统:Windows 8.1虚拟机:VMware Workstation 12.5.0软件:Red Hat Enterprise Linux 9 (Linux 内核 2.4.20-8)2.实验目的:实时嵌入式应用常常需要数据库的支持。虽然很多情况下可