简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

MiniMax发布大模型M2,成本仅为Claude的8%,性能全球前五。采用混合专家架构,2300亿参数仅激活100亿,实现低成本高性能。支持编程、智能体等多模态功能,Apache2.0协议开源允许商用。提供免费API调用,大幅降低AI使用门槛,推动AI普惠发展。

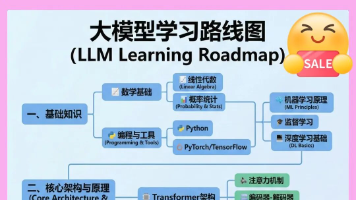

《大模型(LLM)学习路线图:从入门到精通》 本文提供了一份系统的大模型学习指南,分为四个阶段:初阶应用(10天)掌握提示工程与业务衔接;高阶应用(30天)学习RAG系统开发与知识库构建;模型训练(30天)掌握微调与多模态训练;商业闭环(20天)了解部署与商业化应用。资料包含思维导图、案例手册、视频教程等,帮助学习者从0到1掌握LLM核心技术。目前大模型岗位缺口达47万,初级工程师平均薪资28K,

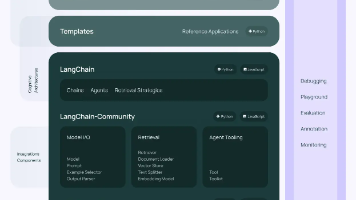

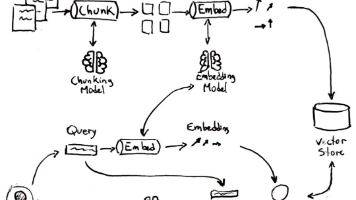

LangChain是一个基于大语言模型的开发框架,用于构建端到端语言模型应用。它提供六大核心组件:模型接口、提示模板、数据检索、记忆存储、任务链和智能代理,帮助开发者快速开发文本生成、文档问答等AI应用。LangChain包含多个开源库,如核心抽象层、社区集成、推理架构等,并支持通过LangSmith进行调试监控、LangServe部署API。其模块化设计简化了LLM应用从开发到部署的全流程,使构

【摘要】"世界模型"正成为人工智能领域的新焦点,从学术研究到商业应用都展现出巨大潜力。学术界从萨顿的Dyna架构到Meta的V-JEPA2,逐步突破传统AI的局限;产业界如NVIDIA更将其视为十万亿美元级机器人产业的关键。Yann LeCun等专家认为,世界模型能实现物理环境理解和因果推理,是通向自主智能的核心路径。随着大模型技术发展,掌握AI技能成为职业竞争关键,相关学习资

本文系统介绍了大模型的基础知识,包括LLM和多模态两大核心类型及其区别,开源与闭源模型的特点对比,以及内容生成、信息处理、创意辅助三大应用场景。文章通过生活化比喻和职场实例,帮助零基础读者理解大模型如何提升工作效率,并针对不同需求给出选择建议。特别强调清晰表达需求(prompt)的重要性,为读者提供了实用的大模型入门指南。

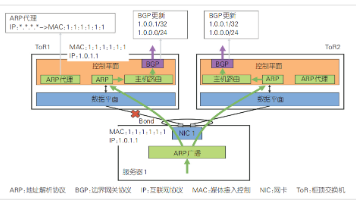

本文提出了一种非堆叠双ToR网络架构,用于提升大规模AI训练集群的可靠性和性能。通过将网卡双端口连接至独立ToR交换机并实现状态同步,解决了单ToR设计易受故障影响的问题。同时采用单芯片交换机、多轨组网和双平面设计,有效消除哈希偏极化,使15000卡集群实现400Gbps接入能力。实际测试显示,该架构使大模型训练性能提升14.9%,跨Segment流量减少37%。此外,文中还介绍了配套的AI大模型

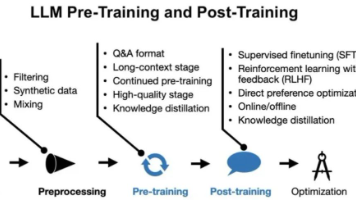

本文详细解析了大模型的三个关键阶段:训练(预训练和后训练)、微调和推理。训练是构建模型基础知识的阶段,需要海量数据和强大算力;微调则是针对特定领域优化模型,成本较低且周期短;推理是模型实际应用阶段,不再学习而是基于已有参数进行预测。三者从开发主体、数据需求、参数更新、成本和时间等方面各有不同,适用于不同场景和应用需求,为大模型的全生命周期提供了清晰指导。

GraphRAG是将知识图谱与传统RAG结合的创新方法,解决传统RAG将知识视为独立文本、难以处理复杂查询的问题。通过结构化知识与语言模型融合,GraphRAG提供更准确、更具上下文感知能力的AI回答。文章详细解释了知识图谱和本体论概念,展示GraphRAG工作原理、优势、挑战及相关工具框架,展望其未来应用前景。

本文详细介绍了使用Python开发MCP服务的完整流程,包括环境准备、Server开发、工具调试及Cherry Studio集成。通过FastMCP SDK实现了一个天气查询工具,展示了如何创建、测试和部署MCP服务。文章还提供了自定义Client的实现方法,帮助开发者理解MCP通信机制。无论是对AI工具感兴趣的小白还是有经验的开发者,都能通过本教程掌握MCP服务的开发与集成技巧。

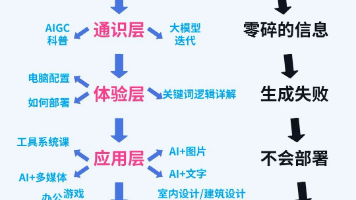

本文详细介绍了AIGC的5层系统化学习路径:通识层建立基础认知,体验层掌握工具部署,应用层进行多领域创作实践,商业层探索变现模式,原理层深入技术核心。文章强调循序渐进、重点突破的学习方法,推荐各阶段学习资源,指出常见学习误区,帮助学习者系统掌握AIGC技术,实现从入门到精通的跨越。