简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

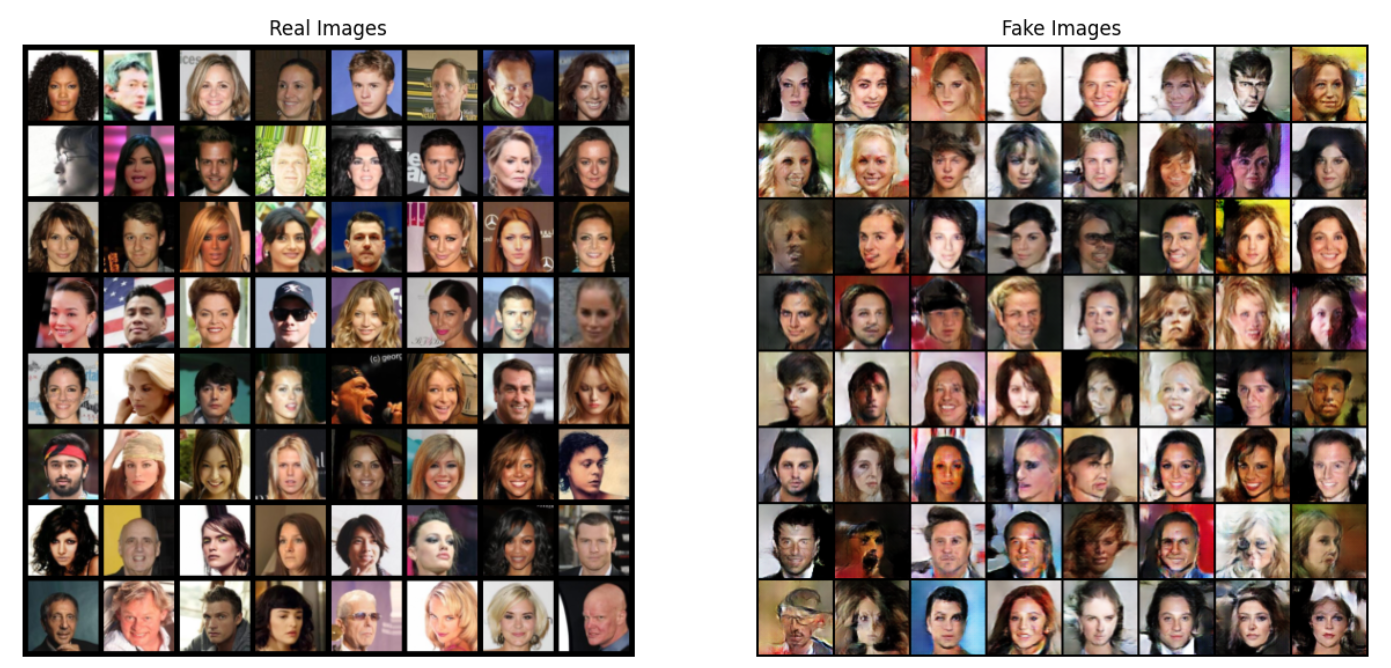

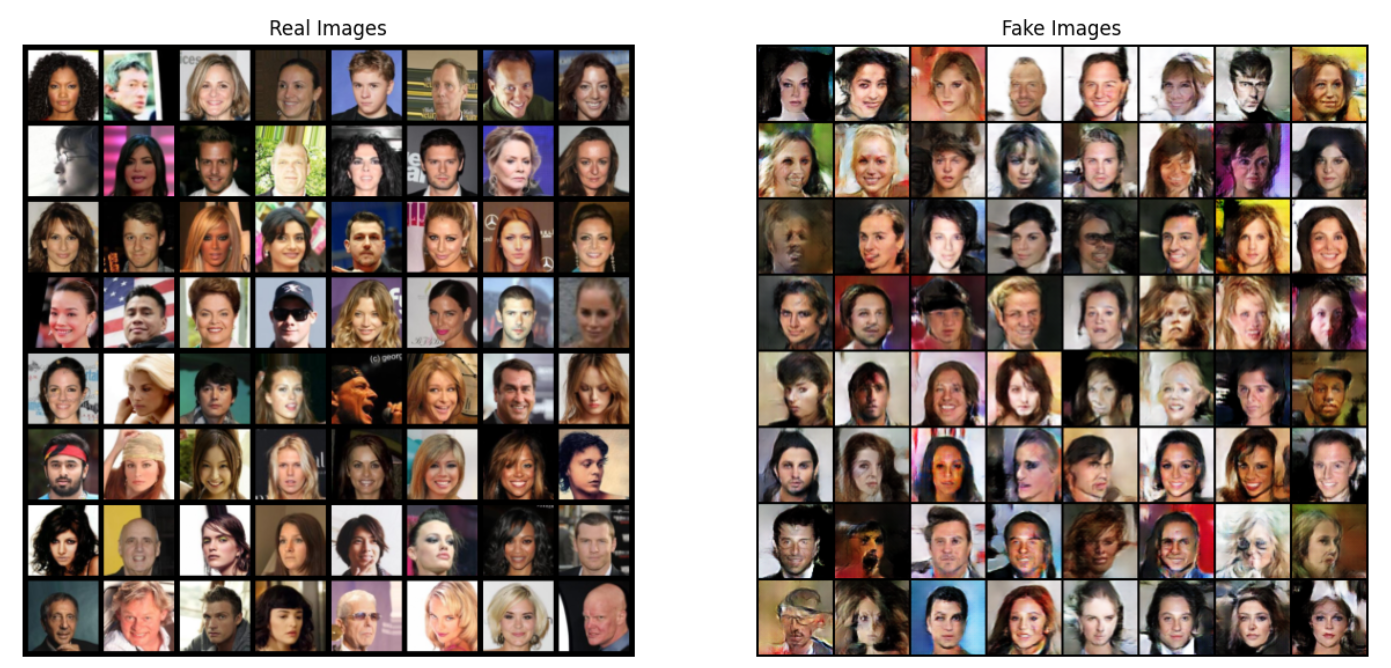

这篇文章主要是介绍了使用pytorch框架构建生成对抗网络GAN来生成虚假图像的原理与简单实例代码。数据集使用的是开源人脸图像数据集img_align_celeba,共1.34G。生成器与判别器模型均采用简单的卷积结构,代码参考了pytorch官网。

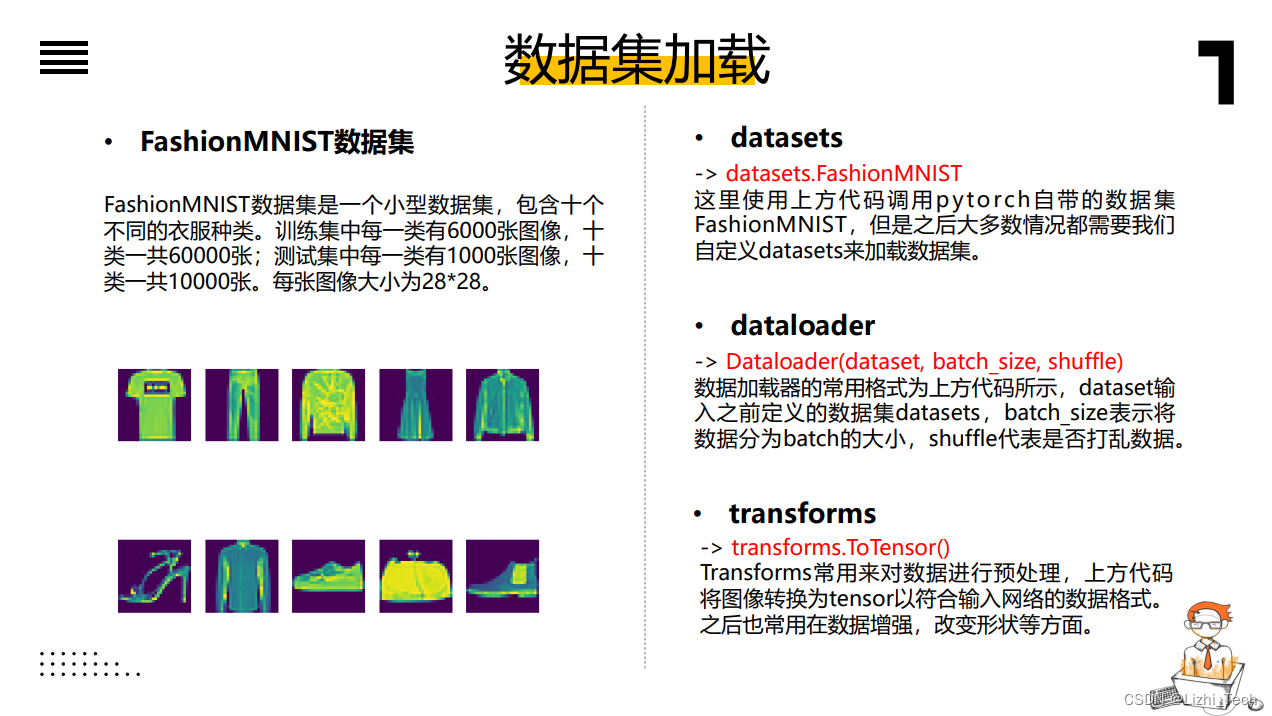

零基础pytorch深度学习安装使用代码实例新手教学

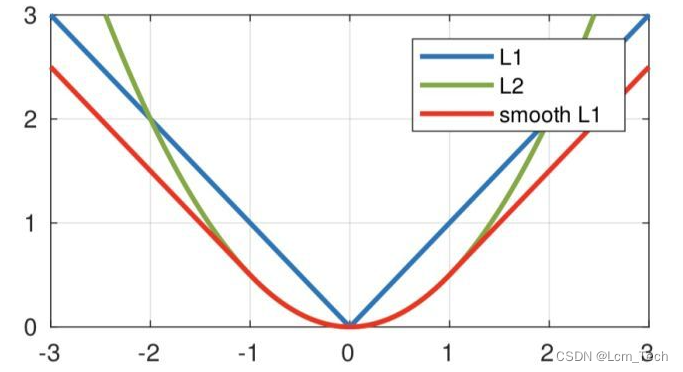

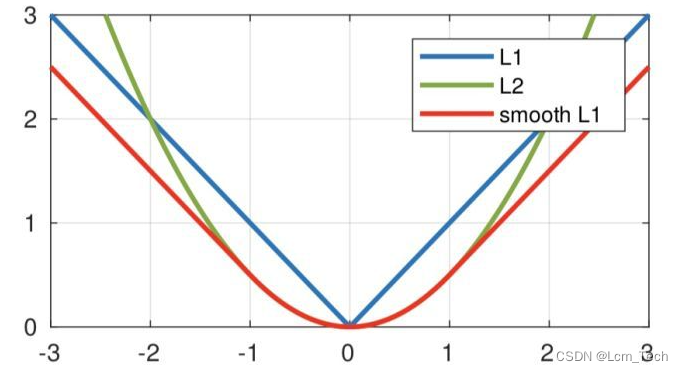

直入主题,这次来介绍L2loss的原理以及pytorch代码用法。

这篇文章主要是介绍了使用pytorch框架构建生成对抗网络GAN来生成虚假图像的原理与简单实例代码。数据集使用的是开源人脸图像数据集img_align_celeba,共1.34G。生成器与判别器模型均采用简单的卷积结构,代码参考了pytorch官网。

python鸢尾花数据基于sklearn使用不同的机器学习分类器,包括KNN、逻辑回归、决策树、梯度提升、AdaBoost、随机森林、高斯朴素贝叶斯、多项式朴素贝叶斯、线性判别分析、二次判别分析、支持向量机

之前介绍完了图像生成网络GAN和VAE,终于来到了Diffusion。stable diffusion里比较复杂,同时用到了diffusion,VAE,CLIP等模型,这里我们主要着重介绍diffusion网络本身。

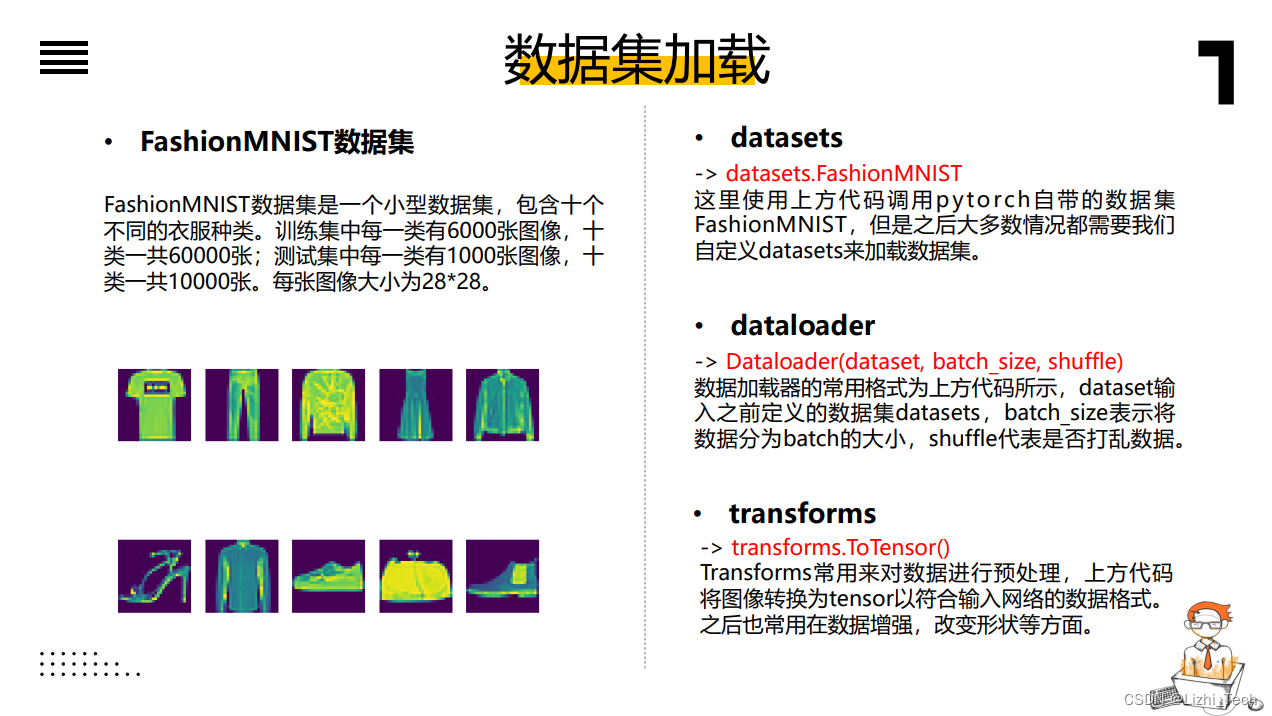

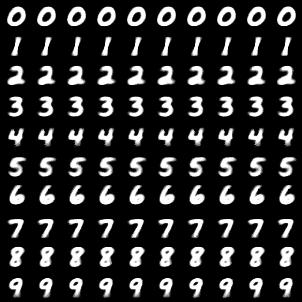

零基础pytorch深度学习安装使用代码实例新手教学

接下来就是CrossEntropyLoss了,在分类任务中经常用到。建议大家先看看上一篇NLLLoss的文章再来看这篇,会比较好理解。CrossEntropyLoss的计算公式如下:其中是每个类别的权重,默认的全为1,表示对应target那一类的概率。

在上一篇文章里,我们介绍了RMSProp,在AdaGrad的基础上引入了衰减量,从而解决不断地累加二阶动量导致最终学习率会接近于0以及训练提前终止的问题,AdaDelta在这基础上做了进一步改进。类似于RMSProp,也使用了衰减的方法使得二阶动量不会一直累加,公式如下:其中,为当前step的二阶动量,为上一个step的二阶动量,为历史二阶动量的衰减率。同时AdaDelta还不光考虑了二阶动量,还

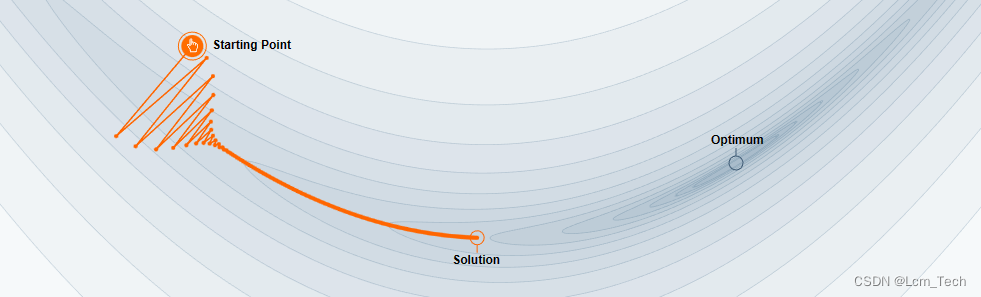

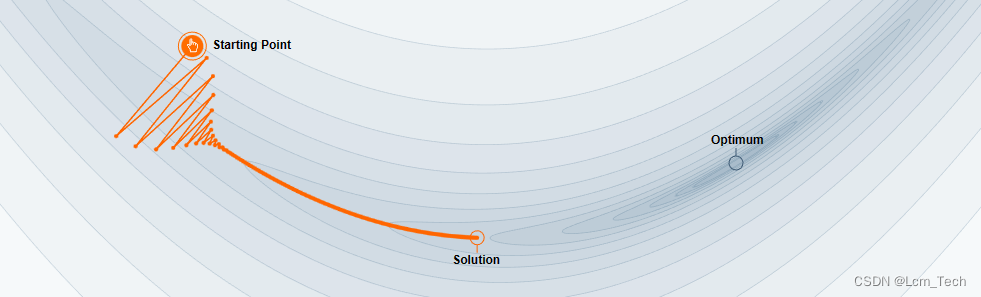

在上一篇文章里,我们介绍了SGD这个最朴素的梯度下降方法,以及其Momentum和NAG的优化改进方法。我们现在又回过头来看这个没加Momentum的图,可以看到在垂直方向上的梯度较大,走得很快,而水平方向上的位移较小,走的很慢,看着就很急!但你先别急,那么能不能不使用Momentum就让水平方向上的位移大一点,垂直方向上的位移小一点呢?我们想要迄今为止梯度大的参数(即垂直方向)更新得慢一点,梯度