简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

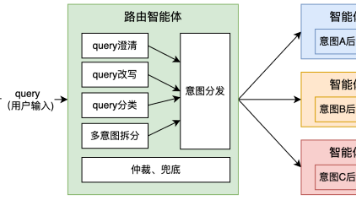

路由模块是自适应智能体系统设计中的关键控制机制,路由模块可以在智能体流程里的开始或中间的多个节点实现。可以用作分类用途,也可以用来选取调用合适的工具。在实际项目情况,一般建议先用大模型模式采用提示词路由快速验证分发能力,跑通流程。如果对精确度有更高要求,可以使用嵌入路由和小模型路由进行专门优化。实际项目里可能需要搭配着几种路由一起使用。比如需要对bad case做快速干预修复时可能就会用到规则路由

本文系统介绍AI编程工具的使用方法,从底层机制(Token计算、工具调用、Codebase索引)到实践应用(代码检索、绘图生成、问题排查)。详细讲解提升对话质量的规则设置与渐进式开发方法,并分享结合AI的编码最佳实践,包括文档规范、命名技巧和安全合规。内容兼顾不同经验水平开发者需求,帮助读者真正掌握AI编程工具,提升开发效率。本文从原理到实践系统地分享了如何高效使用AI编程工具。

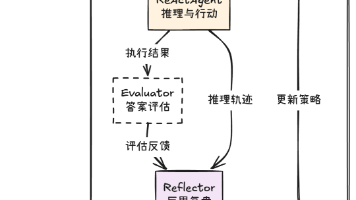

文章介绍了ACE(Agentic上下文工程)框架的原型实现,该框架通过上下文自我演化而非模型微调实现智能体"自学成长"。系统包含四个核心组件:Playbook(策略手册)存储学习策略;Generator(行动者)执行任务并生成推理轨迹;Reflector(复盘者)分析执行过程并提炼经验;Curator(策略管家)将反思转化为策略更新。文章详细展示了各模块实现逻辑、工作流组装与测试,并讨论了当前局限

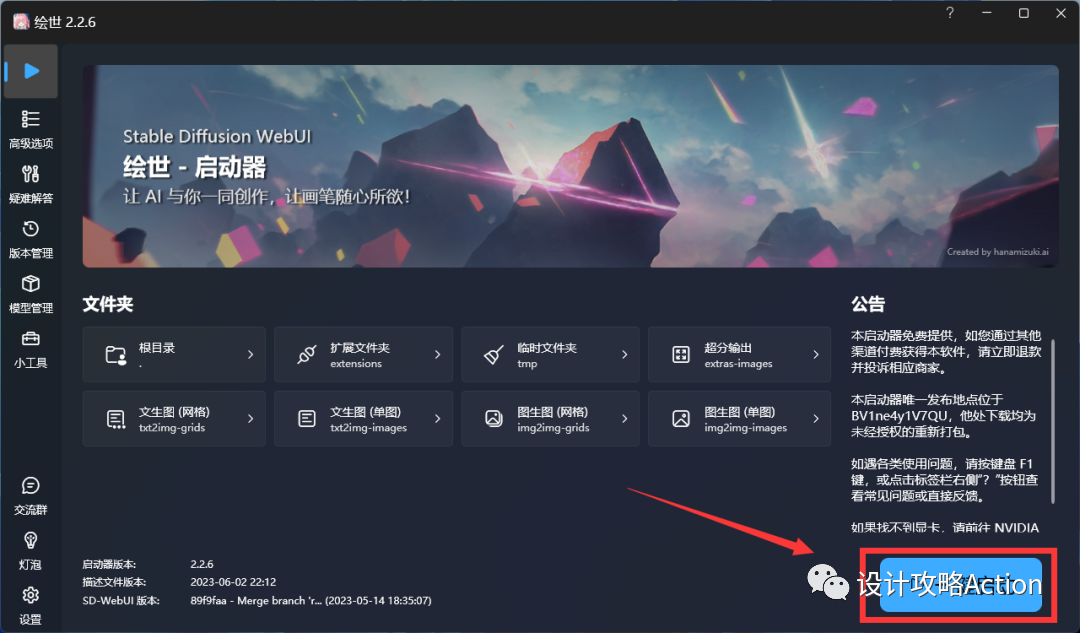

本文精心整理了 Stable Diffusion 的保姆级学习内容,同学请务必仔细学习,按以下步骤操作,助你快速掌握 Stable Diffusion 这款强大工具!Stable Diffusion,简称 SD,是当下最顶尖的 AI 绘图工具(AIGC)之一。它与 PS 类似,只需在本地电脑完成安装即可使用。不过,SD 对电脑配置要求较高,建议配备显存 6G 以上的 N 卡,且无需翻墙、无需注册。

在本文中,我们介绍了一种基于字幕的AI电影剪辑的方法的设计思路,它可以利用电影的字幕信息,来辅助AI分析电影的内容,生成解说文案,匹配视频片段,制作电影短视频。感觉写的不错的可以点击原文链接关注我,我会持续为你更新精彩内容。在后续内容中我们将继续详细地介绍我们的AI工具的实现过程(包含详细代码示例),效果展示,以及未来展望和改进方向。我们希望通过这种方法,能够为AI电影剪辑的发展,提供一种新的思路

哈喽大家好我是安琪,今天给大家带来Midjourney常用的指令指南,以及不同参数的对比,新手小白必看呦~ 话不多说让我们直接开始吧!如果想调整图像比例可以通过增加尾缀【–aspect16:9】【–16:9】来调整图片的宽长比。比较简单但是有几个需要注意的小点:(1)在英文和数字中间留空格(2)必须使用整数,而不能是–ar 1.5:2(3)长宽比会影响生成图像的形状和构图,从图可以看出同组词,长宽

AnimateDiff采用控制模块来影响StableDiffusion模型,通过大量短视频剪辑的训练,它能够调整图像生成过程,生成一系列与训练视频剪辑相似的图像。简言之,AnimateDiff通过训练大量短视频来优化图像之间的过渡,确保视频帧的流畅性。与传统的SD模型训练方式不同,AnimateDiff通过大量短视频的训练来提高图像之间的连续性,使得生成的每一张图像都能经过AnimateDiff微

感兴趣的小伙伴,赠送全套AIGC学习资料,包含AI绘画、AI人工智能等前沿科技教程和软件工具,具体看这里。AIGC技术的未来发展前景广阔,随着人工智能技术的不断发展,AIGC技术也将不断提高。未来,AIGC技术将在游戏和计算领域得到更广泛的应用,使游戏和计算系统具有更高效、更智能、更灵活的特性。同时,AIGC技术也将与人工智能技术紧密结合,在更多的领域得到广泛应用,对程序员来说影响至关重要。未来,

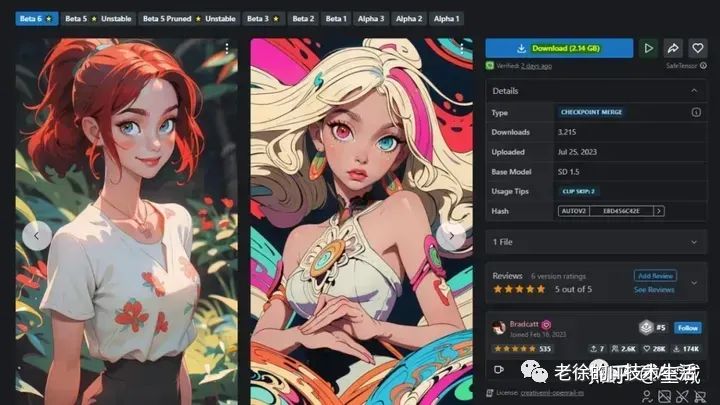

在使用 SD 文生图功能时,我们能选得大模型大致有两类,一类是普通模型,另一类是更加新的 SDXL 模型。普通模型就是 SD 的一些旧版模型,是将 SD 1.5 或 SD 2.0作为底模开发出来的模型。这类模型也是我们现阶段用得最多的模型。它的基础分辨率是512 x 512像素。如果我们需要将增加图片分辨率,直接修改文生图的width和height出来的效果并不会很好。有时候会还会出现多头的情况,

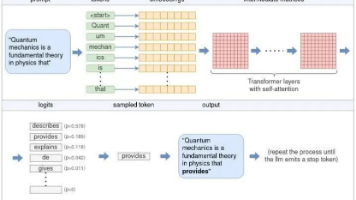

人们听说大模型已经有两年多了,不少人自己测试了对话。但舆论对于大模型还是有很多误解,应用时摸不清特性,一不小心就上当,更不知道大模型是怎么开发出来的。性能顶级的Deepseek火爆开源之后,意想不到的事发生了,人们居然很简单地就把大模型部署用上了!一个朋友,在3000多元的联想lecoo酷310 PC机上,就安装Deepseek R1成功了。机器配置不高,装的是7B(70亿)参数的版本,聊天能力明