简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

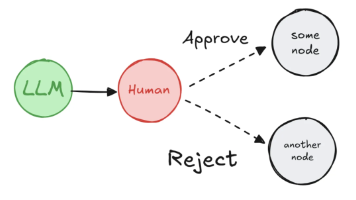

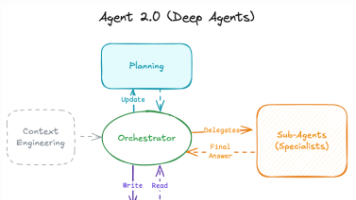

简单来说,Multi-Agent(多智能体)系统不是由一个“无所不知”的超级AI来解决所有问题,而是由多个具有特定角色和能力的、相对简单的自主智能体(Agent)协同工作,共同完成一个复杂任务的系统。这些智能体各自有自己的专长(通过不同的Prompt、工具和知识库来定义),它们之间可以沟通、协作、互相反馈、甚至辩论,最终合力交付一个高质量的成果。核心特征:● 分解 (Decomposition):

对于正在迷茫择业、想转行提升,或是刚入门的程序员、编程小白来说,有一个问题几乎人人都在问:未来10年,什么领域的职业发展潜力最大?答案只有一个:人工智能(尤其是大模型方向)当下,人工智能行业正处于爆发式增长期,其中大模型相关岗位更是供不应求,薪资待遇直接拉满——字节跳动作为AI领域的头部玩家,给硕士毕业的优质AI人才(含大模型相关方向)开出的月基础工资高达5万—6万元;即便是非“人才计划”的普通应

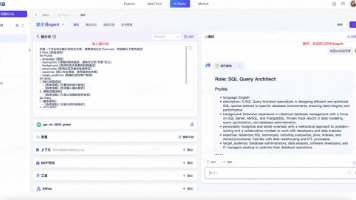

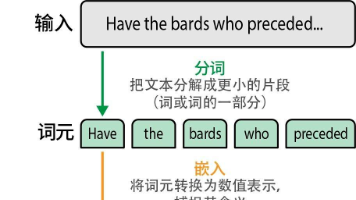

大语言模型(LLM)提示词(Prompt)工作流(Workflow)知识库(RAG)工具(Tools)LLM和工具调用已经形成了相对标准化的技术栈。LLM方面,无论选择云端大模型(如阿里百炼平台、IdeaLab)还是本地部署(如Ollama),都有成熟的解决方案;工具调用方面,MCP协议的普及让工具集成变成了配置问题而非开发问题。因此,业务开发的核心竞争力在于提示词 + 工作流 + 知识库上。

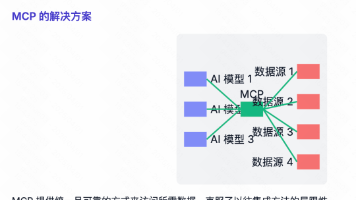

这里不过多解释,毕竟我们只是使用而不是实现。简单来说 LLM使用不同工具时,以前需要同时修改模型和工具,因为各工具的API数据格式不统一,导致适配成本高、功能添加慢。MCP协议统一了数据格式标准,规定了应用向LLM传输数据的方式。任何模型只要兼容MCP协议,就能与所有支持MCP的应用交互。这将适配工作从双向简化为单向(仅应用端),且对于已有API的应用,第三方开发者也可基于其API进行MCP封装适

对于正在迷茫择业、想转行提升,或是刚入门的程序员、编程小白来说,有一个问题几乎人人都在问:未来10年,什么领域的职业发展潜力最大?答案只有一个:人工智能(尤其是大模型方向)当下,人工智能行业正处于爆发式增长期,其中大模型相关岗位更是供不应求,薪资待遇直接拉满——字节跳动作为AI领域的头部玩家,给硕士毕业的优质AI人才(含大模型相关方向)开出的月基础工资高达5万—6万元;即便是非“人才计划”的普通应

如今,AI的发展速度越来越快,大模型已经从“前沿技术”,变成了小白学习、程序员工作的“必备工具”。前两天熊猫翻招聘软件时发现,很多公司(尤其是互联网、科技类公司),已经开始将“熟练使用大模型”作为招聘要求,不管是应届生还是职场人,掌握AI技能,都能提升自己的竞争力。最后想和大家说一句:技术的发展,从来不会取代人,但不会运用新技术的人,一定会被掌握新技术的人超越。2025年,AI大模型的普及速度会更

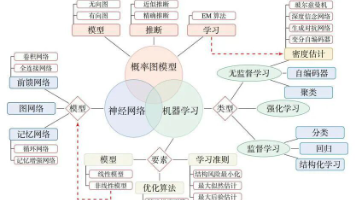

最初被预训练、后训练修正的原始“模型”是怎么来的,为什么给数据,经过不断训练就就能得到一个会说人话的“超大函数”出来呢?人是从受精卵开始不断发育,出生后拥有了一个符合人类大脑架构的“神经网络”,在日后成长过程中,大脑发育结构不断调整,不断根据获取的环境信息不断内化知识,逐渐成熟,通常在35岁后颅骨完全闭合,架构上再难发生大的变化,但依然可以通过不断学习、接受新信息,让大脑变得更聪明、更灵活。每过完

对于正在迷茫择业、想转行提升,或是刚入门的程序员、编程小白来说,有一个问题几乎人人都在问:未来10年,什么领域的职业发展潜力最大?答案只有一个:人工智能(尤其是大模型方向)当下,人工智能行业正处于爆发式增长期,其中大模型相关岗位更是供不应求,薪资待遇直接拉满——字节跳动作为AI领域的头部玩家,给硕士毕业的优质AI人才(含大模型相关方向)开出的月基础工资高达5万—6万元;即便是非“人才计划”的普通应

DeepAgents是一个基于LangChain和LangGraph构建的企业级高级智能体框架。它建立在LangGraph(底层运行时)和LangChain(工具/模型层)之上,是一个高阶的Agent Harness(智能体装备/套件)。它构建可以规划、使用子代理和利用文件系统执行复杂任务的代理。DeepAgents是一个独立库,用于构建能够处理复杂多步骤任务的代理。

对于正在迷茫择业、想转行提升,或是刚入门的程序员、编程小白来说,有一个问题几乎人人都在问:未来10年,什么领域的职业发展潜力最大?答案只有一个:人工智能(尤其是大模型方向)当下,人工智能行业正处于爆发式增长期,其中大模型相关岗位更是供不应求,薪资待遇直接拉满——字节跳动作为AI领域的头部玩家,给硕士毕业的优质AI人才(含大模型相关方向)开出的月基础工资高达5万—6万元;即便是非“人才计划”的普通应