简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

医疗AI行业呈现巨头布局入口、初创深耕垂类的分化格局。OpenAI推出ChatGPTHealth并收购数据公司,Anthropic主攻B端医疗流程,中国百川智能将医疗大模型幻觉率降至2.6%。央视春晚机器人表演引发外媒热议,彰显中国AI与制造业融合成果。国际方面,高通投资印度AI基金1.5亿美元,阿达尼集团计划千亿美元AI数据中心建设。美国财政部发布AI金融安全资源,Meta推出反AI勒索协议。行

医疗AI行业呈现巨头布局入口、初创深耕垂类的分化格局。OpenAI推出ChatGPTHealth并收购数据公司,Anthropic主攻B端医疗流程,中国百川智能将医疗大模型幻觉率降至2.6%。央视春晚机器人表演引发外媒热议,彰显中国AI与制造业融合成果。国际方面,高通投资印度AI基金1.5亿美元,阿达尼集团计划千亿美元AI数据中心建设。美国财政部发布AI金融安全资源,Meta推出反AI勒索协议。行

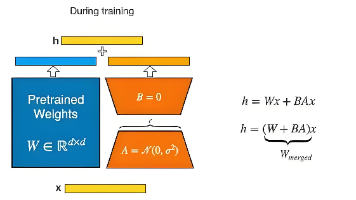

在当今的人工智能领域,大模型已成为推动众多应用发展的核心力量。然而,预训练的通用大模型往往无法直接完美适配各种特定的下游任务。为了让模型在特定任务中展现出卓越性能,微调技术应运而生。本文将深入探讨两种重要的微调方式:模型全量微调与 LoRA(Low-Rank Adaptation)高效微调,详细阐述它们的原理、优势以及在实际应用中的表现。

在人工智能技术飞速发展的当下,通用大模型无疑是最受关注的领域之一。它凭借强大的能力打破了传统 AI 模型的局限,为各行业的智能化升级提供了全新可能。本文将从通用大模型的定义出发,深入剖析其核心特点,并详细梳理常见的分类方式,带大家全面认识这一前沿技术。

多头潜在注意力(MLA)是DeepSeek团队提出的创新机制,通过低秩压缩键值缓存至潜在空间,显著降低内存占用(减少53%)和计算开销(延迟降低53%)。MLA采用解耦RoPE、矩阵吸收优化等技术,在保持模型性能的同时支持长文本处理(32K token)。相比传统注意力机制,MLA具有内存效率高(缓存仅为MHA的1/8)、计算速度快等优势,特别适合大规模模型部署和多模态融合应用。该技术为AI系统的

大模型的核心能力源于超大规模参数(百亿级以上)与自监督预训练(如掩码语言建模、自回归预测),结合万亿级多模态数据训练,实现通用语义理解。其独特涌现能力(如思维链推理)在参数突破阈值后显现。基于Transformer架构的注意力机制和残差连接支撑了模型的扩展性。行业现状呈现技术同质化(Transformer主导)与头部垄断(高算力/数据壁垒)。落地应用需结合场景特性,如文本生成(自回归预测)、智能客

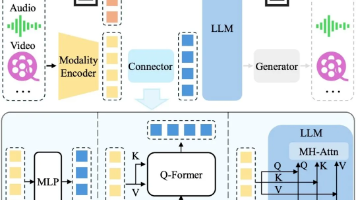

在人工智能领域,大模型多模态微调是让模型具备跨模态理解与生成能力的关键技术。它能使模型更好地适配特定场景,在视觉问答、医疗影像诊断等诸多领域发挥重要作用。下面将从多模态大模型结构、微调方法、数据准备、应用场景以及面临的挑战等方面展开详细解析。

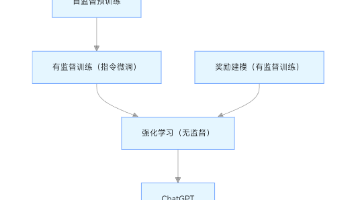

本文解析了ChatGPT四阶段构建流程:1)自监督预训练阶段通过海量文本学习语言规律;2)有监督微调阶段用标注指令数据训练模型理解人类需求;3)奖励建模阶段构建文本质量评估体系;4)强化学习阶段基于反馈优化模型输出。每个阶段在数据规模、算法类型和计算资源上都有特定要求,通过层层递进的训练最终实现模型的智能表现。该流程体现了从基础能力奠基到精细化优化的完整技术路径。

在大模型落地实践中,微调(Fine-tuning)是连接通用预训练能力与特定任务需求的关键环节。通过微调,我们能让在海量数据上预训练的模型 “适配” 具体业务场景,比如客服对话、代码生成、医学文献分析等。本文将系统梳理六种主流微调方式,从核心原理、参数调整逻辑到适用场景,帮你快速掌握不同方案的选型思路。

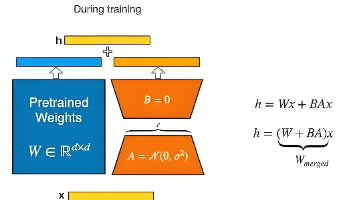

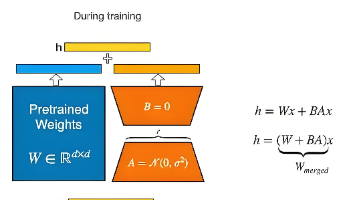

大型语言模型(LLM)参数规模极大,全参数微调存在诸多难题:- **成本高昂**:需存储和更新所有模型参数副本,训练开销大。- **部署困难**:每个任务都要存储完整模型副本,占用大量存储空间。- **资源需求高**:对计算资源和GPU内存要求严苛,普通设备难以支撑。