简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

过去几年间,以大型语言模型(LLM)和生成式 AI 为代表的新浪潮席卷全球,对算力基础设施提出了前所未有的严苛挑战。从 GPT-4 到 Llama 3.1,参数量级的飞跃不仅意味着计算复杂度的几何级数增长,更直接推动了对高性能 GPU 的需求井喷。然而,对于大多数创新型企业而言,自建集群面临的高昂成本与运维压力,使得像这类按需付费、灵活扩展的 GPU 云服务成为了解决算力瓶颈的关键。目前,Digi

事实上,AI Agent 的研究还处于早期阶段,该领域还没有明确的定义。但是 Astra 和 GPT-4o 已经可以成为一个很好的早期示例了。NVIDIA 高级研究员、AI Agent 项目负责人 Jim Fan表示我们距离出现一个有实体的 AI Agent 或者说以 ChatGPT 作为内核的机器人,还有大约 3 年的时间。如果用他话来解释什么是 AI Agent,简单来说,AI Agent 就

2025 年,DigitalOcean 云平台上线了 Serverless Inference。DigitalOcean Serverless Inference 是一种托管式的大模型推理服务。你不需要创建 GPU 实例、不用部署模型、不用关心扩缩容,只要通过 API 调用模型,DigitalOcean 就会在后台自动完成推理资源的调度与运行。

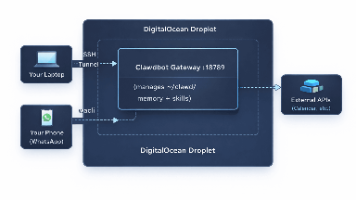

这是一篇在云服务器上部署和配置AI助手Moltbot/Clawdbot的详细教程。

前不久,在 AGI‑Next 峰会上,一场持续三个半小时、围绕技术路径与产业走向的高密度讨论,被业内称为“中国 AI 半壁江山聚首”的会议。91 岁的张钹院士、加拿大皇家学院院士杨强坐镇现场,智谱 AI 唐杰、月之暗面杨植麟、阿里通义千问林俊旸、腾讯姚顺雨四位头部 AI 企业的核心技术负责人罕见同台。讨论的核心并不在于“谁的模型参数更大”,而是集中在三个问题上:中美 AI 技术竞争将如何演化?下一

:需要高带宽(H100/A100)。。

MCP 是 Model Context Protocol(模型上下文协议)的缩写。它是一种让基于大语言模型(LLM)的工具(如 Claude 或 Cursor)能够安全地与外部服务通信并执行实际操作的方法。LLM 擅长处理“文字”——它可以总结、解释、改写文本。但如果没有帮助,它自己是无法“做事”的。比如它不能自动帮你部署应用、查询数据库,或者回滚失败的版本。而 MCP 就是这个“帮助”。它是一个

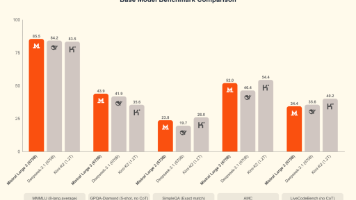

本文系统介绍 Mistral 3 开源模型家族,解析 Large 3 与 Mini-stral 的能力差异、硬件需求与适用场景,并演示在 DigitalOcean GPU 上的实际部署流程,帮助开发者低成本落地大模型应用。

Ollama 提供了一种方式,可以从其庞大的语言模型库中下载大型语言模型,该库包括 Llama3.1、Mistral、Code Llama、Gemma 等。Ollama 将模型权重、配置和数据整合到一个由 Modelfile 指定的包中。Ollama 提供了一个灵活的平台,用于创建、导入和使用自定义或现有语言模型,非常适合创建聊天机器人、文本摘要等应用。它强调隐私,可与 Windows、macOS

另外,还需要注意的是,目前高端的 NVIDIA 显卡在国内都是很难买到的,多数企业会通过香港公司或新加坡公司在海外购置,所以显卡的价格浮动很大。而且自建集群还需要考虑后续的维护成本与人力成本,这些都是隐藏在背后的“成本巨坑”,自建集群的企业要留有充足的资金来应对。从2024年的V2到2025年的R1,模型参数从670亿跃升至6710亿,但通过混合专家架构(MoE)与算法优化,训练成本反而降至同类模