简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

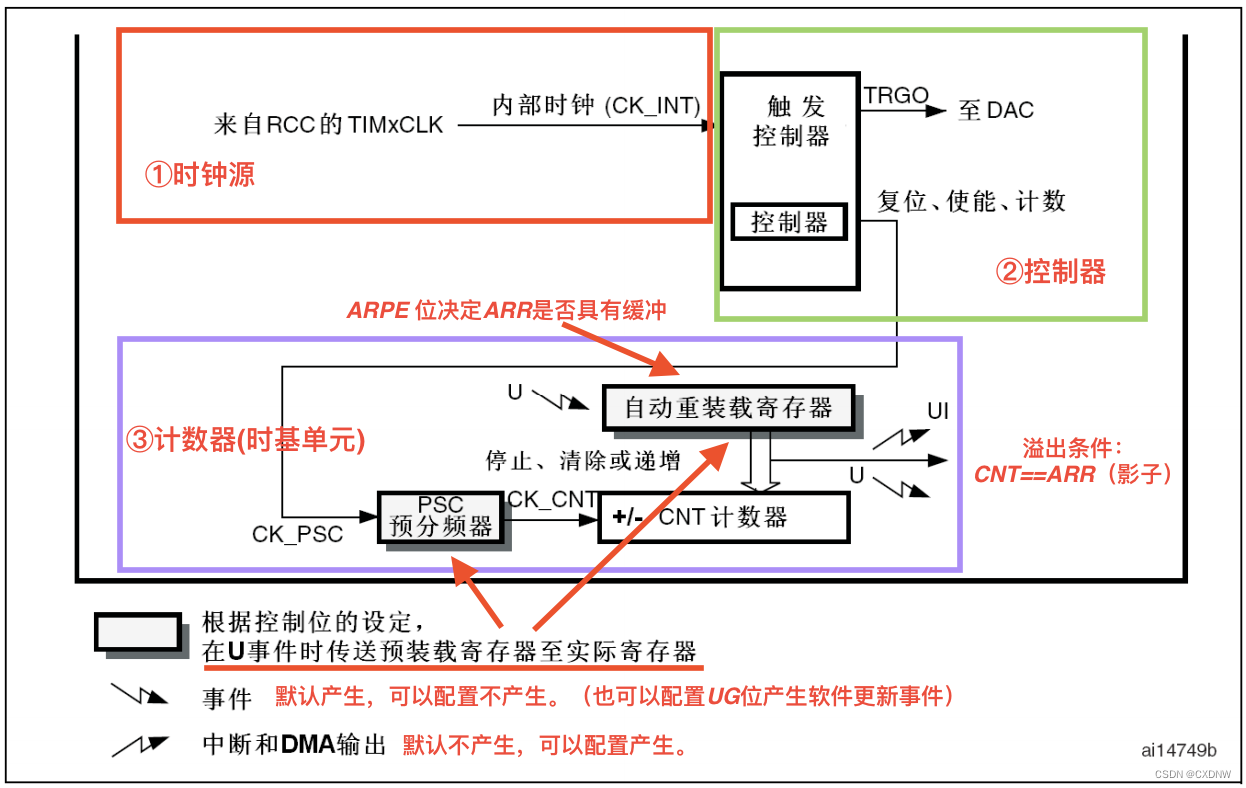

基本定时器。

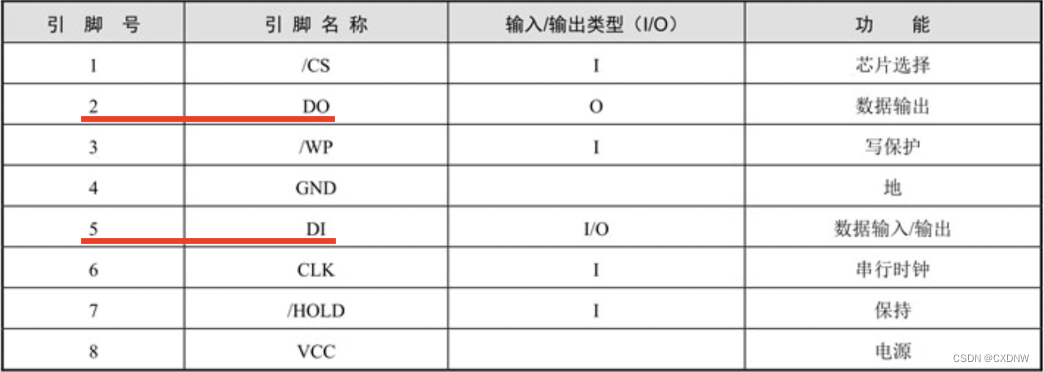

W25Q16、 W25Q32 和 W25Q64 支持标准的 SPl接口,传输速率最大 75 MHz,采用四线制,即4个引脚。① 串行 时钟引脚 (CLK)② 芯片 选择引脚 (CS)③ 串行数据 输出引脚(DO)④ 串行数据 输入 / 输出引脚(DIO):在普通情况下,该引脚是串行输入引脚(DI),当使用快读双输出指令时,该 引脚就变成了 输出引脚,在 这种情况下,芯片就有2个 DO引脚,所以称为

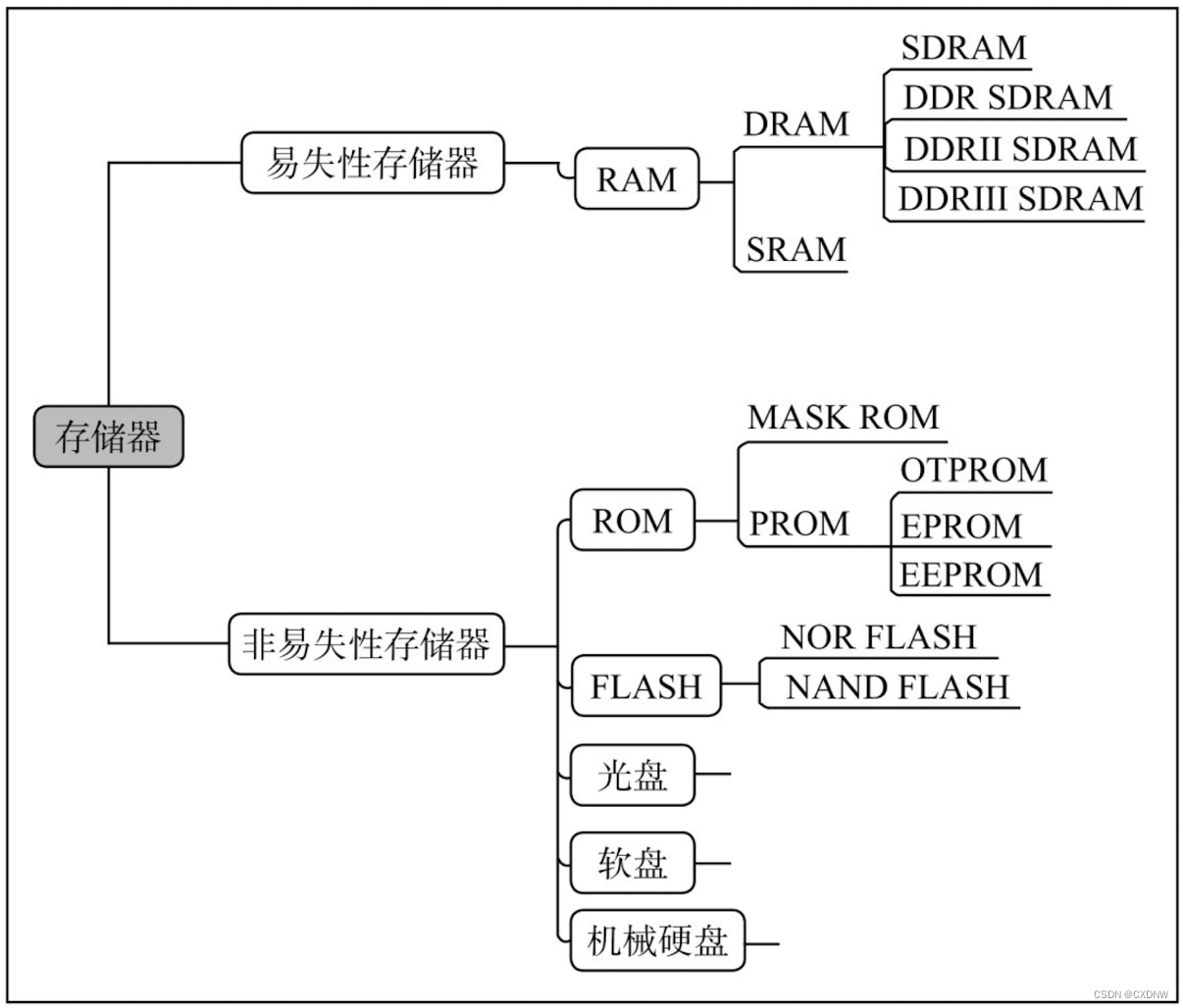

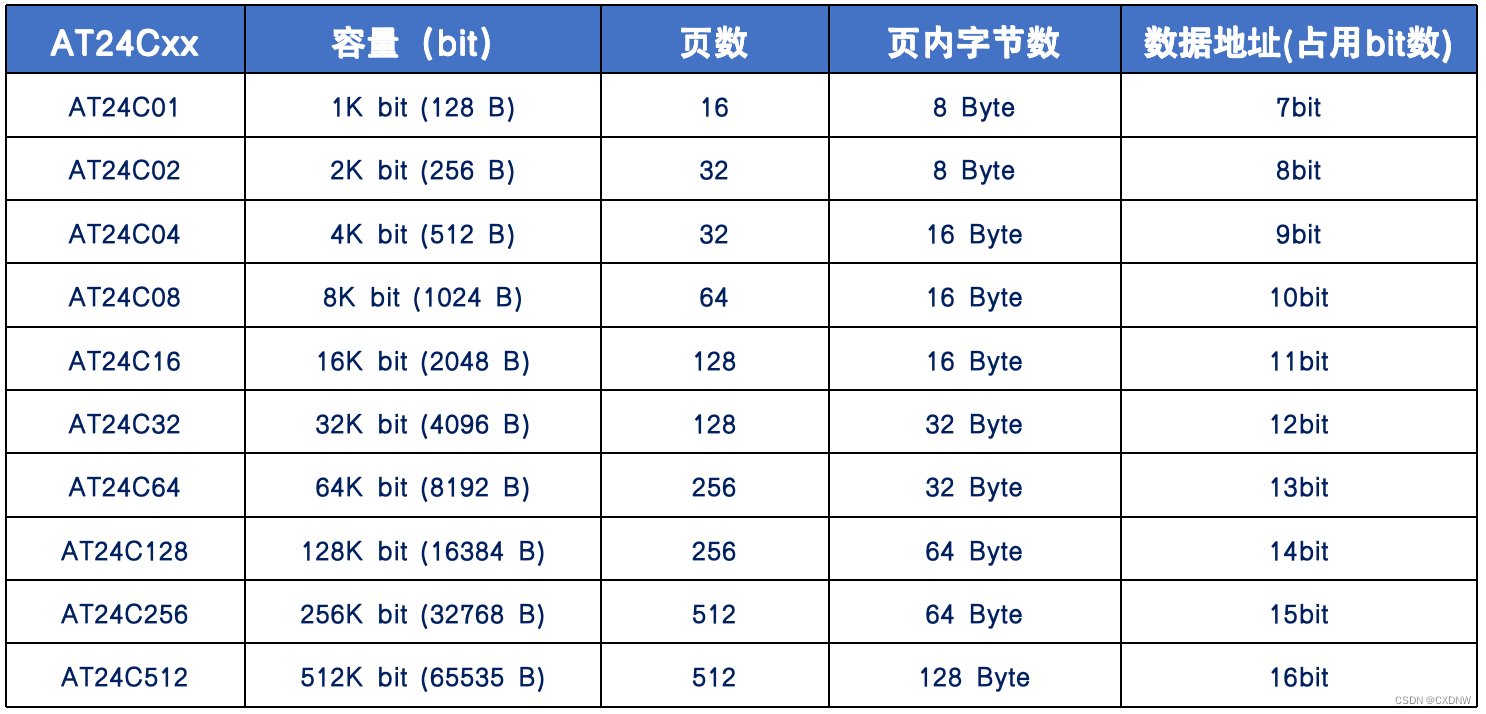

AT24C02是 低工作电压的 2Kb 串行电可擦除只读存储器,可存储256个字节数据,内部有一个16字节页写缓冲器。AT24C02工作电压 1.8~5.5V,采用二线制IIC数据传输协议,支持硬件写保护,能擦写 100万次,数据可保存 100年。通过器件地址输入端A0、A1和 A2可以实现将最多 8个 AT24C02器件 连接到 IIC总线上。补:EEPROM 是一种掉电后数据不丢失的储存器,常

决策树(Decision Tree)是一种非参数的有监督学习方法,它能够从一系列有特征和标签的数据中总结出决策规则,并用树状图的结构来呈现这些规则,以解决分类和回归问题。决策树算法容易理解,适用各种数据,在解决各种问题时都有良好表现,尤其是以树模型为核心的各种集成算法,在各个行业和领域都有广泛的应用。

XGBoost 全称 是 eXtreme Gradient Boosting,可译为 极限梯度提升算法。它由 陈天奇所设计,致力于 让提升树突破自身的 计算极限,以实现 运算快速,性能优秀的 工程目标。与决策树、SVM 等不同,它是一个集大成的机器学习算法。

XGBoost 全称 是 eXtreme Gradient Boosting,可译为 极限梯度提升算法。它由 陈天奇所设计,致力于 让提升树突破自身的 计算极限,以实现 运算快速,性能优秀的 工程目标。与决策树、SVM 等不同,它是一个集大成的机器学习算法。

中间的 虚线代表着,当 recall 增加 1%,我们的 FPR 也增加 1%,也就是说,每 捕捉出 一个少数 类,就会 有一个 多数类 被判错,这种情况下,模型的效果就不好,这种 模型捕获 少数类的结果,会让许多多数类 被误伤,从而增加成本。横坐标是 FPR,代表着 模型将多数类判断错误的 能力,纵坐标 Recall,代表着模型捕捉少数类的 能力,所以 ROC 曲线 代表着,随着Recall 的

① 大多数机器学习算法中,会选择 StandardScaler 来进行 特征缩放,因为 MinMaxScaler 对异常值 非常敏感。MinMaxScaler 在不涉及距离 度量、梯度、协方差计算以及数据 需要被时使用广泛。② 在嵌入法下,我们 很容易就能够实现 特征选择的目标:减少计算量,提升模型表现。因此,比起要思考 很多统计量的 过滤法来说,嵌入法 可能是更有效的一种方法。然而,在 算法本身

设置 betas=(opt.b1, opt.b2) 有什么 实际的作用?通俗易懂的讲一下betas=(opt.b1, opt.b2) 是怎样 更新学习率的?