简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

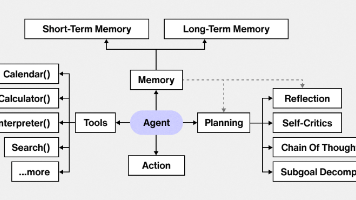

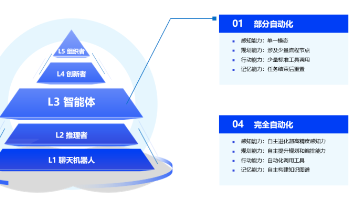

Google DeepResearch关于AI Agent的全面研究报告,详细分析了其基本概念、核心组件、运作机制及与大模型的协同关系。文章探讨了AI Agent的关键能力、实现技术、开发框架及开发生命周期,并展望了其发展趋势,包括与LLM的共生演化、MCP的作用、通用智能体的发展及Agent间协同(A2A协议)等方向。同时介绍了应用案例及当前挑战,为开发者提供从理论到实践的全面指导。

前言本文罗列了了python零基础入门到精通的详细教程,内容均以知识目录的形式展开。01.python由来与发展介绍02.项目开发流程第一章 markdown编辑器01.markdown基本语法02.Typora简介与安装03.Windows上gitee+Typora设置图床04.macOS上gitee+Typora设置图床第二章 计算机核心基础01.计算机组成原理第三章 编程语言01.编程语言介

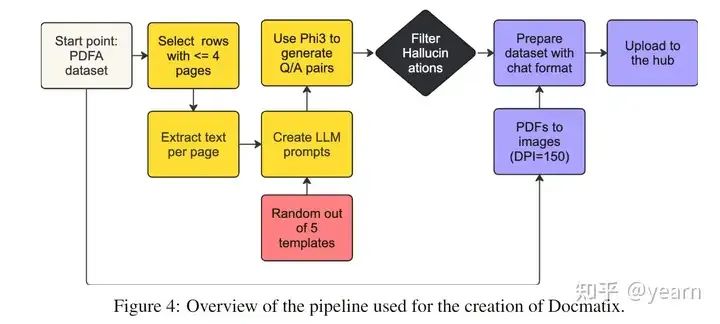

在本文中,详细介绍了构建视觉语言模型(VLMs)的完整教程,强调了架构、数据和训练方法在开发流程中的重要性。通过对当前最先进方法的深入分析,突出了各种设计选择的优缺点,并提出了改进模型的潜在研究方向。接着,本文详细阐述了构建Idefics3-8B的实际步骤,这是一种在文档理解任务中表现显著提升的VLM,特别是通过引入Docmatix数据集实现了这一进步。通过公开发布模型和数据集,作者希望为下一代负

本文揭示了一个被学术界忽视的LoRA微调关键优化点:针对同一任务中不同类型的训练样本,应采用非对称的思维链格式(如边界场景用逐项排除)。实验表明,这种样本级格式分化策略的效果远超单纯增大模型规模。文章系统梳理了学术界在LoRA模型结构和数据侧的优化技巧,指出当前研究多集中于任务级别,而样本级格式差异问题仍是一片空白。作者发现这一优化在小模型和特定领域任务中尤为显著,建议LoRA微调应优先关注数据质

RAG 2.0:AI助手从被动检索到主动推理的进化之路 本文系统阐述了RAG 2.0如何通过引入自主AI Agent实现从传统检索到智能推理的跃迁。文章首先分析了传统RAG存在的盲目检索、缺乏评估机制和单一知识源三大瓶颈,进而提出Agentic RAG的三大设计原则:需求驱动的动态检索、多维度的自我评估和多源协同的知识整合。在技术实现层面,详细介绍了Router Agent、多Agent协作架构等

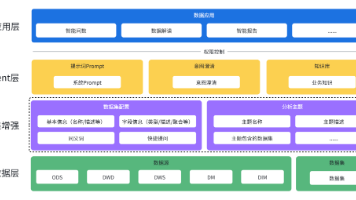

文章对比分析了智能问数Agent的两种设计路线:基于数据集(Dataset)和基于语义层(Semantic Layer)。前者通过增强数据集配置和分析主题实现快速落地,适合数据建设初期的企业;后者依托指标中心、维度实体和业务规则等语义资产,提供统一业务理解,适合治理成熟的企业。文章建议企业采取渐进式演进策略,从数据集增强起步,逐步沉淀语义资产,最终向语义层架构过渡。两种方案各具优势,企业可根据数据

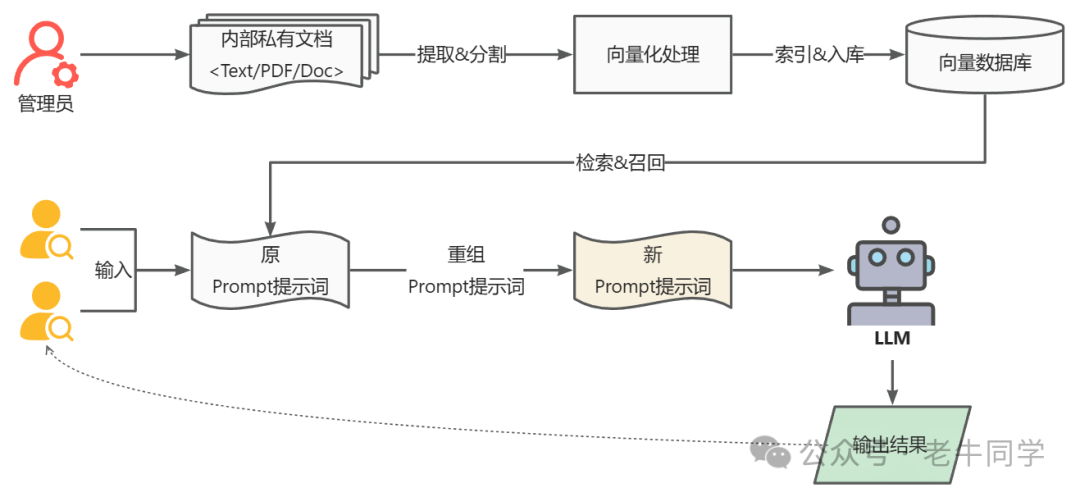

和我们之前的大模型部署和应用过程相比,基于 AnythingLLM 的 RAG 实现整个部署过程比较繁琐,包括环境准备、Docker 安装和配置、AnythingLLM 配置等。然而,AnythingLLM 的使用过程却相对比较简单,我们只需要上传我们内部数据文件,AnythingLLM 框架屏蔽了中间的数据提取分割、向量化处理、向量索引和入库、检索召回和重组 Prompt 提示词等过程。

AI大模型(Large AI Models / Large-scale AI Models) 是指拥有亿级以上参数的深度学习模型。AI大模型利用深度学习算法和人工神经网络技术等AI技术,通过学习大量的数据提升预测能力,其性能与模型的参数规模、数据集大小和训练用的计算量之间存在幂律关系。从应用领域角度分类,AI大模型分为通用大模型、垂直大模型;按输入数据类型,AI大模型分为单模态大模型、多模态大模型

随着网络的普及和信息爆炸式增长,我们可以通过网络来获取各种各样的数据。而Python作为一门强大而灵活的编程语言,可以帮助我们快速地从HTML网页中提取数据。本文将介绍Python爬虫的入门知识,并详细讲解如何使用Python爬虫来爬取HTML网页上的数据。1.了解HTML和网页结构2.安装和导入相关依赖库3.发送http请求获取网页内容4.解析HTML网页内容5.定位内容和提取数据6.保存抓取的

程序员客栈中国非常领先的自由工作平台,为中高端程序员、产品经理和设计师等等互联网相关人员提供稳定的线上工作机会,包括自由工作、远程工作和兼职工作,还支持按需雇佣,工作模式非常多,感兴趣的推荐大家尝试一下。AngelList 主要是服务于初创公司和天使投资人的平台,这里还有初创公司提供的远程工作的机会,如果对远程加入初创公司感兴趣的,可以尝试一下。Python所有方向的技术点做的整理,形成各个领域的