简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

Jason Wei 曾任职于 Google Brain(2020–2023),其间主导或参与了多项影响深远的研究工作,包括:Chain‑of‑Thought(思维链)Prompting:提出通过在提示中加入“chain-of-thought”示例,使大模型展现分步推理能力,从而在算术、常识推理和符号操作等任务上达到更高表现 (arXiv同时,Jason Wei 对 self-consistency

2025年Google DeepMind与OpenAI先后宣布其AI系统在IMO测试中达到了“金牌”级别的表现。DeepMind的Gemini Deep Think模型通过与IMO官方合作,正式获得金牌认证,而OpenAI则基于内部评估和独立数学专家的判定宣称其实验性推理模型也达到了金牌水平。这两起事件标志着AI在高难度数学推理领域的显著突破,预示着AI与人类数学家在未来有望展开更深层次的合作与竞

每部分都配一句 insight,一个信息流示意图(便于理解),并且按。

1995 年,Stephen Thaler 展示了人工神经网络在连接权重随机扰动下如何产生幻觉和幻影体验Edu。作者构建了一个简单的 3–5–9 前馈模式联想器: 输入层:3 个节点(可表示 8 种三位二进制模式);隐藏层:5 个节点;输出层:9 个节点,对应 3×3 的像素图案。训练任务是: 每个三位输入模式 → 一个对称的 3×3 输出像素图案(如下所示):实验的关键步骤是随机剪枝连接权重,也

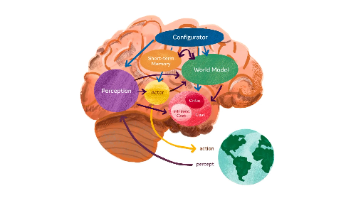

过去两年,视频生成模型从「好看」逐步走向「可用」。Genie 3 把这一趋势推到台前:它能把文本或图像提示转成可实时交互的 3D 世界,以 720p/24 fps 持续运行数分钟,并支持“可提示的世界事件”(如改变天气、加入角色),同时维持较强的对象与场景记忆一致性,虽仍处于限量研究预览阶段,但已明确展示了从被动视频到可控世界模拟器(即世界模型,World Model)的跃迁。Genie 3。

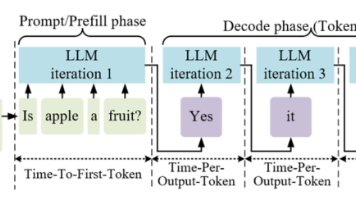

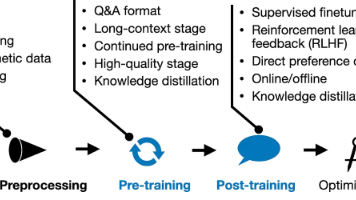

综上,2024 年以来 LLM 后训练技术在对齐和优化上取得了长足进展。一方面,新型强化学习范式(如 RLSF、AfD、迭代 DPO)摆脱了对人工偏好的完全依赖,探索了模型自我反馈和高效偏好优化的途径,为提升模型对齐性提供了更经济可扩展的方案。另一方面,围绕推理能力的专门训练使模型在复杂推理和多轮对话中表现出更强的一致性和准确性(通过显式或隐式的链式思维训练,以及引入逆向推理、注意力奖励等创新技术

尽管有Coltraro等人的研究评估并改进了模拟器逼真度。

在机器人学里,IROS(IEEE/RSJ International Conference on Intelligent Robots and Systems)与 ICRA并列为全球影响力最大的两大顶级学术会议:自 1988 年创办起,IROS 由 IEEE RAS 与日本机器人学会 RSJ 共同主办,覆盖从感知、控制、学习到系统落地的全栈研究,被官方称为“全球最大、最具影响力的机器人研究会议之一

灵巧手”(dexterous hand)通常指具有类人手结构、多自由度的末端执行器,能够进行精细的抓取与操作,而不仅仅局限于平行夹紧(如下图它们模仿人类手指关节和肌腱驱动,使机器人能够执行转动、重定位、穿插等复杂操作。刚性型采用金属或坚硬塑料结构,关节通过电机或舵机驱动,优点是定位精度高、力矩大;柔性型主要用硅胶、橡胶等软材料,可通过气动驱动或形变实现自适应抓取,天生适合对柔软或不规则物体的抓取;

尽管有Coltraro等人的研究评估并改进了模拟器逼真度。