简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

《提示词工程手册》摘要:提示词工程是通过结构化设计提示词(Prompt)来优化大模型输出的方法论,涵盖指令、上下文、示例和输出约束等要素。它连接人类需求与大模型能力,适用于自然语言处理、代码开发、数据分析等多场景。手册系统讲解从基础到高阶的提示词设计技巧,包括核心原则(清晰具体、角色设定、逻辑分层等)、进阶方法(Few-shot、CoT、ToT等)及分场景实践(代码开发、SQL生成等)。同时提供模

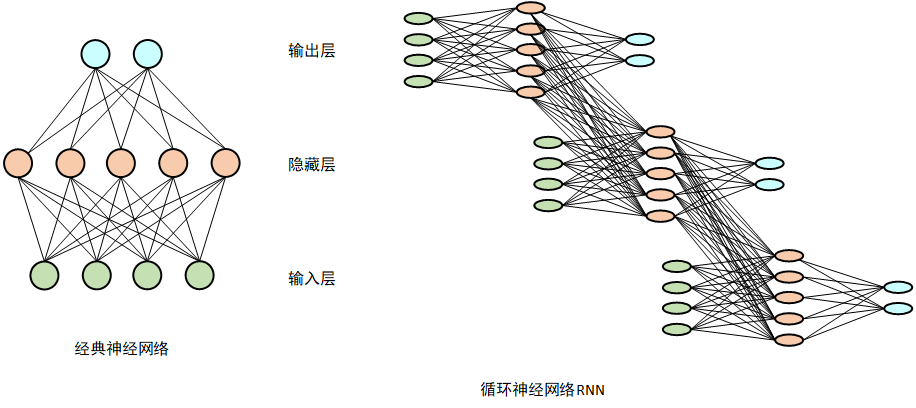

摘要:Transformer架构是当前大语言模型(LLM)的核心基础,由Google团队在2017年提出,取代了传统的循环神经网络(RNN)。其核心创新在于:1)完全基于注意力机制,实现全局依赖捕捉;2)支持全并行计算,大幅提升训练效率;3)采用多头注意力设计,可同时建模不同维度的语义关联。原始Transformer采用编码器-解码器双塔结构,通过自注意力、前馈网络等模块堆叠实现序列建模。现代大模

客户对大模型参数的核心要求与详细解释

计算机专业学生掌握AI模型数学公式的关键在于"应用导向"学习,重点理解公式含义、作用及代码实现。基础必备三门数学课:1)线性代数(矩阵乘法、维度匹配);2)微积分(导数、梯度下降);3)概率统计(选学)。进阶阶段通过《机器学习数学基础》课程衔接数学与AI模型,最后结合PyTorch/TensorFlow实战课程将数学公式转化为代码实现。学习路线建议:先线性代数(2-3周)→微积

摘要:本文详细介绍了两种Git分支协作流程:1)本地新建仓库推送到远程,适用于先本地开发后关联远程的场景;2)克隆远程仓库开发分支,适合团队协作的主流方式。两种流程均遵循main-dev-feature/*的分支规范,包含分支创建、开发、推送、合并到清理的全过程,每个步骤提供可执行命令和场景说明。重点强调了分支隔离、合并规范、推送前拉取和及时清理等核心原则,并提供了分支操作速查表。流程覆盖从功能开

简单来说,大模型是一个通过海量数据训练获得的、极其强大的概率预测系统。它的“智能”来源于数据中的统计规律。希望这个从内到外的解释,能帮助你更清晰地理解大模型的工作原理。如果你对某个具体的技术细节(比如Transformer架构如何实现并行计算)或应用场景特别感兴趣,我们可以继续深入探讨。