简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

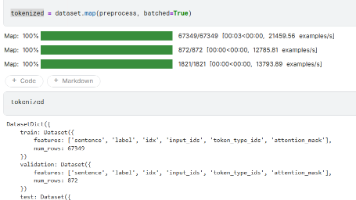

实验任务 微调 Bert 基础模型让其实现情感二分类,使用的数据集为 sst-2,其数据结构如下所示。训练数据 67349 条,验证数据 872 条,测试数据 1821 条。SST-2 是自然语言处理(NLP)领域最经典的情感分类数据集之一,每个样本是单个句子(而非完整段落),标签为 0(负面)/1(正面),该数据集用于评估模型的句子级情感分类能力,是 NLP 领域的 “基准数据集” 之一 ——

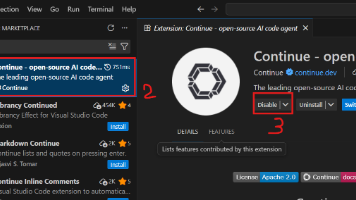

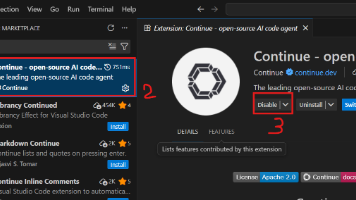

本文介绍了如何本地部署AI代码助手作为Cursor/GitHub Copilot的替代方案。主要内容包括:1)分析本地部署在数据隐私和定制化方面的优势;2)选择Qwen2.5-14B-Instruct模型并完成部署;3)通过VSCode的Continue插件连接本地模型,详细说明了配置过程;4)测试验证功能实现。该方案特别适合企业内网开发等需要数据安全的场景,提供代码补全、对话交互等功能,同时保障

本文介绍了如何本地部署AI代码助手作为Cursor/GitHub Copilot的替代方案。主要内容包括:1)分析本地部署在数据隐私和定制化方面的优势;2)选择Qwen2.5-14B-Instruct模型并完成部署;3)通过VSCode的Continue插件连接本地模型,详细说明了配置过程;4)测试验证功能实现。该方案特别适合企业内网开发等需要数据安全的场景,提供代码补全、对话交互等功能,同时保障

无反馈,不学习蒸馏技术:通过教会特定任务。这样说可能比较抽像,具体一点来说就是,现如今的大模型参数都达到了百万亿级,甚至千万亿级,对于一些公司实际使用这样的大模型需要大量昂贵的硬件资源,同时在一些硬件资源受限的终端设备中无法运行;为了让大模型减小运行时所需要的硬件资源就提出了蒸馏技术。

OpenAI 的 Prompt 工程是指通过设计和构建与大语言模型进行交互的输入方式,以引导模型生成期望输出的过程。任务:本文将以引导AI根据用户指令输出符合用户要求的json格式数据。测试可以正常通信后,就可以开始构建OpenAI的Prompt工程了。

Part one进入 ollama的官网下载ollama默认安装在 C 盘,直接点击 install 即可。

《神经概率语言模型》是Bengio等人在2003年提出的开创性工作,首次将神经网络应用于语言建模。该研究通过分布式词表示和神经网络联合建模,解决了传统n-gram模型的数据稀疏问题。论文提出用低维稠密向量表示词语,使模型能捕捉词间相似性,显著提升了长上下文建模能力。实验表明,神经网络模型在困惑度指标上优于传统n-gram方法,尤其在处理未见词序列时展现出更强的泛化能力。这项工作为后续词嵌入技术和深

Pytorch 是基于Numpy的科学计算包,给用户提供了使用GPU的强大能力,是一个深度学习平台,其基本类型是,tensors张量可以利用GPU进行加速运算。

写在开头大四期间,选修了一门智慧医疗的课程,期末考核为25分钟有关智慧医疗方面的汇报。一次偶然的课程汇报让我接触到了生物信息,也产生了浓厚的兴趣,同时加入了老师的研究生小组,开启了这段生物信息学习的旅途。至此开始学习并记录有关生物信息的基础知识。

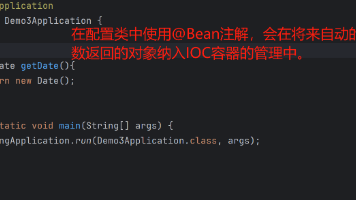

SpringBoot 主入口类如下所示,这个类的main方法就是整个springboot项目的入口。