简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

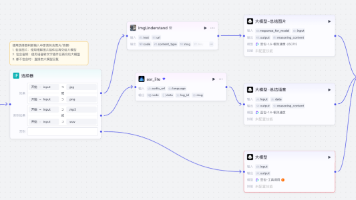

文章介绍了长周期Agent开发的三大核心解决方案:1)采用双Agent架构(Initializer+Coding)解决任务切分和上下文传递问题;2)使用向量数据库实现语义检索,解决跨会话状态恢复与经验复用;3)通过浏览器自动化测试实现功能验证闭环。这些方法配合LangGraph状态管理和Milvus记忆系统,形成"短期记忆+长期记忆"协同机制,有效解决了Agent在长周期开发中的落地难题。

Google Antigrgravity支持Agent Skills功能,通过简单的SKILL.md文件指导AI完成任务。测试显示,Claude Code、Codex和Antigravity等平台在基础功能上表现一致。Skills具有三大价值:一次编写全平台通用、降低创作门槛、启动生态效应。随着模型能力增强和协议对齐,Skills可能开启大模型应用开发的新时代,就像早期App Store一样。

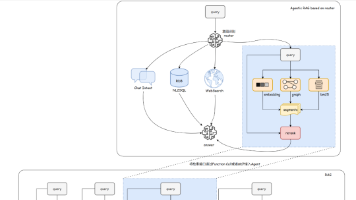

智能体路由是多智能体系统的核心动态决策机制,根据用户输入选择最适合的处理路径,实现灵活响应。常见实现方式有四种:基于规则的路由(预定义规则)、基于LLM的路由(使用大模型分析)、基于嵌入的路由(语义相似度比较)和基于机器学习模型的路由(使用分类器)。不同方法各有优劣,未来更精准、低成本、可解释的路由策略将成为企业级智能体平台的核心竞争力。

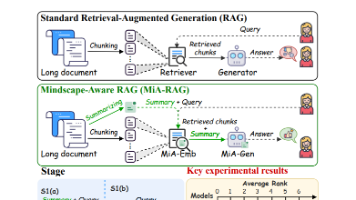

RAG(检索增强生成)是结合检索与生成的重要技术,适用于时效性强、算力有限的场景。文章详细介绍了其架构演进从简单RAG到Agentic RAG,涵盖索引构建、多路召回策略、Rerank模型和Embedding训练等技术。针对不同数据模态(语音、文本、图片)提出了处理方案,并讨论了效果评估方法和未来优化方向。RAG已成为连接LLM与知识库的基础设施,在Agent框架中发挥重要作用。

本文详细介绍了RAG评估体系的构建方法,从4大维度(检索层、生成层、端到端、业务层)12个核心指标出发,结合实战经验提供了工具选型建议和落地流程。文章强调RAG评估需数据驱动而非主观判断,通过"评估→优化→再评估"的闭环持续提升系统性能,解决"答非所问"等常见问题,让RAG系统从"能用"变为"好用",真正为业务创造价值。

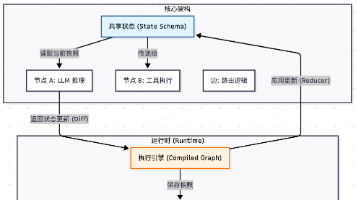

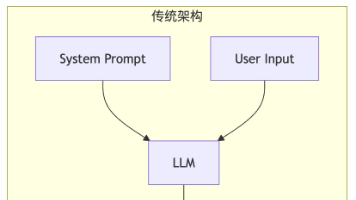

LangGraph是构建生产级Agent的底层操作系统,提供五大能力:持久化执行、人机协同、全方位记忆、调试支持和生产级部署。其架构基于状态在节点间的流转与演化,支持传统DAG不具备的循环功能,实现Agent的"思考-行动-观察"循环。LangGraph提供Graph API和Functional API两种开发模式,通过StateGraph、Nodes和Edges构建最小可用图,标志着LLM应用

Claude的Skills机制是一种按需加载的专业知识模块,具有"用完即回收"特点,与传统工具调用和Multi-Agent架构有本质区别。Skills通过临时增强System Prompt实现Token效率的量级提升,同时保持单体架构的简单性。文章探讨了Skills与Sub-Agent的区别,提出了根据任务复杂度选择架构的原则,强调模块化是应对复杂性的根本策略,建议从简单开始渐进演进。

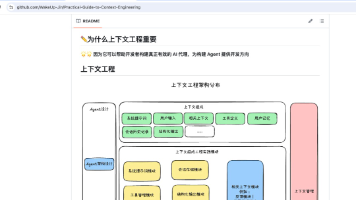

文章介绍了一个基于上下文工程的Agent后端架构设计,围绕四大核心模块:工具模块和管理、上下文管理、LLM模块和Agent执行器。该架构将上下文管理作为核心,统一管理各类上下文,通过LLM模块处理用户请求,并结合工具模块扩展能力。作者提供了CLI脚手架工具,帮助开发者快速实践这一架构,使开发重心集中在上下文获取与整理上,同时保持LLM作为核心,便于后续升级。

文章介绍了一个基于上下文工程的Agent后端架构设计,围绕四大核心模块:工具模块和管理、上下文管理、LLM模块和Agent执行器。该架构将上下文管理作为核心,统一管理各类上下文,通过LLM模块处理用户请求,并结合工具模块扩展能力。作者提供了CLI脚手架工具,帮助开发者快速实践这一架构,使开发重心集中在上下文获取与整理上,同时保持LLM作为核心,便于后续升级。

还记得2022年11月30日Chat-GPT3.5发布吗?短短5天的时间,其用户量就飞速突破了100万。时至今日,从第三方数据显示,2025年12月统计的月活跃人数达到了惊人的9.1亿。从Chat-GPT刚开始的爆发式传递增长,也顺带燃起了全世界人们对AI追求的热情,更加速了国产AI大模型的飞速发展!