简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

,特指部分参数的微调方法,这种方法算力功耗比更高,也是目前最为常见的微调方法;除此之外,Fine-Tuning也可以代指全部微调方法,同时OpenAI中模型微调API的名称也是需要注意的是,OpenAI提供的在线微调方法也是一种高效微调方法,并不Fine-Tuning,是全量微调;微调, Fine-Tuning,一般指全参数的微调 (全量微调) ,指是一类较早诞生的微调方法,全参数微调需要消耗大量

在人工智能领域,特别是模型训练和推理阶段,显卡性能极为关键。随着模型规模的增加,对算力的需求也在不断上升。因此,挑选合适的显卡,实现高性能与性价比的平衡,成为众多开发者关注的焦点。市面上的加速卡种类繁多,但谈到适合大模型推理的显卡,4090无疑是当前的佼佼者。尽管在性能上不及H100,在价格上不如3090,但4090凭借其出色的性价比和性能,成为大模型推理的首选。4090显卡基于Ada Lovel

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模

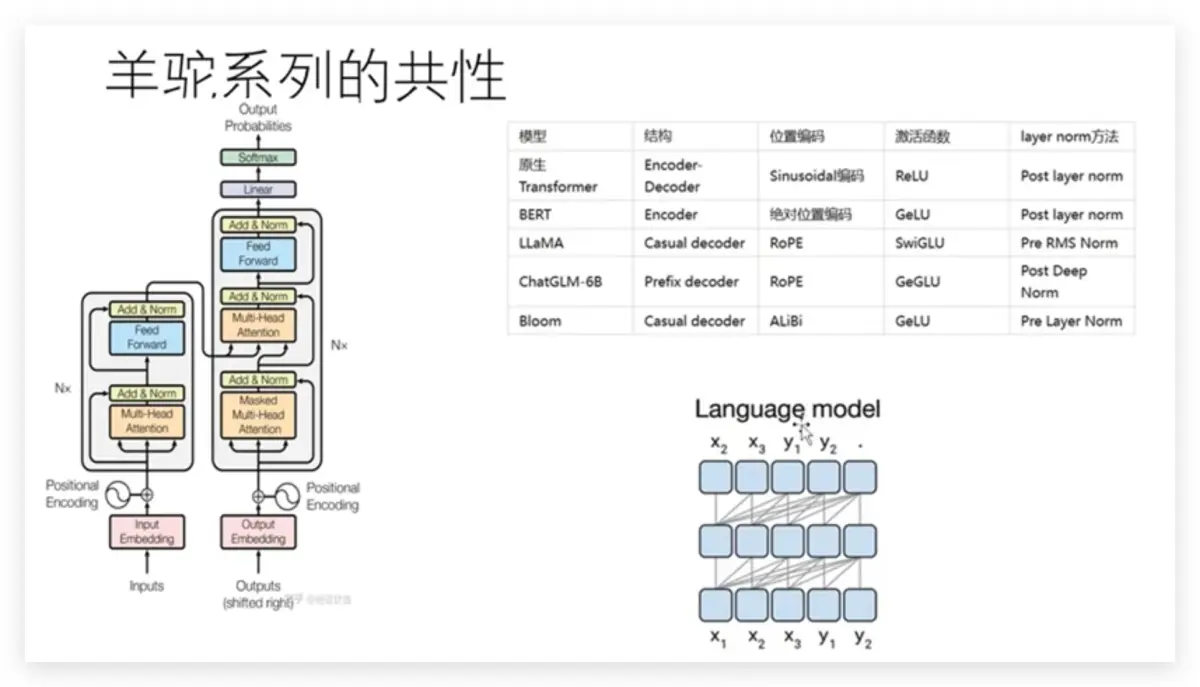

通俗来说,人工智能就是让计算机像人类一样思考、学习和做出决策。通过利用各种技术(如机器学习、深度学习、专家系统等),人工智能系统可以处理和分析大量数据,自主地学习和优化算法,从而完成各种复杂的任务。人工智能的应用非常广泛,包括但不限于语音识别、图像识别、自然语言处理、智能推荐、智能客服等。具体的,从技术层面来看(如下图),现在所说的人工智能技术基本上就是机器学习(含深度学习)方面的技术。机器学习、

本篇文章深入分析了大型模型微调的基本理念和多样化技术,细致介绍了LoRA、适配器调整(Adapter Tuning)、前缀调整(Prefix Tuning)等多个微调方法。详细讨论了每一种策略的基本原则、主要优点以及适宜应用场景,使得读者可以依据特定的应用要求和计算资源限制,挑选最适合的微调方案。大型语言模型(LLM)的训练过程通常分为两大阶段:阶段一:预训练阶段在这个阶段,大型模型会在大规模的无

通俗来说,人工智能就是让计算机像人类一样思考、学习和做出决策。通过利用各种技术(如机器学习、深度学习、专家系统等),人工智能系统可以处理和分析大量数据,自主地学习和优化算法,从而完成各种复杂的任务。人工智能的应用非常广泛,包括但不限于语音识别、图像识别、自然语言处理、智能推荐、智能客服等。具体的,从技术层面来看(如下图),现在所说的人工智能技术基本上就是机器学习(含深度学习)方面的技术。机器学习、

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模

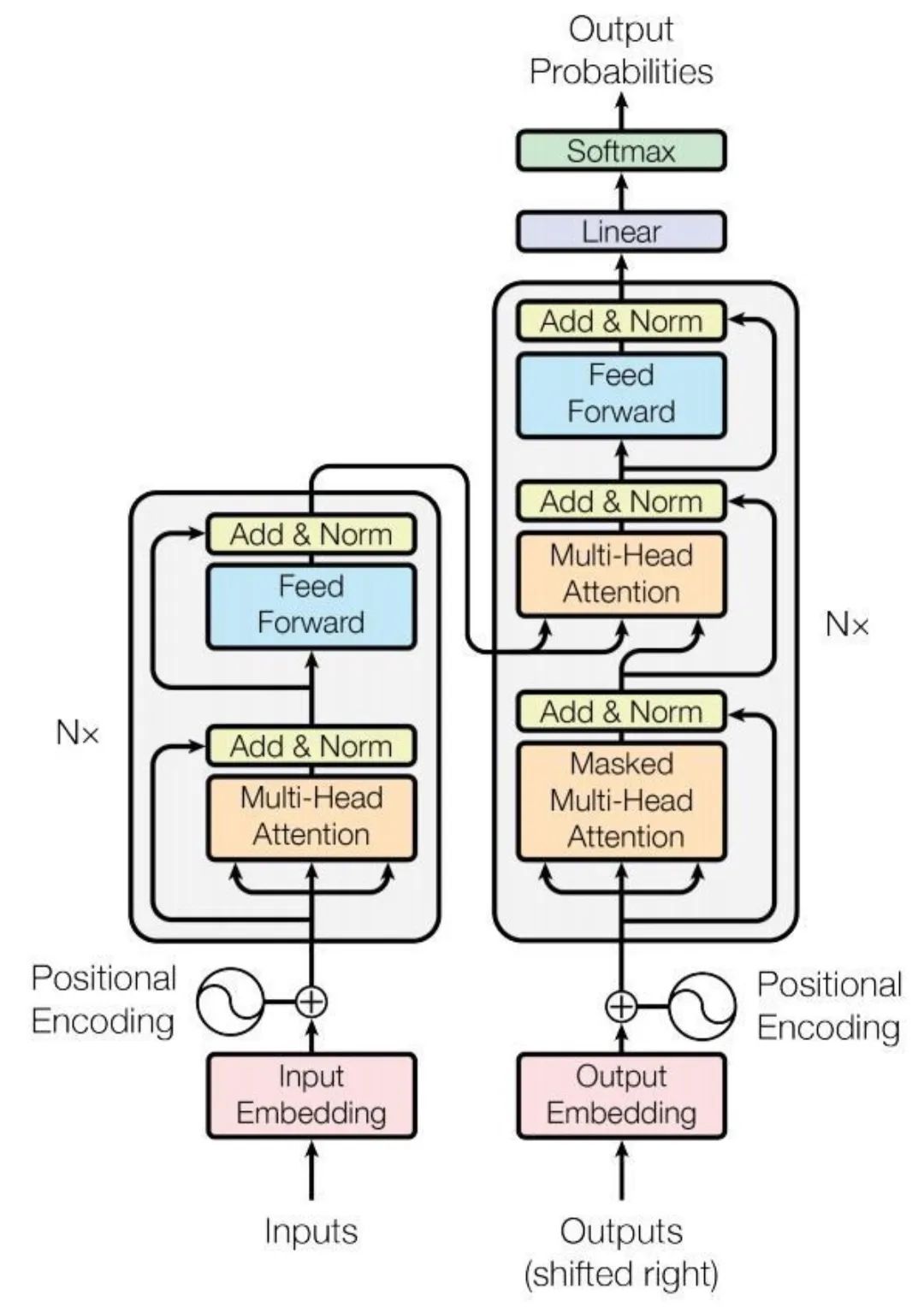

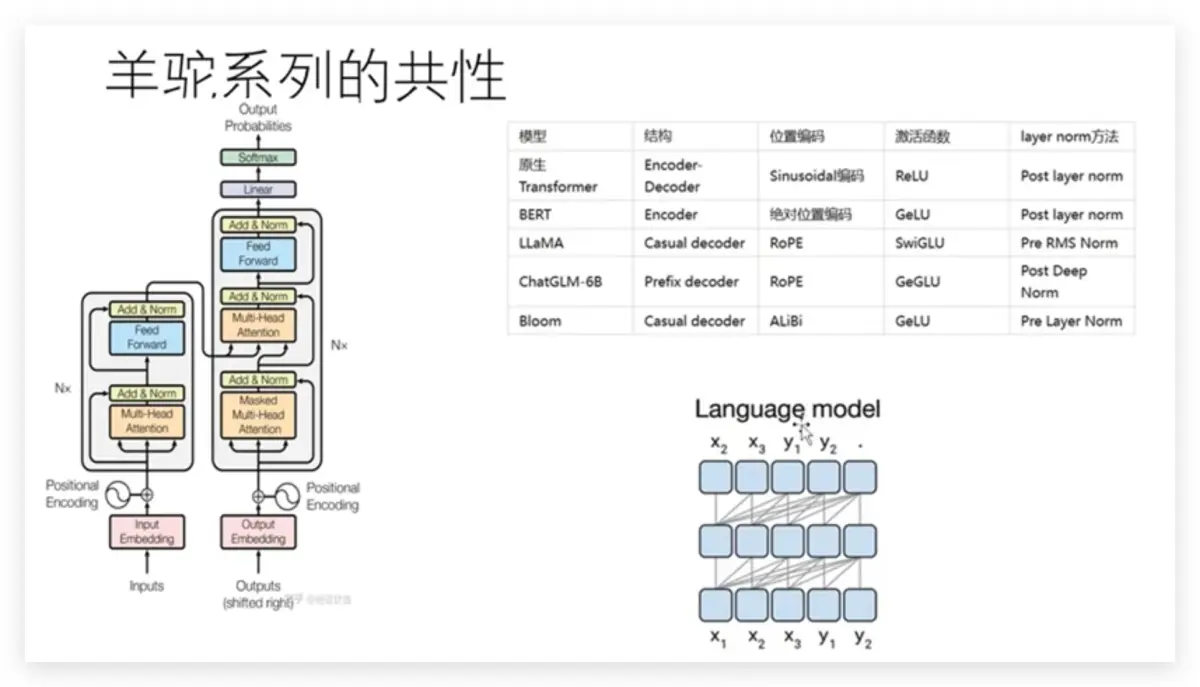

2023年,让整个人类最为振奋的AI技术就是ChatGPT。“大语言模型(Large Language Model)”这个词也随之映入人们的眼帘。ChatGPT让人觉得惊艳之处,能够结合上下文,像人一样有逻辑性地回答问题,就算生成超长的文本也不会跑偏。)是一种机器学习算法,它可以根据给定文本来预测下一个词语或字符的出现的概率,通过大量的文本数据来学习语言的统计特征,进而生成具有相似统计特征的新文本

2023年中开始,各大LLM厂商开始关注到长上下文的问题。2023年5月,Claude把长度支持到100k tokens;6、7月的时候,ChatGPT3.5也已经支持16k,而ChatGLM2-B最大长度已经可以到32k。(插一句,ChatGLM系列做得一直很不错,从基础模型、长窗口、工具调用、Agent都一直保持在比较前沿的水平,个人最近用ChatGLM3、ChatGLM4体验还是很不错的)差