简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

Traceback (most recent call last):File "pg2drg2pg.py", line 259, in post2DrgAndGetSqldata = json.dumps(i_params)File "/usr/local/python3/lib/python3.6/json/__init__.py", line 231, in dumps...

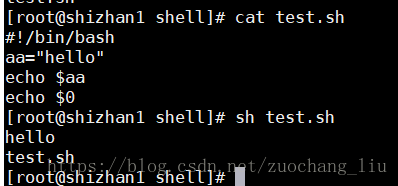

目录1 shell介绍1.1 什么是shell1.2 shell脚本的执行方式2 shell中的变量2.1 系统变量2.2定义变量2.3 将命令的返回值赋给变量2.4 特殊变量3 运算符4 流程控制4.1 for循环4.2 while循环4.3 case4.4 if判断4.5 常用判断条件5 read命令6 shell自定...

目录一 Scala概述1.1 什么是scala1.2 为什么要学scala1.3 Spark函数式编程初体验二 Scala开发环境2.1 安装JDK2.2 安装Scala2.2.1 Windows安装Scala编译器2.2.2 Linux中安装Scala编译器2.3 IDEA安装2.4 Scala插件离线安装2.5 IDEA创建Scala工程...

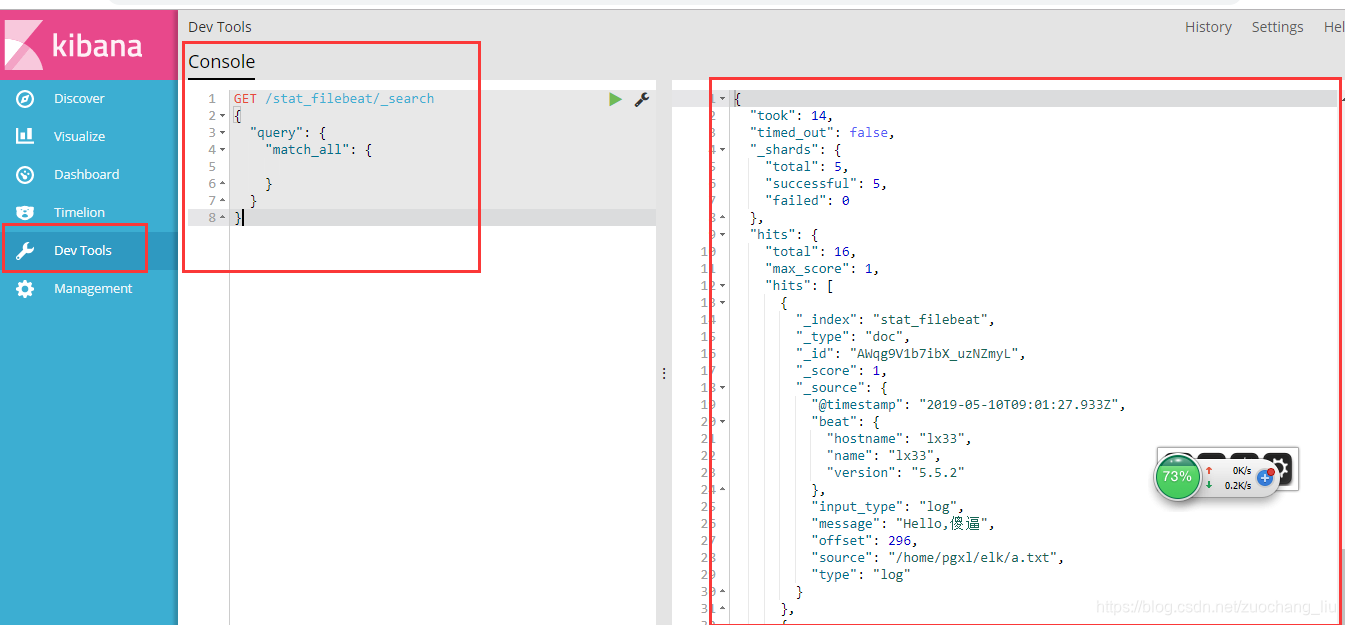

日志采集的工具有很多种,如logagent, flume, logstash,betas等等。首先要知道为什么要使用filebeat呢?因为logstash是jvm跑的,资源消耗比较大,启动一个logstash就需要消耗500M左右的内存,而filebeat只需要10来M内存资源。常用的ELK日志采集方案中,大部分的做法就是将所有节点的日志内容通过filebeat送到kafka消息队列,然后使用l

目录一 什么是HBASE二 安装HBASE三 hbase初体验四 HBASE客户端API操作五 HBASE运行原理5.1 master职责5.2 Region Server 职责5.3 zookeeper集群所起作用5.4 HBASE读写数据流程5.5 hbase:meta表5.6 Region Server内部机制一 什么是HBASEH...

Traceback (most recent call last):File "pg2drg2pg.py", line 259, in post2DrgAndGetSqldata = json.dumps(i_params)File "/usr/local/python3/lib/python3.6/json/__init__.py", line 231, in dumps...

目录pom.xml1.自动提交偏移量(默认)2.手动提交偏移量3.Mysql管理偏移量3.1 建表语句3.2 配置文件3.3代码4.Redis管理偏移量pom.xml<?xml version="1.0" encoding="UTF-8"?><project xmlns="http://maven.apache.org/P...

pom.xml<!--Licensed to the Apache Software Foundation (ASF) under oneor more contributor license agreements.See the NOTICE filedistributed with this work for additional informationregarding copyrig

日志采集的工具有很多种,如logagent, flume, logstash,betas等等。首先要知道为什么要使用filebeat呢?因为logstash是jvm跑的,资源消耗比较大,启动一个logstash就需要消耗500M左右的内存,而filebeat只需要10来M内存资源。常用的ELK日志采集方案中,大部分的做法就是将所有节点的日志内容通过filebeat送到kafka消息队列,然后使用l

日志格式:{"Q1":62442457475833333,"Q2":2016811232228686,"date":1556186700487}logstash配置文件:input {kafka {zk_connect => "localhost:2181"group_id => "test"topic_id => "test"...