简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

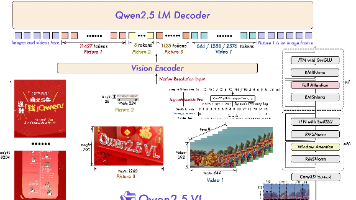

本文深入解析了Qwen2.5-VL模型的chat_template处理机制,通过代码追踪揭示了从输入消息到格式化文本的转换过程。文章首先展示正常调用时如何通过processor.apply_chat_template()处理包含图片和文本的混合消息,然后层层深入分析了transformers库中的实现路径,最终定位到通过jinja2模板渲染的核心逻辑。作者还提供了伪代码形式的模板结构说明,详细解释

在Web开发中,处理大文件下载或实时数据推送时,传统的一次性响应往往会占用大量内存。本文将介绍如何使用Flask的Response对象结合g对象实现高效的流式输出。

ERNIE-DOC: A Retrospective Long-Document Modeling TransformerGitHub论文目的因为随着长度的增加,transformer的内存和时间消耗成倍增加,所以transformer不适合处理长文本。简单的截断文档或使用稀疏attention并不能解决这个问题,提出ERNIE-DOC:一种基于循环transformer的文档级语言预训练模型,由

在Web开发中,处理大文件下载或实时数据推送时,传统的一次性响应往往会占用大量内存。本文将介绍如何使用Flask的Response对象结合g对象实现高效的流式输出。

大家好,今天继续我们的"每天一个Python小技巧"系列。今天给大家分享Python中生成混淆矩阵的几种实用方法,帮助大家更好地评估分类模型性能。混淆矩阵是机器学习中非常重要的评估工具,它能直观展示模型的分类效果。

之前写的等文章还是有不少人看的,NLP基本就是这样的处理流程了(当然有我还没发现的模型架构,比如说RWKV),这次尝试从Minicpm-V出发,将代码改写成我们熟悉的样子。

看到关于attn_mask给出了一个新的源文件,里面包含了创建4d_causal_attention源码,那是怎么实现的呢,一起来看一下吧。

与Qwen1.5-14B-Chat如何从输入到输出-代码解析一致,这里使用的是RepetitionPenaltyLogitsProcessor,Deepseek-llm中的代码要做一下修改从输入到输出的逻辑是没有发生变化的。