简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

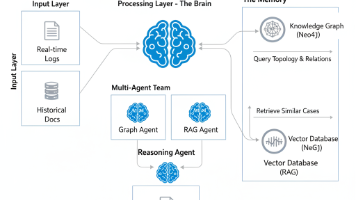

摘要:本文提出了一种融合多智能体协作(Multi-Agent)、检索增强生成(RAG)和知识图谱(Knowledge Graph)的前沿AI架构。该架构通过定义分诊台、内科医生、外科医生等角色化Agent,结合Neo4j图谱数据库的结构化关系推理和向量数据库的非结构化文档检索能力,形成完整的故障诊断解决方案。文章详细阐述了数据层构建方法、Agent角色定义及协作流程,并针对Text-to-Cyph

编码模型是 RAG 的 “核心组件”,本质是 “将非结构化数据(文本、图像等)映射为低维 / 高维向量” 的工具,向量的相似度直接决定检索精度 —— 向量越能体现数据的语义 / 特征,检索结果越精准。GraphRAG 通过图结构知识表示和增量更新机制认知维度升级:从片段化理解到结构化认知,支持复杂推理应用场景拓展:从简单问答到企业级复杂分析 (金融风控、医疗诊断、法律推理等)运维效率提升:增量更新

1. 掌握Python/C++编程语言,熟练使用TensorFlow/Pytorch等训练框架。1、参与分布式大模型训练框架研发,加速模型的训练和推理,提高训练的稳定性,确保模型的高效迭代;3. 有深度学习基本知识,熟悉LLM/SLM/Transformer/Bert等模型结构更佳。2、调研最新技术和性能调优工具,编写算子和CUDA内核,持续提升框架的资源利用效率和易用性;2. 善于分析、解决工程

可视化动图教学,带你走进高科技数据报表

计算机设计大赛人工智能实践赛材料填写模板

计算机设计大赛人工智能挑战赛填写模板规范文档,文末附链接

Hadoop安装教程(单机/伪分布式配置)

Transformer是一种基于自注意力机制(self-attention)的神经网络架构,由论文《Attention is All You Need》提出。其核心创新在于通过并行化的注意力机制替代传统的RNN/LSTM,有效捕捉长程依赖关系,并成为BERT、GPT等里程碑模型的基础架构。Transformer由多头注意力、位置编码、前馈网络等模块组成,支持编码器-解码器、仅编码器或仅解码器等多种

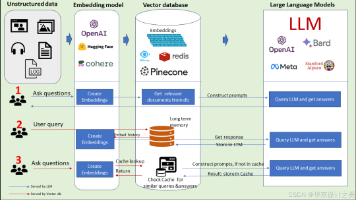

检索增强LLM(RAG)结合了传统信息检索和大语言模型优势,通过外部数据库为LLM提供实时、精准的上下文信息。相比传统LLM,RAG显著提升长尾知识处理能力,支持私有数据查询,保证信息新鲜度,并增强回答可解释性。其核心模块包括数据索引、查询检索和响应生成,支持文档检索、用户记忆增强和缓存优化三种模式。RAG无需修改模型参数即可实现知识更新,比预训练和微调方案更经济高效,尤其适合企业知识库、个性化咨

信息总体来源于王道考研信息贴,多为学生贡献内容,真实性有待考证。。。