简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

LLM Compressor 6 是一个易于使用的库,目标是优化大语言模型以便使用 vLLM 进行部署。它能够实现高达 5 倍的推理速度提升,并显著降低成本。作为一个综合性的工具包,我们在前面已经通过 QLoRA、PEFT、RLHF 等技术,体验了在单机单卡甚至消费级显卡上完成大模型微调的可能性。但如果目标从“微调一个 7B 模型”升级为从零预训练、全量微调甚至训练万亿参数模型,仅靠量化与 LoR

LLM Compressor 6 是一个易于使用的库,目标是优化大语言模型以便使用 vLLM 进行部署。它能够实现高达 5 倍的推理速度提升,并显著降低成本。作为一个综合性的工具包,我们在前面已经通过 QLoRA、PEFT、RLHF 等技术,体验了在单机单卡甚至消费级显卡上完成大模型微调的可能性。但如果目标从“微调一个 7B 模型”升级为从零预训练、全量微调甚至训练万亿参数模型,仅靠量化与 LoR

【CANN训练营】Ascend 910实现LeNet网络的minist手写数据训练

定义 LoRA 配置r=16,# 应用配置,获得 PEFT 模型输出信息# 推荐操作:关闭缓存可提高训练效率# 定义训练参数fp16=True, # 启用混合精度训练# 数据整理器,用于处理批量数据# 实例化 Trainer# 开始训练关键的训练参数per_device_train_batch_size & gradient_accumulation_steps:这两个参数共同决定了有效批量大小(

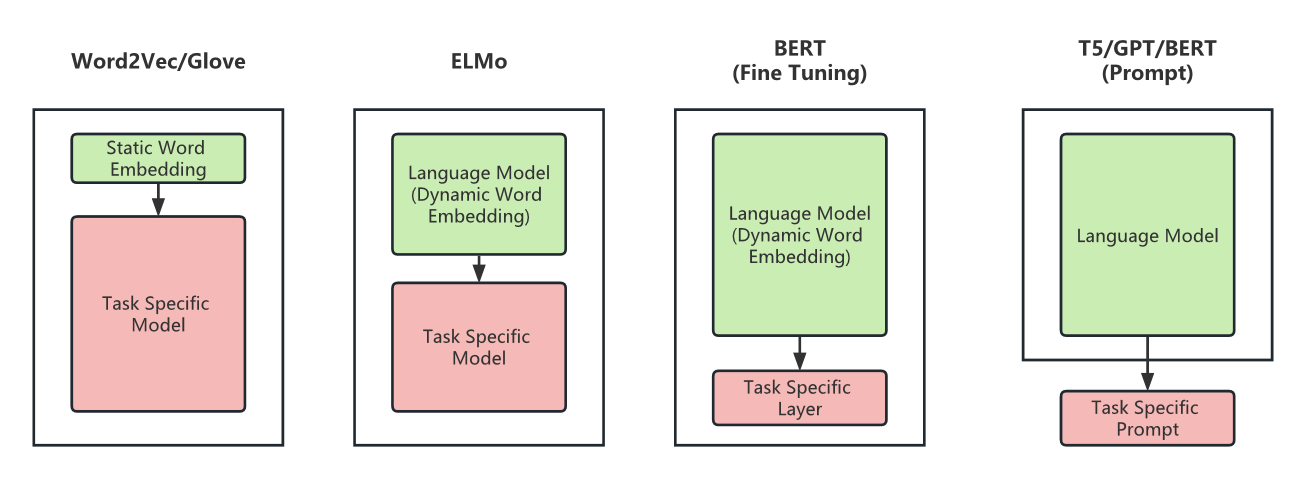

为了对人类语言的内在规律进行建模,研究者们提出使用语言模型(language model)来准确预测词序列中 下一个词 或者 缺失的词 的概率。

Llama2 遵循了 GPT 系列开创的 Decoder-Only 架构。这意味着它完全由 Transformer 解码器层堆叠而成,天然适用于自回归的文本生成任务。

自然语言处理(Natural Language Processing, NLP) 是人工智能(AI)领域的重要组成部分,它赋予计算机 理解、解释、生成人类语言 的能力,并基于这些能力对文本数据进行决策 1。NLP 旨在弥合人类交流的模糊性、情境性和复杂性与计算机精确、形式化的指令系统之间的鸿沟。例如,计算机需要理解"我今天很蓝",这里的"蓝"并非颜色,而是情绪的表达——这对于机器来说是个挑战。

2018年Google发布了BERT(来自Transformer的双向自编码器)预训练模型,旨在通过联合左侧和右侧的上下文,从未标记文本中预训练出一个深度双向表示模型。因此,BERT可以通过增加一个额外的输出层来进行微调,就可以达到为广泛的任务创建State-of-the-arts 模型的效果,比如QA、语言推理任务。当时将预训练模应用于下游任务的策略通常有两种:基于特征的(feature-bas

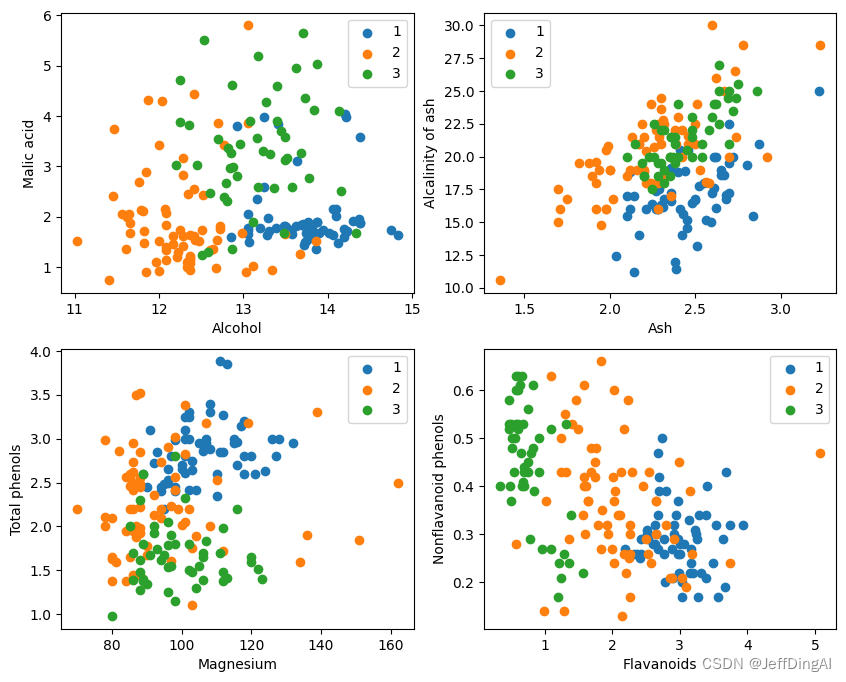

K近邻算法(K-Nearest-Neighbor, KNN)是一种用于分类和回归的非参数统计方法,最初由 Cover和Hart于1968年提出(Cover等人,1967),是机器学习最基础的算法之一。它正是基于以上思想:要确定一个样本的类别,可以计算它与所有训练样本的距离,然后找出和该样本最接近的k个样本,统计出这些样本的类别并进行投票,票数最多的那个类就是分类的结果。KNN的三个基本要素:K值,

在下面的教程中,我们将通过示例代码说明DCGAN网络如何设置网络、优化器、如何计算损失函数以及如何初始化模型权重。在本教程中,使用的共有70,171张动漫头像图片,图片大小均为96*96。