简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

Prompt Tuning与P-Tuning方法对比 Prompt Tuning和P-Tuning是两种参数高效微调方法,通过小规模可训练提示向量适配下游任务。Prompt Tuning(Google提出)仅在输入层添加可学习的虚拟token嵌入,训练参数量少但性能依赖预训练模型能力。P-Tuning(清华团队)最初采用连续嵌入替代离散提示(v1),改进版P-Tuning v2在Transform

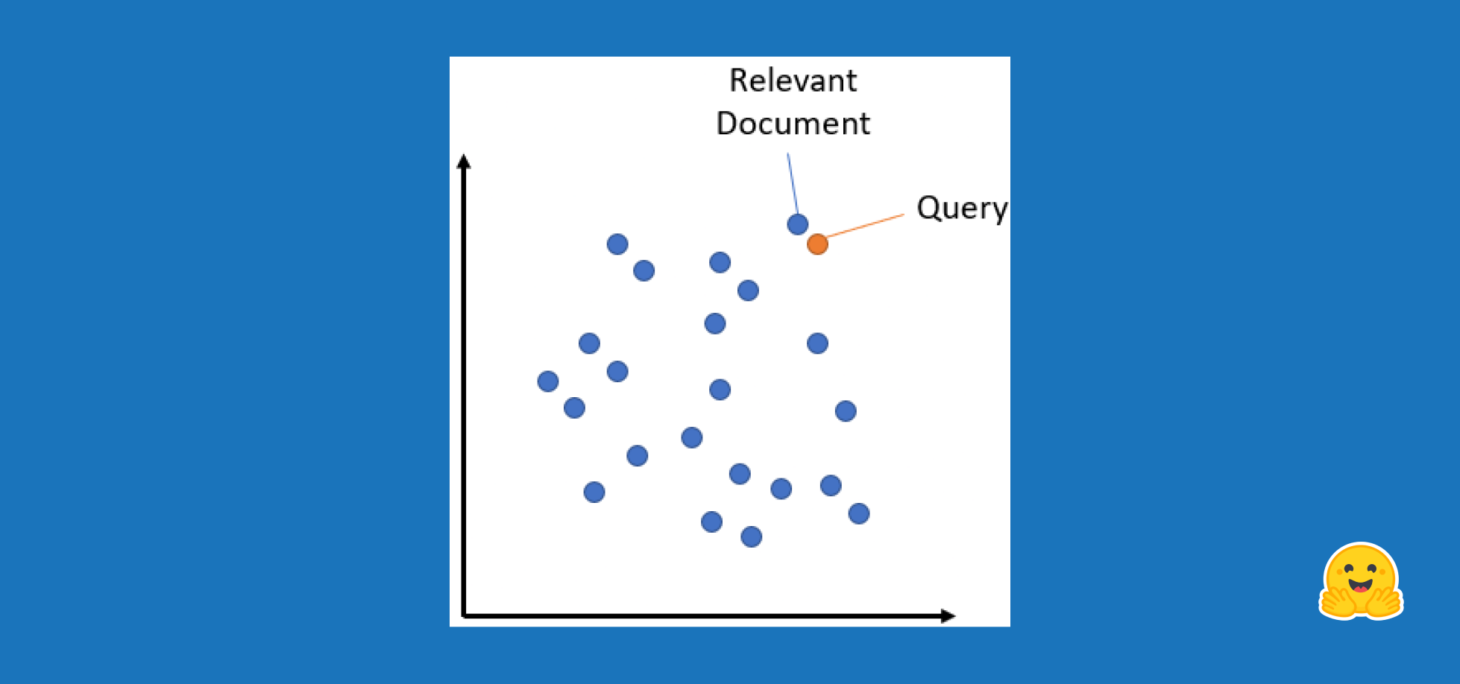

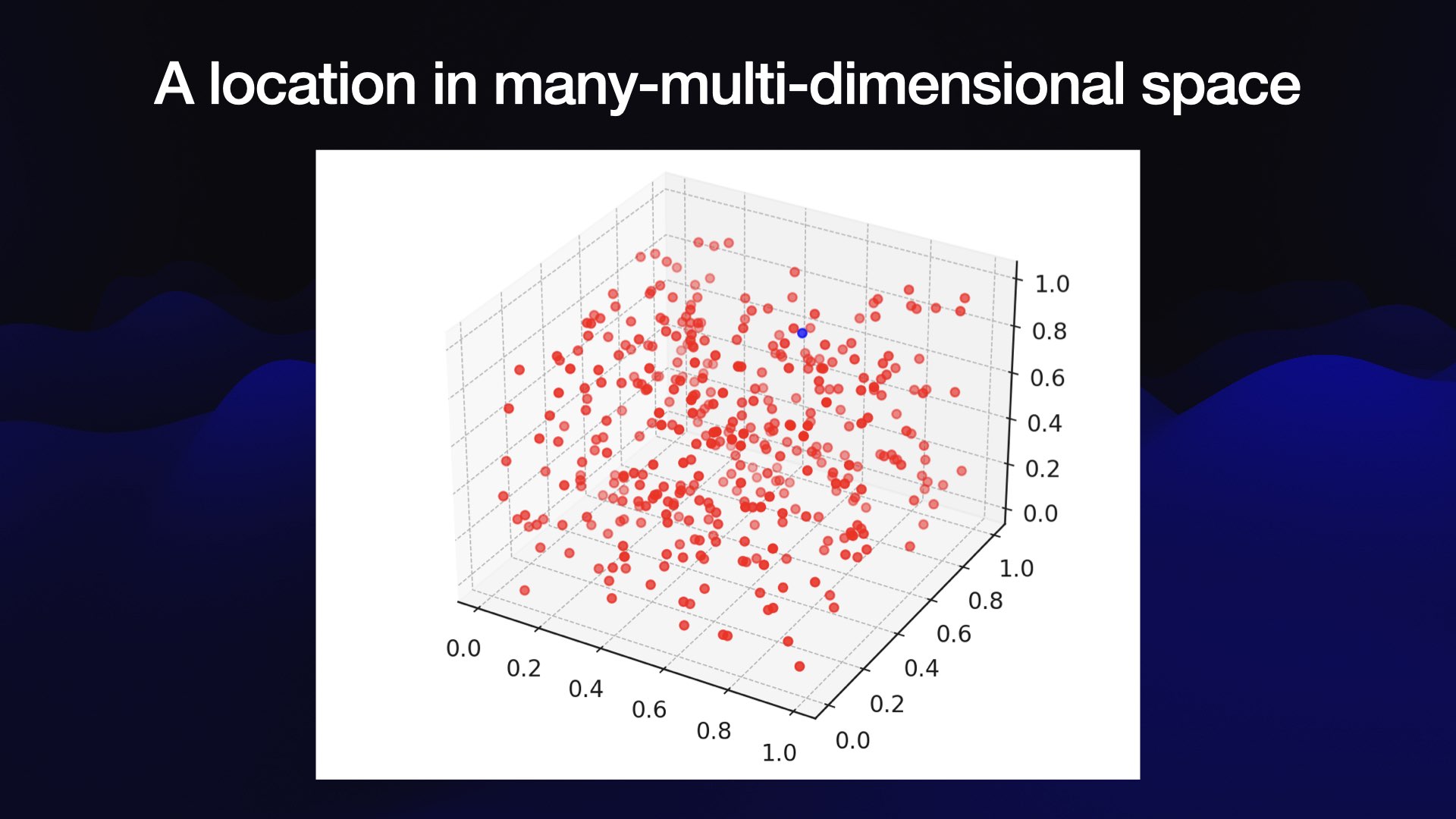

多么美妙的旅程啊!我们只是将句子嵌入从 0 变为 1。我们了解了它们是什么、如何计算它们、如何比较它们以及如何缩放它们。我们还看到了嵌入的一些很酷的应用,例如语义搜索和释义挖掘。我希望这篇博文能让您很好地理解什么是句子嵌入以及如何使用它们。这是该系列的第一部分。还需要学习什么?向量数据库的作用如何将嵌入用于更复杂的排名系统主题建模Multimodality 多模态如何训练自己的嵌入模型关于 RAG

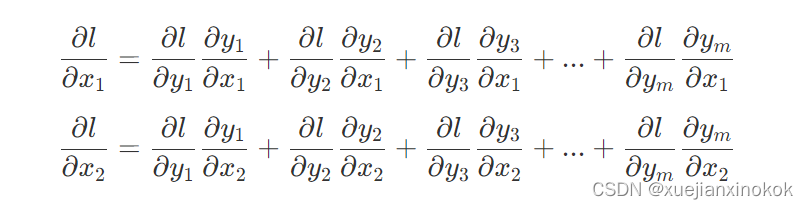

PyTorch 的Autograd功能是 PyTorch 灵活快速地构建机器学习项目的一部分。它允许在复杂计算中快速轻松地计算多个偏导数(也称为梯度)。该操作是基于反向传播的神经网络学习的核心。autograd 的强大之处在于它在运行时动态跟踪你的计算,这意味着如果你的模型有决策(判断)分支,或者只有在运行时才知道长度的循环,计算仍然会被正确跟踪,你会得到正确的梯度来驱动学习。

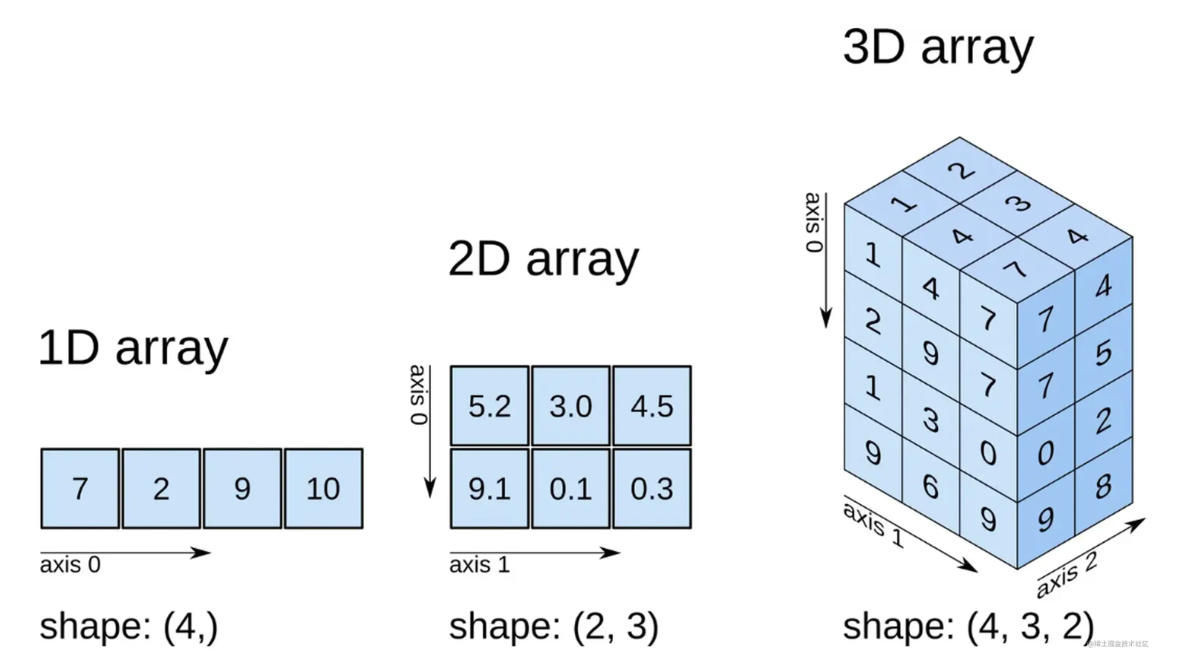

张量是一种特殊的数据结构,与数组和矩阵非常相似。在 PyTorch 中,我们使用张量对模型的输入和输出以及模型的参数进行编码。张量类似于ndarray,除了张量可以在 GPU 或其他硬件加速器上运行。事实上,张量和 NumPy 数组通常可以共享相同的底层内存,从而无需复制数据(请参阅)。张量也针对自动微分进行了优化(我们将在稍后的部分中看到更多相关内容)。如果您熟悉 ndarrays,那么您对 T

这篇文章是关于存储缓冲区的,我们从暂停的地方继续。存储缓冲区在许多方面类似于统一缓冲区。如果我们所做的只是将 JavaScript 中的 UNIFORM 更改为 STORAGE 并将 WGSL 中的 var 更改为 var ,那么上一页中的示例就可以正常工作。其实区别就在这里,不用重命名变量就可以有更合适的名字。${${在我们的 WSGL 中无需其他更改即可正常工作,就像以前一样。

从顶点着色器开始,因为 GPU 也将从这里开始!顶点着色器被定义为函数,GPU 会针对中的每个顶点调用一次该函数。由于包含六个位置(顶点),因此您定义的函数会被调用六次。每次调用该方法时,都会将中的其他位置作为参数传递给该函数,顶点着色器函数的作用是在裁剪空间中返回对应的位置。也务必要理解,系统不一定会按顺序调用它们。相反,GPU 擅长并行运行上述着色器,这可能会同时处理数百(甚至数千!)顶点!G

利用 Tokio、Tower 和 Hyper 建立强大的生态系统。很棒的开发者经验。仍处于 0.x 版本,因此可能会发生重大更改。强大、独立的生态系统。通过主要版本保证实现稳定的 API。很棒的文档。丰富的内置功能。不像以前那样积极发展。对于初学者来说仍然是一个不错的选择。Functional approach. 函数式方法。Very expressive. 非常富有表现力。靠近 Tokio、To

有许多库可以在 Rust 中输出日志,有时很难选择该使用哪一个。当println!dbg!和eprintln!无法解决问题时,找到一种方便记录日志的方法就很重要,尤其是在生产级应用程序中。本文将帮助您深入了解在 Rust 日志记录方面最适合您的用例的日志 crate。

向量嵌入是一项与更广泛的大型语言模型领域相关的技术——ChatGPT 和 Bard and Claude 背后的技术。向量嵌入基于一个技巧:获取一段内容(在本例中为博客条目)并将该内容转换为浮点数数组。该数组的关键在于,无论内容有多长,它的长度始终相同。长度由您使用的嵌入模型定义 - 数组的长度可能是 300、1,000 或 1,536 个数字。思考这个数字数组的最好方法是将其想象为一个非常奇特的

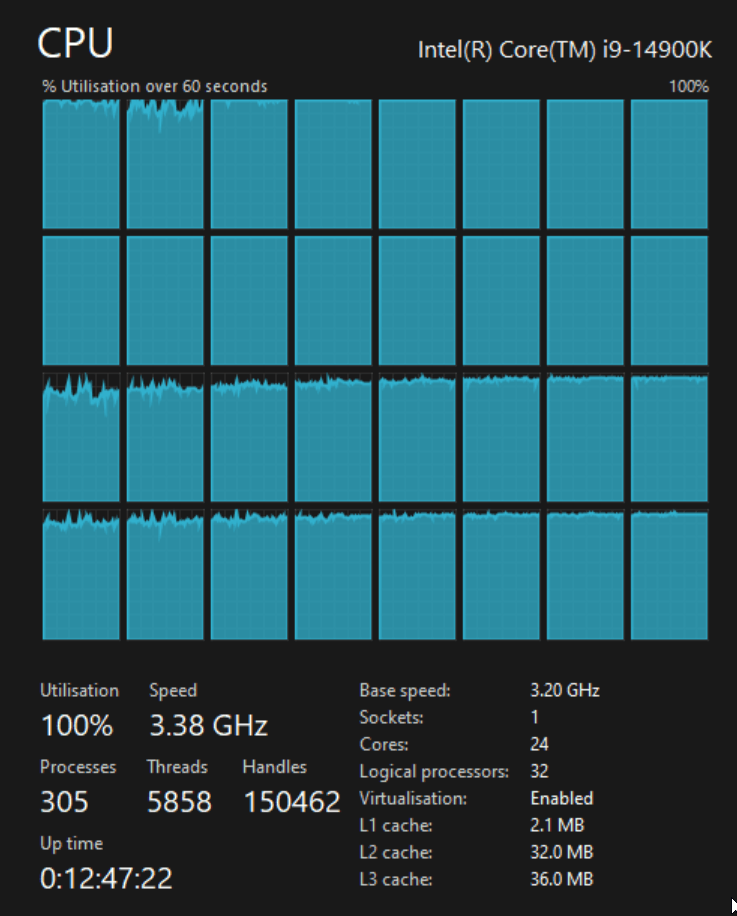

如果您想知道为什么我不运行基于 Linux 的桌面作为我的主要工作环境,我仍在使用 Nvidia GTX 1080 GPU,它在 Windows 上有更好的驱动程序支持,并且我时不时地使用 ArcGIS Pro仅原生支持 Windows。SSD 的写入速度为 50-150 MB/s,读取速度通常为 5-10 MB/s,而 CPU 几乎处于空闲状态,为 5-10%。因此,我将在更快的驱动器上运行基准