简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

它将信息检索的范围从文本扩展到图像、视频等视觉信息,让 AI 在生成内容时,不仅能参考文本,还能“看到”相关的图像,从而更好地理解用户的意图,生成更生动、更贴近用户需求的内容。RAG,即检索增强生成,顾名思义,就是在生成文本内容时,先进行信息检索,然后将检索到的相关信息作为上下文,输入给大语言模型(LLM),从而生成更准确、更丰富的答案。最近我打算做一个AI+文旅赛道的应用去参加比赛,但是这其中很

TEN-Agent是一个特别有意思的项目,也相当成熟,实现了比较完善的语音通话和视频聊天的集成平台,当然基础的ai聊天和绘画都已经包含在内了,并且可以接入自己的coze和dify,想象力很大!

最近Deepseek的r1模型在国内外火的没边,也是借着这股东风,想要深入了解一下RL对于LLM的增强效果到底有多强!在大语言模型(LLM)的应用中,我们也经常会遇到模型输出质量不稳定的问题。有时候回答过于简单,缺乏具体细节;有时候又过于发散,难以聚焦核心内容。本实验旨在探索如何通过强化学习(特别是PPO算法)来优化LLM的输出质量。

在人工智能技术飞速发展的当下,AI生图工具已成为设计师、内容创作者乃至普通用户突破创意瓶颈的利器。本文基于深度实测体验,精选五款**「零门槛、高质量且完全免费」**的AI生图平台——Krea、Le Chat、即梦、Gemini、混元,助你快速生成专业级视觉作品,平常给公众号配文根本不在话下!

智谱清言Realtime API的开放,为开发者提供了强大的实时交互能力,但是目前真正的尝试和代码实现我们还没见到多少,所以欢迎大家在评论区分享你的实现过程!(不想再看哪个文档第二眼hh)

Mermaid 是一种基于文本的图表绘制工具,它使用简单的 Markdown 语法,就可以绘制出各种精美的图表。而 Cursor 作为一款强大的 AI IDE,可以完美地集成 Mermaid,让你在编写代码的同时,轻松绘制流程图。这段代码定义了一个简单的流程:从“开始”到“处理”,经过“判断”,如果判断为“是”则“结束”,否则回到“处理”步骤。但是,传统的流程图绘制工具往往操作繁琐,需要花费大量的

TEN-Agent是一个特别有意思的项目,也相当成熟,实现了比较完善的语音通话和视频聊天的集成平台,当然基础的ai聊天和绘画都已经包含在内了,并且可以接入自己的coze和dify,想象力很大!

我在假期为了完成写综述的任务,深度体验和对比了多款学术论文Agent。其中有几款给我留下的印象很深,效果也是相当不错。下面我用“AI治理”为主题让这几款Agent进行PK!

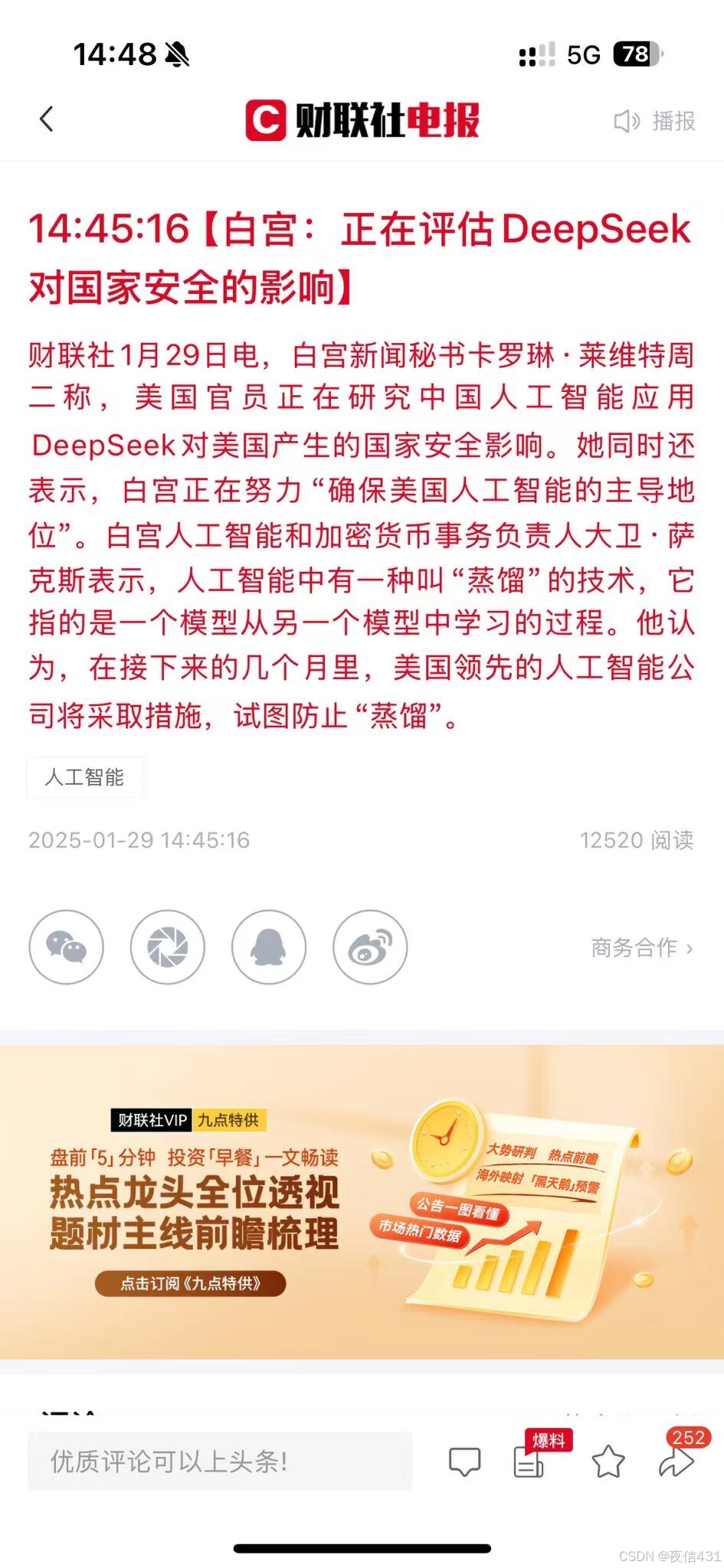

大模型输出的不是简单的答案(比如“1+1=2”),而是一个概率分布(比如“1+1=2的概率是99%,等于3的概率是0.8%……提到“蒸馏”大家可能还比较陌生,但是提到deepseek大家很熟悉,正是deepseek彻底点燃了蒸馏大模型这个概念!在LLM领域,这是解决“大模型好用但难部署”的关键技术,也是当前AI落地的重要方向。温度越高,大模型的输出越“柔和”(比如更愿意给出多种可能性),小模型能学

最近Deepseek的r1模型在国内外火的没边,也是借着这股东风,想要深入了解一下RL对于LLM的增强效果到底有多强!在大语言模型(LLM)的应用中,我们也经常会遇到模型输出质量不稳定的问题。有时候回答过于简单,缺乏具体细节;有时候又过于发散,难以聚焦核心内容。本实验旨在探索如何通过强化学习(特别是PPO算法)来优化LLM的输出质量。