简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本文详细介绍了Claude的Agent Skills功能,这是一种扩展大模型能力的模块化解决方案。Skills通过文件系统架构实现渐进式信息披露,包含元数据、指令和资源三级加载,有效降低上下文成本。文章深入探讨了Skills的优势、架构设计、使用方法、安全考虑及跨平台部署策略,帮助开发者将通用AI助手转变为特定领域的专家工具,提升工作效率和专业能力。

Agent Skills智能体技能:让AI成为你的"数字老师傅",小白也能轻松上手!

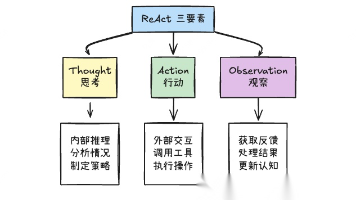

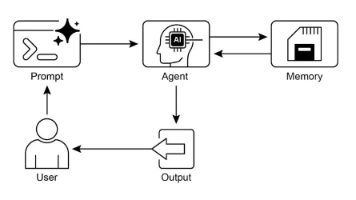

ReAct是一种结合推理(Reasoning)与行动(Acting)的大语言模型架构,通过交替进行内部思考和外部行动形成闭环反馈系统。它解决了纯CoT无法处理实时信息、外部计算和数据查询等局限性。核心是思考→行动→观察→再思考的循环,具有工具增强、闭环反馈和动态规划等特点,能显著提升模型在复杂任务上的表现和可解释性。

前言Android确实不是当年盛况,已经不再像前几年前那么火爆。一个新行业如果经历过盛极一时,那么必然有这样的一条曲线,像我们学的正弦曲线先急速上升,然后到达顶点,然后再下降,最后再趋近一个平稳的值。那么这一两年就已经是在一个饱和值之间浮动,因此在这样的形式下,可能对于个人开发者相应的要求就要高一些。以前是只要你会Android四大组件的都是个香饽饽,那样的时代已经过去了,随着人机交互的体验要求,

文章批判了B端智能体落地中常见的"巨无霸"单智能体误区,提出多智能体微服务协同架构理念,将智能体设计为专业化分工的"数字员工"团队。通过中央调度器和标准化协作机制,实现复杂业务的高效处理,解决单智能体在复杂性、专业度和维护方面的三大困局。这种架构不仅降低系统复杂度、提升专业深耕和可维护性,还能实现资产化沉淀,推动智能体从演示工具向生产力系统转变。

文章介绍了智能体设计中的反思模式,这是一种让智能体对自身输出进行评估并自我纠错的机制。通过"执行-评估-优化"的闭环,智能体从被动执行升级为主动优化。文章详细阐述了反思模式的概念、价值、实现流程和关键要点,特别是"生产者-批评者"双智能体模型的应用。这种模式能显著提升输出质量,减少人工修正成本,帮助智能体实现自我进化,适合复杂场景应用。

本文系统介绍了21种智能体设计模式,包括提示链、路由、并行化、反思等,这些模式是构建高效智能体的基础。智能体设计的关键在于多种模式的巧妙组合而非单一应用。文章详细阐述了每种模式的原理、价值与关键技术,并展示了如何通过模式组合构建复杂智能体系统,为开发者提供了体系化的智能体开发工具箱。

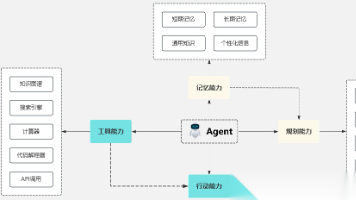

智能体记忆管理分为短期记忆(当下任务衔接)和长期记忆(长期经验复用),两者协同是高效运作的关键。多智能体场景下需通过分层存储架构(共享记忆池+私有记忆库)、统一通信协议、记忆治理和权限管控解决信息共享、一致性和安全问题。向量数据库是实现长期记忆高效检索的关键技术,良好的记忆管理能让智能体从"能干活"升级为"会干活"。

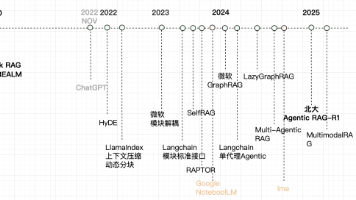

本文全面梳理大语言模型从2017年Transformer到2025年的技术发展历程,包括预训练、对齐、多模态、推理等关键阶段,详解RAG和Agent应用的设计模式与发展,提供构建方法与适用场景,为开发者提供系统性学习框架。

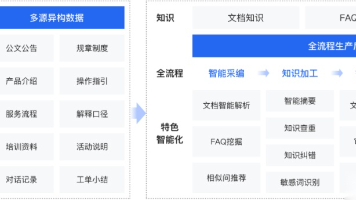

文章强调知识库是RAG系统的核心和生命线,其质量直接决定智能问答系统的效果。知识库管理不仅是简单的文档切片和向量化,而是一套复杂系统,需处理多数据源、多格式文档,并进行标准化处理。完善的知识库系统需具备数据更新、版本管理、召回优化等功能,通过模块化架构设计实现。随着数据量增长,知识库架构设计变得至关重要,它是大模型时代的基础,能提升RAG系统的稳定性和扩展性。