简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本文介绍了阿里Xvector说话人确认模型在中文环境下的安装配置问题。由于模型版本较老,与最新Python包存在兼容性问题,作者通过多次尝试找到了匹配的依赖版本。关键配置包括Python 3.8、Torch 1.13,以及特定版本的datasets(2.8.0)和modelscope(1.6.0)。文章详细列出了完整的依赖包清单,涵盖音频处理、机器学习等100多个必要组件,为使用该模型的开发者提供

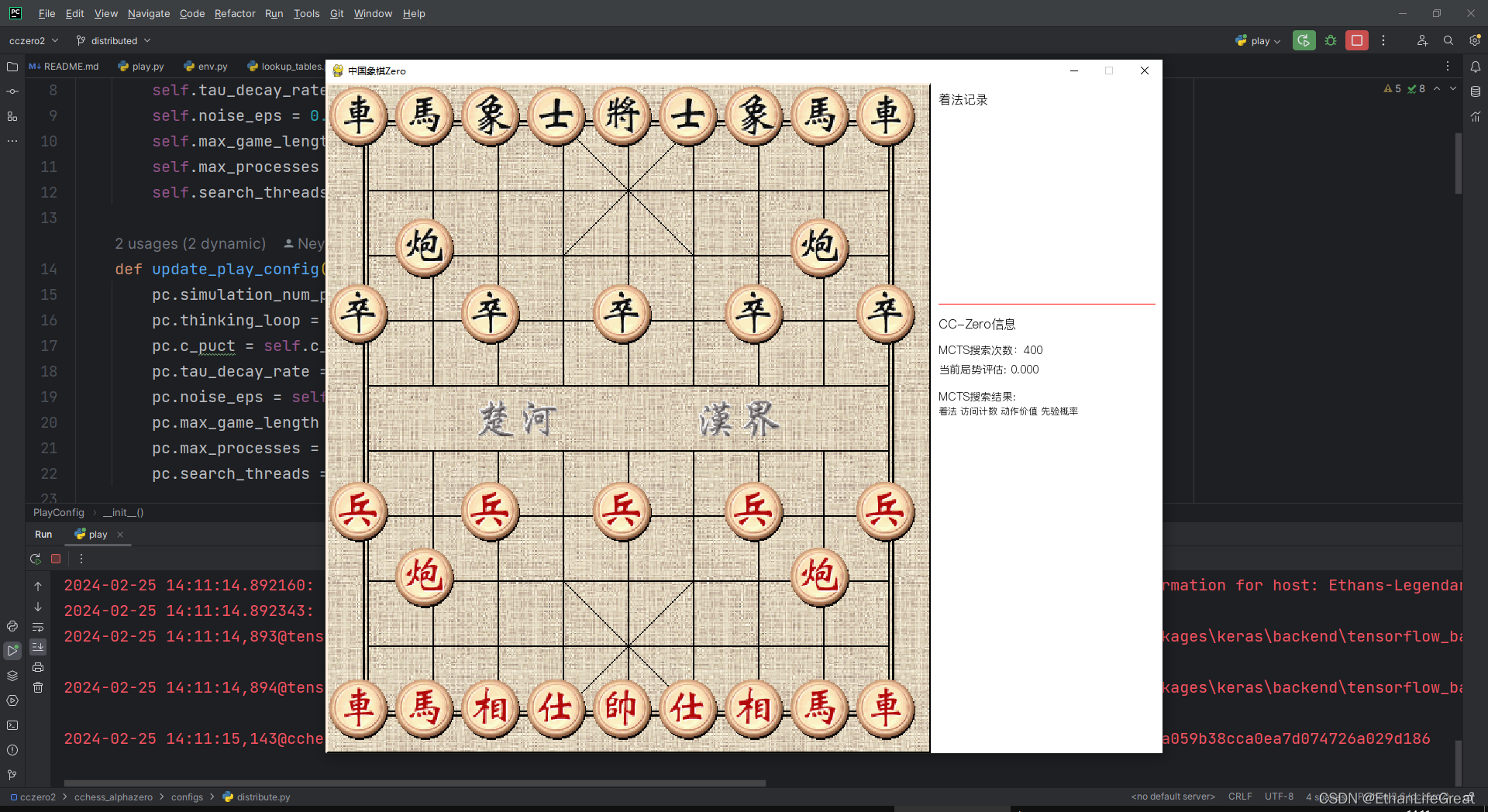

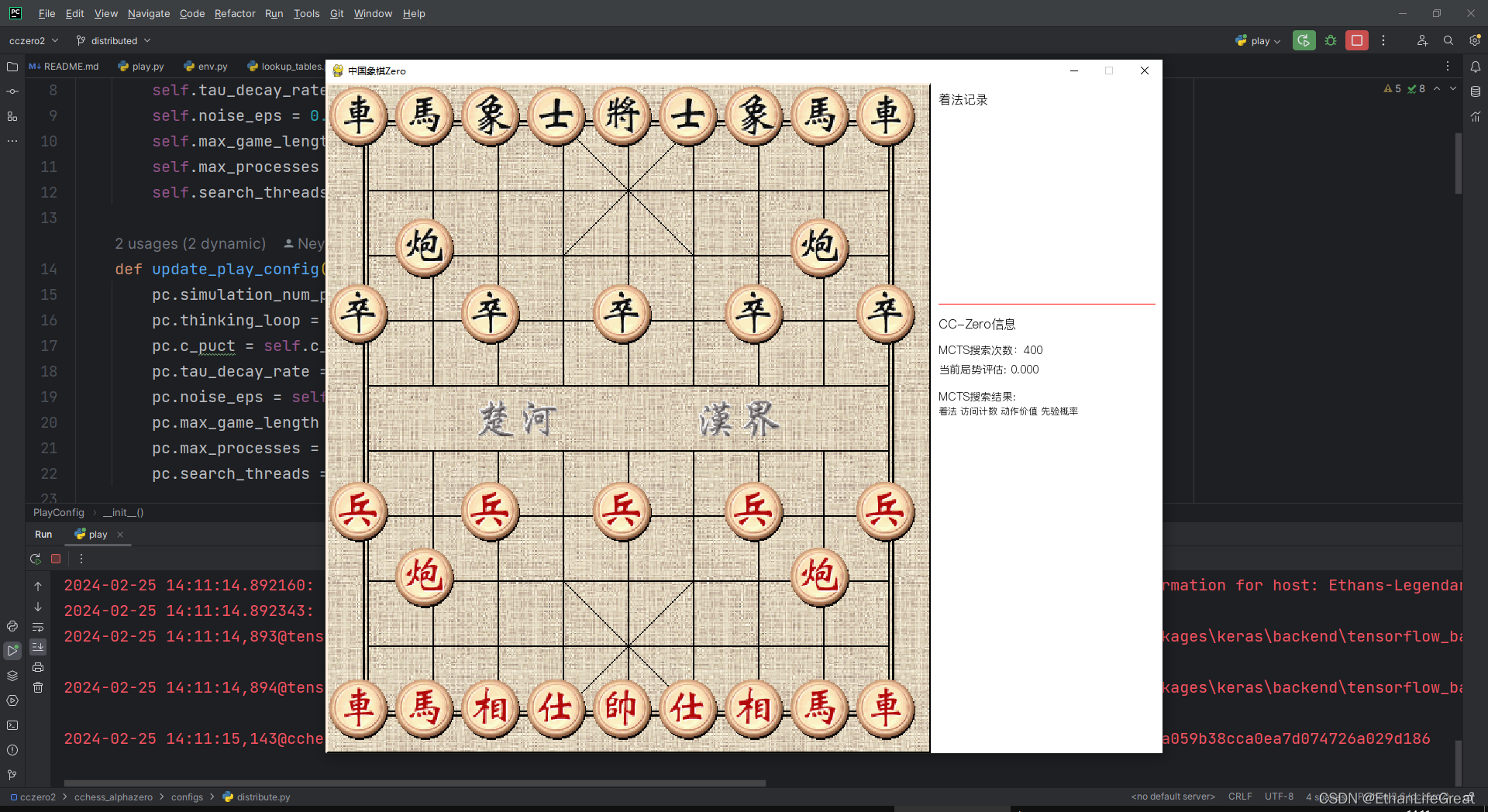

棋力天天象棋业9-1的Github/Gitee开源中国象棋AI程序。

本文记录了多卡部署72B通义千问过程,将推理速度提到10token/s水平。

棋力天天象棋业9-1的Github/Gitee开源中国象棋AI程序。

棋力天天象棋业9-1的Github/Gitee开源中国象棋AI程序。

棋力天天象棋业9-1的Github/Gitee开源中国象棋AI程序。

下面是Hugging Face transformer版的千问2,token生成速度在15个每秒左右,但还不够快,在这篇文章里我们用vLLM将速度翻倍,达到38tokens/s。做了Qwen1的加速,其中关于Auto-GPTQ的安装问题在Qwen2中依然适用。可以看到,短上下文的处理速度达到了恐怖的38.7tokens/s,与官方给出的A100速度基本持平。相比于开头的transformer版本,

本文记录了多卡部署72B通义千问过程,将推理速度提到10token/s水平。

下面是Hugging Face transformer版的千问2,token生成速度在15个每秒左右,但还不够快,在这篇文章里我们用vLLM将速度翻倍,达到38tokens/s。做了Qwen1的加速,其中关于Auto-GPTQ的安装问题在Qwen2中依然适用。可以看到,短上下文的处理速度达到了恐怖的38.7tokens/s,与官方给出的A100速度基本持平。相比于开头的transformer版本,

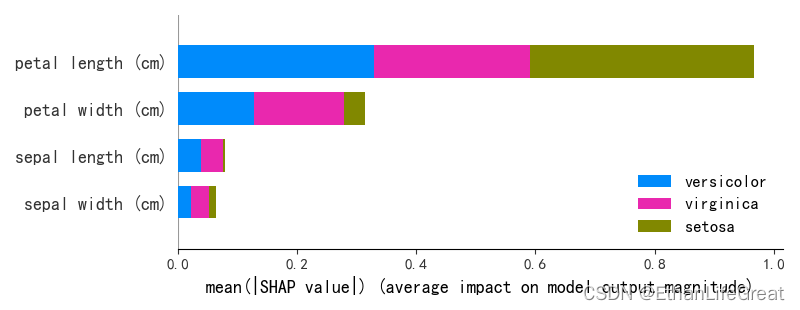

多分类任务中使用shap.summary_plot展示各个特征对模型输出类别的重要性。