简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

TF-IDF = 词频 × 逆文档频率TF衡量词语在当前文档的重要性IDF衡量词语的独特性/区分度TF-IDF综合两者,提取真正有区分度的关键词。

Warnings:specified.训练样本:3345 个油井测井数据显著地球物理参数:AC(声波时差)、K(钾含量)参数分布特征:多数测井参数呈现右偏分布,符合地质统计规律。

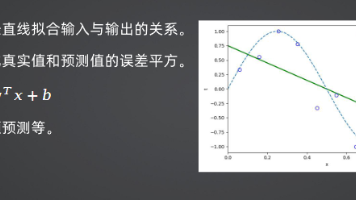

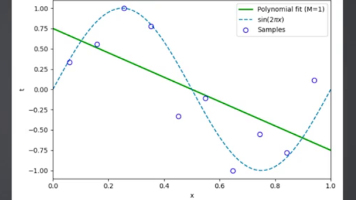

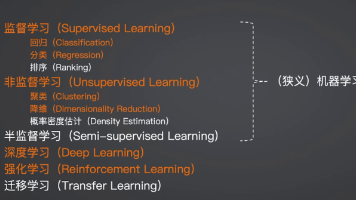

回归选线性回归/决策树系,看是否需要非线性拟合;分类按数据规模/维度选逻辑回归/朴素贝叶斯/KNN/SVM/决策树系;聚类优先K-means,降维优先PCA。后续我们将针对每类算法展开实战教程,包括代码实现、调参技巧和业务落地案例,帮你从“懂理论”到“能落地”。

使用带标签的数据集训练模型。你可以把它理解为“学生做有答案的练习题”:每个训练样本都包含“输入数据(题目)+ 对应输出标签(答案)”,模型的目标是学习“输入→输出”的映射规律,学成后就能给新的“题目”(未见过的输入数据)给出正确“答案”(预测结果)。使用无标签的数据集训练模型。类比到学习场景,这就像“学生分析一堆没有答案的原始数据,自己总结规律”:训练数据只有输入信息,没有预设的输出标签,模型的目

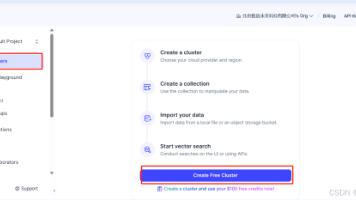

Dify是由国内团队开发的开源大语言模型应用开发平台,定位为“LLM App Development Platform”。它将大模型应用开发的全流程(Prompt工程、数据集管理、应用发布、运营分析)整合到统一界面,支持私有化部署,既能满足企业级的安全需求,也能降低个人开发者的AI应用开发门槛。

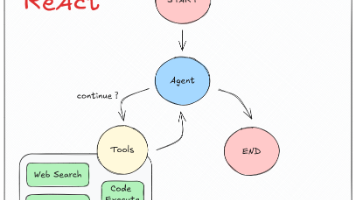

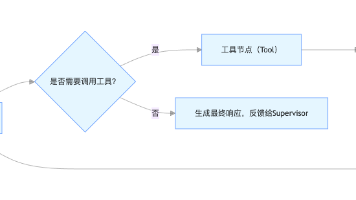

ReAct(Reasoning + Acting)是一种让智能体“先思考、再行动”的交互模式,核心逻辑是**“思考→工具调用→结果反馈→再思考”**的循环,完美契合复杂任务的分步执行需求。透明化决策:代理会明确思考“是否需要调用工具”“调用哪个工具”,而非直接输出结果;可回溯纠错:若工具调用失败或结果不满足需求,代理可基于反馈调整策略,重新尝试;灵活适配多工具:支持同时绑定多个工具,根据任务需求动

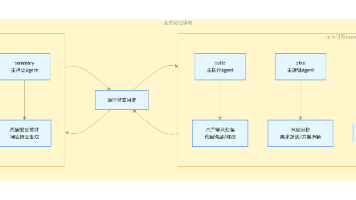

用户发起代码开发相关需求,由前台可见的build、plan、general、explore Agent承接,通过调用标准化工具完成核心业务处理。每个任务Step执行完毕后,自动触发summary Agent进行代码变更统计与摘要生成,同时联动title Agent生成会话标题。系统实时监控Token资源使用情况,当资源接近模型上限时,触发compaction Agent执行会话压缩,保障模型稳定运

Step 7: 定义 AgentStatenext: str# Step 8: 创建 vec_kg Agent 节点Answer:""",知识截止日期固定(训练数据年份)无法访问私密数据容易产生幻觉(编造答案)文档处理:加载 → 分割 → 向量化知识存储:向量数据库集成检索增强:基于语义的精准匹配智能生成:RAG Chain 组合多代理集成:LangGraph 框架应用📚 企业知识库问答💼 产

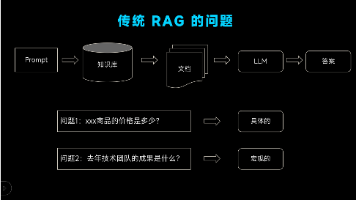

GraphRAG(Graph Retrieval-Augmented Generation)是传统 RAG 的进阶形态,核心是将非结构化文本转化为结构化知识图谱,基于图谱的实体、关系、拓扑结构实现「语义 + 结构化推理检索」,结合大模型生成精准、全面、有逻辑的答案。其将图谱构建、图谱检索推理、结构化上下文重构、大模型生成深度融合为端到端流程,实现从“片段式检索” 到 “结构化推理”的升级,核心解决

LangGraph中的主要图类型是StateGraph。每个节点通过State中的参数获取有效信息,执行完节点的内部逻辑后,更新该State状态中的值。不同的状态模式,可以通过注释设置状态的特定属性(例如覆盖现有值)或添加到现有属性。设置边缘条件,有条件的原因是,根据节点的输出,可以采用多个路径之一。在该节点运行之前,所采用的路径是未知的(由大模型决定)。条件边缘:调用代理后,如果代理说要采取行动