简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

print(f"使用 join() 方法耗时: {end_time - start_time:.4f} 秒")print(f"原始字符串是否改变: {str4 is str_strip}")# 输出: False。print(f"使用 + 操作符耗时: {end_time - start_time:.4f} 秒")print(f"原始字符串 ID: {id(original)}")print(f"

print(f"使用 join() 方法耗时: {end_time - start_time:.4f} 秒")print(f"原始字符串是否改变: {str4 is str_strip}")# 输出: False。print(f"使用 + 操作符耗时: {end_time - start_time:.4f} 秒")print(f"原始字符串 ID: {id(original)}")print(f"

,增就是添加,删就是删除,查就是获取对象,包括单个和多个元素的获取(切片),改就是修改,下面具体地介绍一下各个数据结构的基本操作。括起来的部分,每一项包括2个子项,键key和值value,键一般是字符串,键值对用冒号(:)分开,每一项也是用逗号(,)分开。print(f"使用 join() 方法耗时: {end_time - start_time:.4f} 秒")print(f"使用 + 操作符耗

,增就是添加,删就是删除,查就是获取对象,包括单个和多个元素的获取(切片),改就是修改,下面具体地介绍一下各个数据结构的基本操作。括起来的部分,每一项包括2个子项,键key和值value,键一般是字符串,键值对用冒号(:)分开,每一项也是用逗号(,)分开。print(f"使用 join() 方法耗时: {end_time - start_time:.4f} 秒")print(f"使用 + 操作符耗

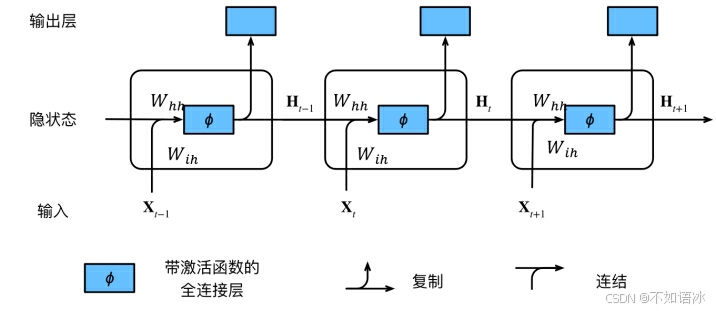

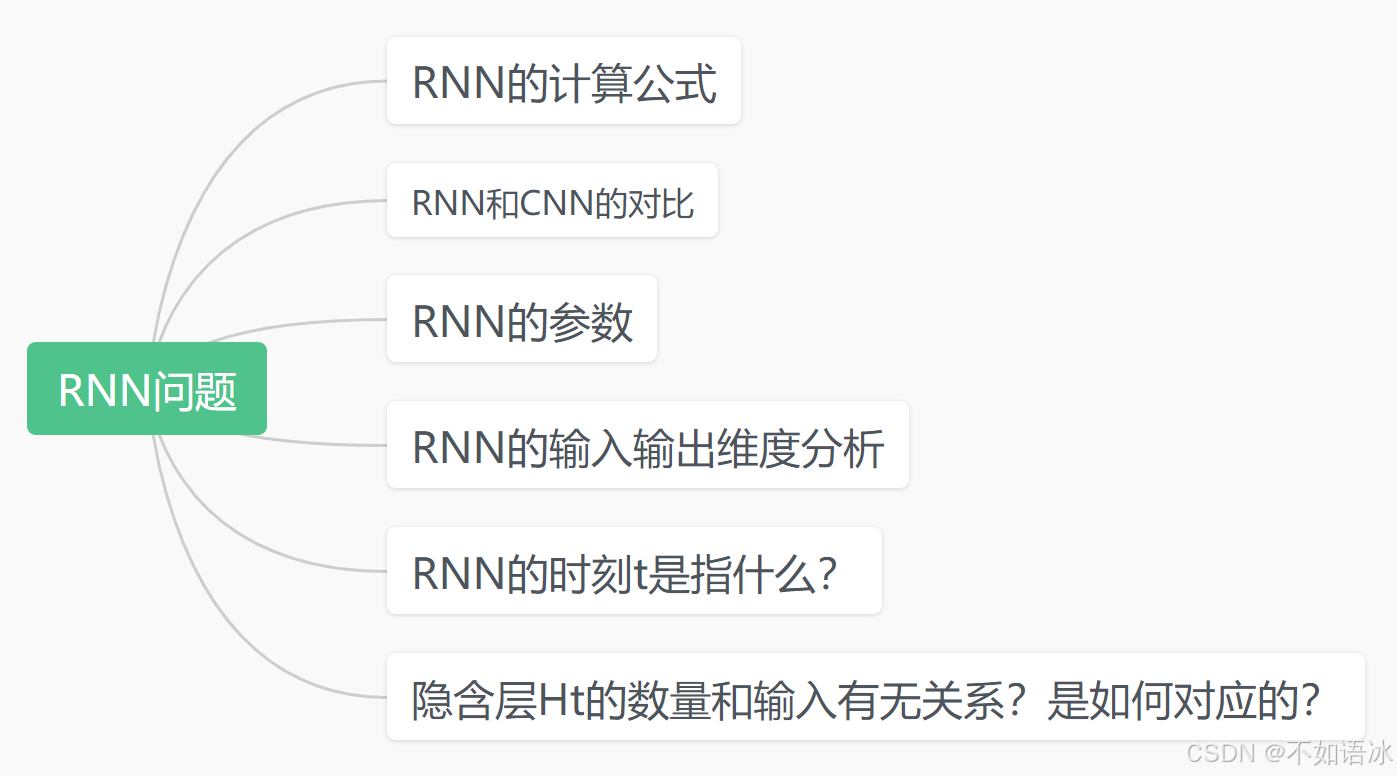

再来看一下序列T_seq和通道channel,RNN系列的序列T_seq是指一个连续的输入,比如一句话,一周的股票信息,而且这个序列是有时间先后顺序且互相关联的,而CNN系列的通道channel则是指不同角度的特征,比如彩色图像的RGB三色通道,过程中每个通道代表提取了每个方面的特征,不同通道之间是没有强相关性的,不过也可以进行融合。输入不是序列而输出为序列的情况怎么处理?但卷积神经网络并不能处理

以下是反向传播算法的基本步骤:正向传播:将输入特征通过网络前向传递,输出网络的预测值。计算预测误差:将网络的预测值与真实值(标签)代入损失函数,计算得到网络的预测误差。反向传播:根据链式法则,将输出层的预测误差回传到前面各层,逐层计算预测误差对每个参数的导数。计算参数更新值:根据预测误差对每个参数的导数,结合设置的超参数学习率,计算每个参数的更新量(一般是导数*学习率,这就是优化算法作用的位置,可

再来看一下序列T_seq和通道channel,RNN系列的序列T_seq是指一个连续的输入,比如一句话,一周的股票信息,而且这个序列是有时间先后顺序且互相关联的,而CNN系列的通道channel则是指不同角度的特征,比如彩色图像的RGB三色通道,过程中每个通道代表提取了每个方面的特征,不同通道之间是没有强相关性的,不过也可以进行融合。输入不是序列而输出为序列的情况怎么处理?但卷积神经网络并不能处理

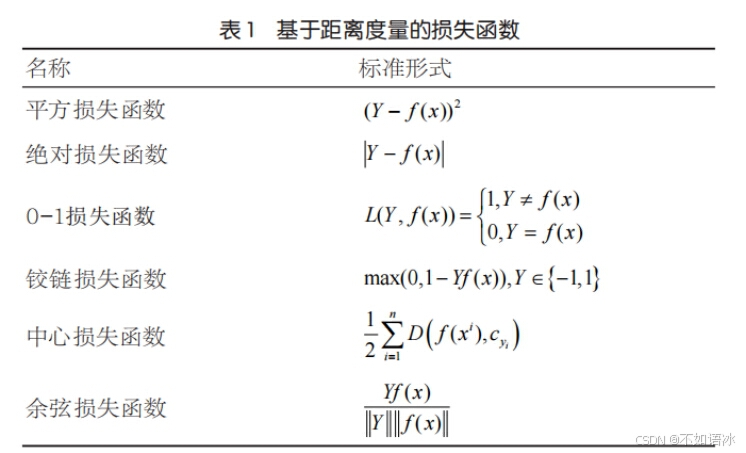

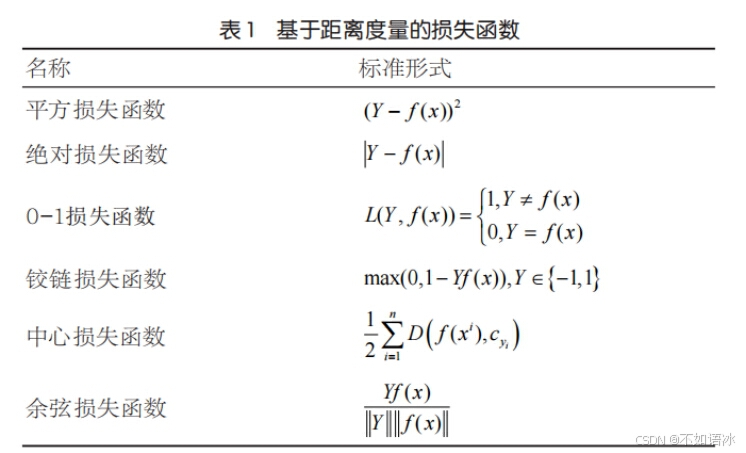

前面的文章我们已经从模型角度介绍了损失函数,对于神经网络的训练,首先根据特征输入和初始的参数,前向传播计算出预测结果,然后与真实结果进行比较,得到它们之间的差值。损失函数又可称为代价函数或目标函数,是用来衡量算法模型预测结果和真实标签之间吻合程度(误差)的函数。通常会选择非负数作为预测值和真实值之间的误差,误差越小,则模型越好。有了这个损失函数,我们便可以采用优化算法更新网络参数,使得训练样本的平

前面的文章我们已经从模型角度介绍了损失函数,对于神经网络的训练,首先根据特征输入和初始的参数,前向传播计算出预测结果,然后与真实结果进行比较,得到它们之间的差值。损失函数又可称为代价函数或目标函数,是用来衡量算法模型预测结果和真实标签之间吻合程度(误差)的函数。通常会选择非负数作为预测值和真实值之间的误差,误差越小,则模型越好。有了这个损失函数,我们便可以采用优化算法更新网络参数,使得训练样本的平

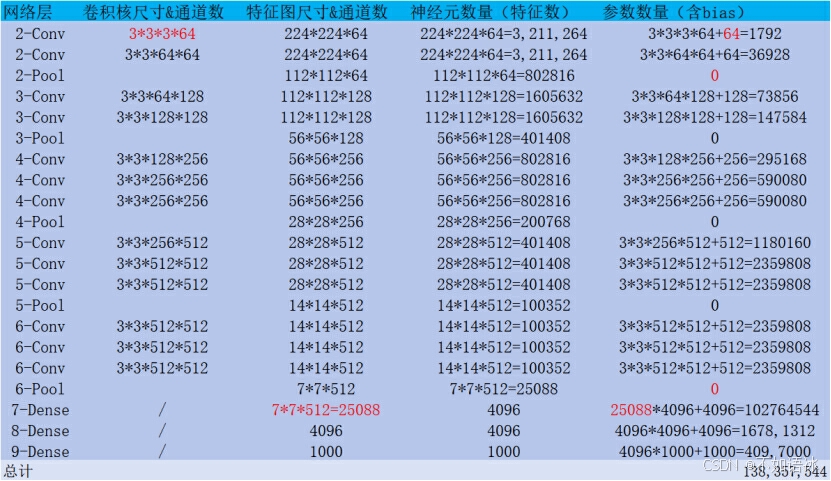

例如,在VGG中,使用了3个3x3卷积核(27个参数)来代替7x7卷积核(49个参数),使用了2个3x3卷积核来代替5*5卷积核,这样做的主要目的是在保证具有相同感知野的条件下,提升了网络的深度,在一定程度上提升了神经网络的效果。VGG网络层的深度是可调整的,其核心在于设计了多组卷积块,每组卷积块由多个相同的小尺寸(一般为3*3)的卷积核组成,卷积核填充为1,卷积核保持输入特征图的高和宽不变,然后