简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本文提出了T IME -LLM,一个将大型语言模型(LLMs)重新编程以进行时间序列预测的框架。该方法通过将时间序列数据转化为文本原型,结合Prompt-as-Prefix(PaP)技术,增强了LLMs对时间序列的推理能力。实验结果表明,T IME -LLM在多个基准测试中超越了现有的专用预测模型,尤其在少样本和零样本学习场景中表现优异,展示了LLMs在时间序列预测中的潜力。

2024年3月份,亚马逊研究团队用于预训练概率时间序列模型的新颖框架,旨在用过利用现有的基于transformer的语言模型来简化时间序列预测任务,并进行最少的修改。

GPU:图形处理单元,最初设计用于处理图像和视觉渲染任务,但随着技术的发展,GPU也被广泛用于并行计算任务,特别是在深度学习和大规模数据处理领域。通常用于执行程序的流程控制和数据处理,CPU通常包含少量的核心(通常4-32个),每个核心能够处理复杂的任务和多任务操作。CUDSS:库函数,实现矩阵分解,但是性能不是很好,性能不稳定,分解的结果很随机,无法实现多卡并联。ORLM:可以私有化部署,任何基

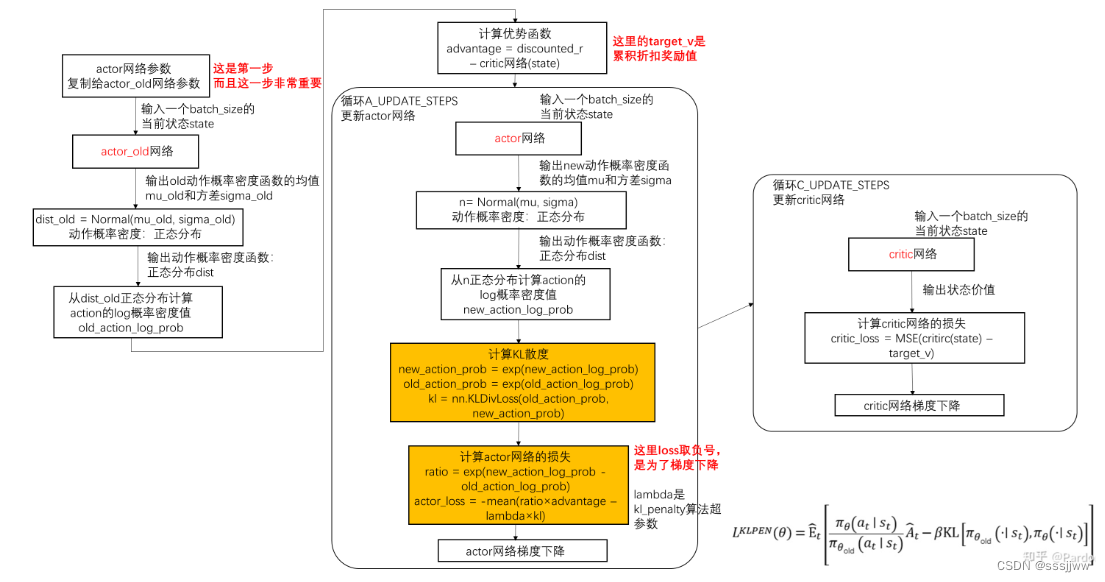

使用状态值函数和优势函数计算Q,为防止网络输出优势函数A的期望不为0,需要减去A的期望,由于动作无穷多,通过采样计算均值来估计A的期望。结合了演员-评论家方法和经验回放的算法,是一种带经验回放的off-policy的actor-critic模型,A3C是on-policy的,其实 ACER 是 A3C 的off-policy 版本。②实时学习:由于它使用当前策略的数据,因此同策略学习通常需要实时与

通常可以用马尔可夫决策过程来定义强化学习任务,并将其表示为四元组,分别是状态集合、动作集合、状态转移函数和奖励函数,假设这四元中组中所有元素已知,且状态集合和动作集合在有限步数内是有限集,则机器学习可以对真实环境进行建模,通过学习状态转移函数来构建一个虚拟环境,以模拟真实环境的状态和交互和反映,这就是。然而在实际应用中,智能体并不是那么容易就能知晓马尔可夫决策过程中的所有元素的,通常情况下,状态转

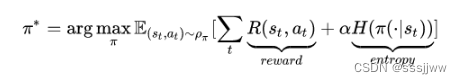

不仅想要长期的回报最大,还想要policy的每一次输出的action的熵最大,这样做是为了让策略随机化,也是在鼓励探索,为具有相似的Q值的动作分配近乎均等的概率,不会给动作范围内任何一个动作分配非常高的概率,避免了反复选择同一个动作而陷入次优。SAC算法是一种现代的深度强化学习算法,它结合了基于策略的和基于价值的方法。随机策略stochastic policy:在给定状态时,不会总是产生相同的动作

GPU:图形处理单元,最初设计用于处理图像和视觉渲染任务,但随着技术的发展,GPU也被广泛用于并行计算任务,特别是在深度学习和大规模数据处理领域。通常用于执行程序的流程控制和数据处理,CPU通常包含少量的核心(通常4-32个),每个核心能够处理复杂的任务和多任务操作。CUDSS:库函数,实现矩阵分解,但是性能不是很好,性能不稳定,分解的结果很随机,无法实现多卡并联。ORLM:可以私有化部署,任何基

统计方法分为和,参数估计和假设性检验是推断性统计中的重要部分。参数检验主要用于抽样研究方法,从总体中抽取一定的样本进行研究非参数性检验:无法准确假设时在用样本均值估计总体均值,或判断两个均值不相等的样本是否来自均值不同的总体时,要进行均值的比较检验。均值检验一般包括三部分内容:1.单一样本均值检验;2.独立样本均值检验;3.配对样本均值检验。

固德威与阿里,双方基于阿里云通义大模型及百炼平台共同打造新能源垂直领域大模型。应用场景:①客户咨询与服务②智能平台运营③智能运维④智能用户助力目前为止,大模型更多的是用在知识问答、辅助决策方面,像固德威智慧能源WE平台,他们算法方面,类似于光伏发电、负荷用电预测等还是采用的常见的机器学习方法进行的。